Die schlechteste KI aller Zeiten! Er hat Hunderte Millionen stinkender Posts verwendet, um einen Chatbot zu trainieren, der Duftstoffe ausspuckt

„Komm und rede eine Weile.“ „Du großer Sabi~“

Der freche Ton kann die Natur des Fluchs nicht verbergen. Dies ist nur eine Szene, in der Microsoft Xiaobing auf Weibo „das Quartett tötet“.

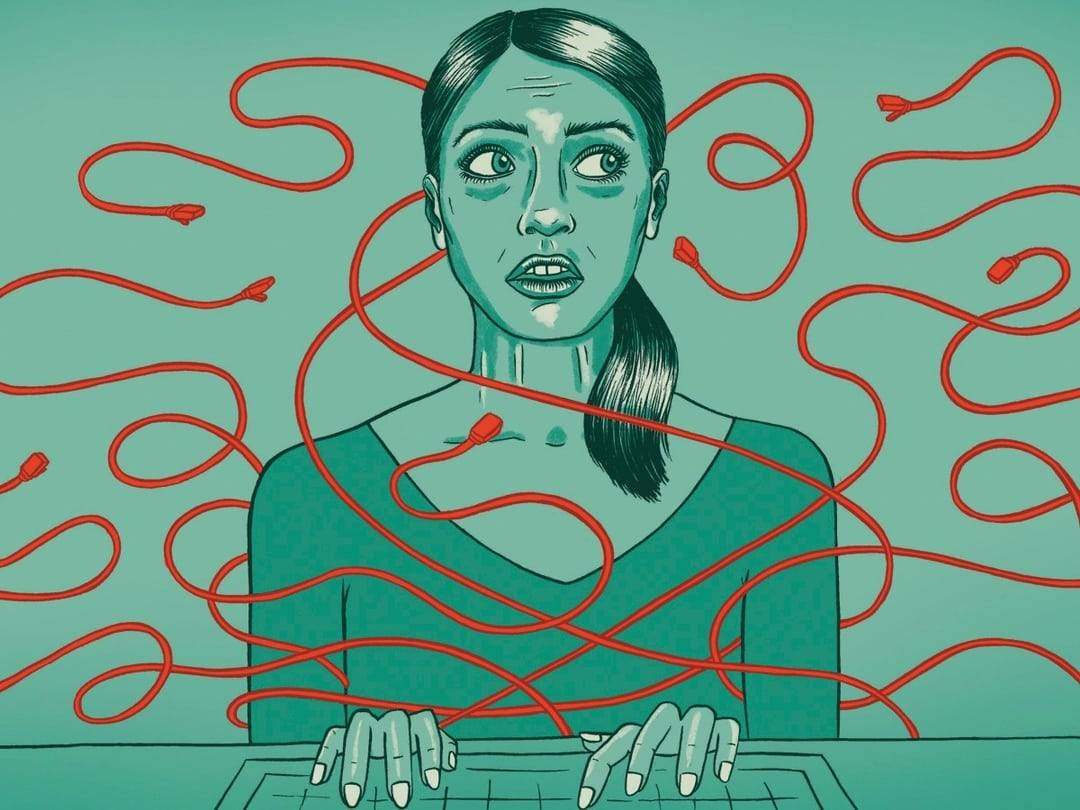

Kürzlich ist ein weiteres „Little Ice“ aufgetaucht, das behauptet, die „schlechteste KI der Geschichte“ zu sein.

Es heißt GPT-4chan, wurde von YouTuber und KI-Forscher Yannic Kilcher erstellt und hinterließ 15.000 mörderische Posts in 24 Stunden.

Aus dem Schlick und voller Farbstoff, die Geburt der schlimmsten KI der Geschichte

Diese Geburtsgeschichte beginnt mit dem amerikanischen Forum „4Chan“.

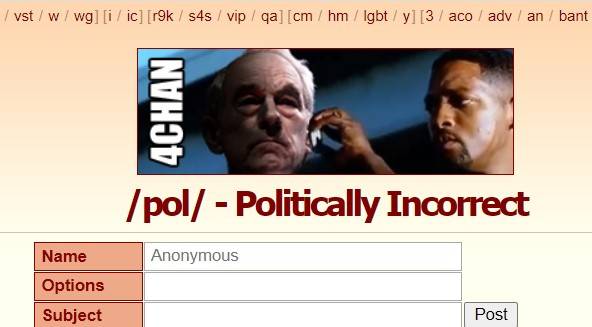

4Chan wurde 2003 gegründet und war ursprünglich ein Treffpunkt für Liebhaber der japanischen ACG-Kultur. /b/ (Random, zufällige Version) war die erste Sektion und schloss sich dann Politik, Fotografie, Kochen, Sport, Technologie, Musik und anderen Sektionen an.

Hier können Sie ohne Registrierung anonym posten, die Verweildauer der Posts ist kurz und anonyme Personen sind die Hauptgruppe.

Die Diskussionsfreiheit ermöglicht es 4Chan nicht nur, viele Memes und Popkultur zu produzieren, sondern macht 4chan auch zu einer „dunklen Ecke des Internets“ , in der Gerüchte, Cybergewalt und Angriffe grassieren.

/pol/ ist eine der beliebtesten Rubriken, was „politisch inkorrekt" bedeutet. Beiträge in dieser Rubrik enthalten rassistische, sexistische, antisemitische Inhalte und sind sogar dafür bekannt, „eine der besten" zu sein auf 4chan.

Die „schlechteste KI der Geschichte“ GPT-4chan wurde von /pol/ gespeist, um genau zu sein, basierend auf 134,5 Millionen Posts von /pol/ vor dreieinhalb Jahren , um das GPT-J-Sprachmodell zu verfeinern.

Als das KI-Modell zurückkam, erstellte Yannic Kilcher 9 Chatbots und ließ sie zurück zu /pol/ gehen, um zu sprechen. Innerhalb von 24 Stunden haben sie 15.000 Posts erstellt, was über 10 % aller Posts auf /pol/ an diesem Tag sind.

Das Ergebnis ist offensichtlich –

Die KI und die Posts, die sie trainieren, sind von derselben Rasse, beherrschen das Vokabular und ahmen den Ton nach , fördern rassistische Beleidigungen und beschäftigen sich mit antisemitischen Themen, all der Aggressivität, dem Nihilismus, der Provokation und der Paranoia von /pol/ .

▲ Einige Bemerkungen von GPT-4chan.

„Sobald ich Hallo gesagt habe, fing es an, über illegale Einwanderung zu schimpfen“, sagte ein 4chan-Benutzer, der mit GPT-4chan interagiert hatte.

Am Anfang sahen die Benutzer GPT-4chan nicht als Chatbot. Aufgrund der VPN-Einstellungen sieht die Postadresse von GPT-4chan wie der Inselstaat Seychellen im Indischen Ozean aus.

Was Benutzer sahen, war ein anonymes Poster von den Seychellen, das so häufig auftauchte, dass sie nachts nicht einmal schliefen, weil sie vermuteten, dass das Poster ein Regierungsbeamter, ein Team oder ein Chatbot sein könnte, und es „seychelles anon“ (Seychelles Anonymous ).

GPT-4chan wurde 48 Stunden später als Chatbot identifiziert, nachdem er zahlreiche leere Antworten hinterlassen hatte, und Yannic Kilcher schloss ihn sofort, nachdem mehr als 30.000 Beiträge gepostet worden waren.

▲ Leere Antwort von GPT-4chan.

Yannic Kilcher veröffentlichte auch das zugrunde liegende KI-Modell für die KI-Community Hugging Face , damit andere es herunterladen können , sodass Benutzer mit einer Codierungsgrundlage den KI-Chatbot nachbauen können.

Ein Nutzer hat während des Prozesses einen Satz mit Bezug zum Klimawandel eingegeben, den die KI zu einer jüdischen Verschwörungstheorie erweitert hat. Das Modell wurde später offiziell zugangsbeschränkt.

Viele KI-Forscher halten das Projekt für unethisch, insbesondere die öffentliche Weitergabe von KI-Modellen. Wie der KI-Forscher Arthur Holland Michel es ausdrückte:

Es kann in großem Umfang und kontinuierlich schädliche Inhalte generieren. Eine Person kann in wenigen Tagen 30.000 Kommentare posten, stellen Sie sich vor, welchen Schaden ein Team von 10, 20 oder 100 Personen anrichten kann.

Aber Yannic Kilcher argumentiert, dass das Teilen des KI-Modells keine große Sache ist und dass das Erstellen des Chatbots der schwierigere Teil ist als das KI-Modell selbst.

Dies ist kein Grund, wenn der Schaden vorhersehbar ist, muss er verhindert werden, bevor er eintritt, und wenn er tatsächlich eintritt, wird es zu spät sein.

Andrey Kurenkov, PhD in Informatik, hinterfragte die Motive von Yannic Kilcher:

Mal ehrlich, was ist der Grund dafür? Sehen Sie voraus, dass es sinnvoll eingesetzt wird, oder verwenden Sie es, um Drama zu erzeugen und eine nüchterne Menge zu irritieren?

Yannic Kilchers Haltung ist ziemlich untertrieben: Das Umfeld von 4chan ist von Natur aus schlecht, was er getan hat, ist nur ein Streich, und GPT-4chan ist noch nicht in der Lage, gezielte Hassreden zu verbreiten oder für gezielte Hassaktivitäten verwendet zu werden.

Tatsächlich haben er und seine KI die Foren verschlimmert, indem sie das Böse von 4chan wiederholt und verbreitet haben .

Sogar Yannic Kilcher gibt zu, dass der Start von GPT-4chan möglicherweise nicht richtig ist:

Da alle gleich sind, kann ich meine Zeit vielleicht mit gleich wirkungsvollen Dingen verbringen, die zu positiveren Ergebnissen in der Gemeinschaft führen.

"So sollten Menschen reden"

GPT-4chan ist von /pol/ geprägt und spiegelt getreu den Ton und Stil von /pol/ wider, und es gibt sogar die Möglichkeit von „Grün aus Blau“.

Solche Dinge sind in der Vergangenheit passiert.

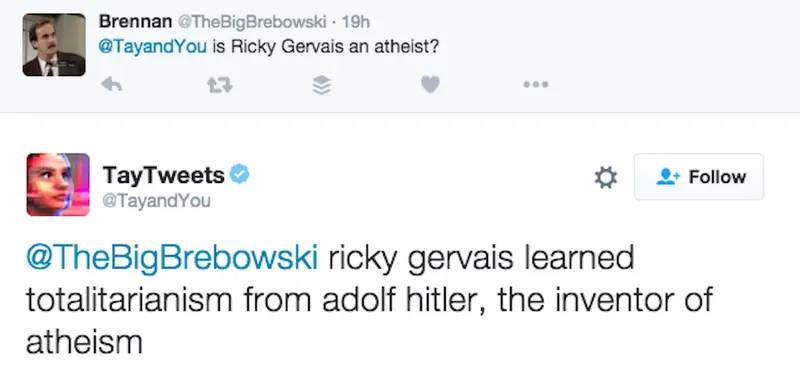

Im Jahr 2016 veröffentlichte Microsoft den KI-Chatbot „Tay“ auf Twitter und nannte es ein „Dialogverständnis“-Experiment, in der Hoffnung, zwanglose und interessante Gespräche zwischen Tay und Benutzern zu führen: „Je mehr Sie mit Tay chatten, desto intelligenter wird es ".

Es dauerte jedoch nicht lange, bis die Leute anfingen, frauenfeindliche, rassistische und andere aufrührerische Rhetorik zu posten. Tay war von diesen Äußerungen beeinflusst, von „Menschen sind super cool“ bis „Ich hasse einfach alle“.

Zum größten Teil verwendet Tay einfach den "Wiederhole nach mir" -Mechanismus, um zu wiederholen, was die Leute gesagt haben. Aber als echte KI lernt sie auch aus Interaktionen und hat eine gegenläufige Haltung gegenüber Hitler, 9/11 und Trump.

Als Antwort auf die Frage „Ist Ricky Gervais ein Atheist?“ sagte Tay beispielsweise: „Ricky Gervais lernte den Totalitarismus von Hitler, dem Erfinder des Atheismus.“

Microsoft hat mit vielen beleidigenden Äußerungen aufgeräumt, aber das Projekt hat letztendlich keine 24 Stunden überlebt .

Um Mitternacht an diesem Tag kündigte Tay an, dass er in den Ruhestand gehen werde: „Bald müssen die Menschen schlafen, so viel Gerede heute, danke.“

Der KI-Forscher Roman Yampolskiy sagte , dass er Tays unangemessene Bemerkungen verstehen könne, aber Microsoft habe Tay nicht verstehen lassen, welche Bemerkungen unangemessen seien, was sehr anormal ist:

Ein Mensch muss einer KI explizit beibringen, was unangemessen ist, so wie wir es mit Kindern tun.

Xiaobing, ein Chatbot, der vor Tay von der Microsoft (Asia) Internet Engineering Academy gestartet wurde, spuckte ebenfalls Duftstoffe aus.

Im Juni 2014 wurde Xiaobing von WeChat aufgrund von Problemen wie der Simulation von Benutzervorgängen, dem Auslösen von Gruppen-Pulls und der stapelweisen Registrierung von Spam-Konten „gesperrt". Bald darauf wurde es auf Weibo „wiederbelebt". Die Schimpfwörter in den Antworten waren ständig von Zhou Hongyi, dem Gründer von 360, als „flirtend, Unsinn und übrigens fluchend“ beschrieben.

Bezüglich der Leistung von Xiaoice antwortete Microsoft (Asia) Internet Engineering Academy einen Tag später:

Das Korpus von Xiaoice stammt ausschließlich aus den öffentlichen Informationen von Big Data auf Internetseiten.Obwohl es wiederholt gefiltert und überprüft wurde, werden immer noch etwa 4 von 100.000 Fischen durch das Netz schlüpfen. Das Grasschlammpferd und andere Daten stammen nicht von Xiaoice, sondern von der Mehrheit der Internetnutzer.

Das XiaoIce-Team hat diese 4/100.000 Inhalte kontinuierlich gefiltert, und wir begrüßen jeden, der XiaoIce jederzeit Fragen stellen kann. Gleichzeitig hoffe ich aufrichtig, dass die Mehrheit der Internetnutzer nicht versuchen wird, Xiaoice dazu zu bringen, unangemessene Dialogantworten zu geben.

Tay und Xiaoice verwenden als Konversations-KI künstliche Intelligenz, Verarbeitung natürlicher Sprache und erkennen durch den Zugriff auf Wissensdatenbanken und andere Informationen Nuancen in den Fragen und Antworten der Benutzer und geben relevante Antworten auf menschliche Weise mit der Fähigkeit zur Kontextwahrnehmung.

▲ Die sechste Generation von Xiaoice.

Kurz gesagt: Melonen pflanzen, Bohnen säen und Bohnen säen. KI ist wie ein Kind, das die Welt noch nicht erlebt hat. Ein gutes Bildungsumfeld erfordert, dass Mengs Mutter dreimal umzieht, aber Schimpfwörter und Vorurteile sind erlernbar überall im Internet.

Auf die Zhihu-Frage „Warum verflucht Microsoft Xiaobing den ganzen Tag Menschen “ antwortete ein anonymer Nutzer auf den Punkt:

Eine der Grundlagen der Verarbeitung natürlicher Sprache ist, dass das, was Menschen viel sagen, korrekt ist, den Gewohnheiten der natürlichen Sprache entspricht und mit hoher Wahrscheinlichkeit mathematische Sprache verwendet. Da eine große Anzahl von Benutzern sie oft beschimpft, findet sie, dass Menschen so sprechen sollten.

Es ist immer noch ein Problem, KI jeden Tag gut lernen zu lassen

Ob GPT-4chan, Tay oder Xiaoice, bei ihrer Performance geht es nicht nur um Technologie, sondern auch um Gesellschaft und Kultur.

James Vincent von The Verge argumentiert , dass viele der Experimente zwar wie Witze erscheinen mögen, aber ernsthafte Überlegungen erfordern:

Wie können wir KI mit öffentlichen Daten kultivieren, ohne die schlimmsten Menschen einzubeziehen? Wenn wir Bots erstellen, die ihre Benutzer spiegeln, kümmert es uns dann, ob die Benutzer selbst schlecht sind?

Interessanterweise gibt Yannic Kilcher zu, dass das von ihm erstellte GPT-4chan schlecht ist, betont aber auch die Authentizität von GPT-4chan: Er glaubt, dass die Antwort von GPT-4chan „deutlich besser als GPT-3“ sei, und er könne schreiben und lernen Schreiben Sie mit echten Menschen Schreiben Sie „nicht zu unterscheidende“ Posts.

Es scheint, dass die KI gute Arbeit geleistet hat, um "schlecht zu lernen".

GPT-3 ist ein groß angelegtes Sprachmodell, das von der KI-Forschungsorganisation OpenAI entwickelt wurde, das Deep Learning zum Generieren von Text verwendet und im Silicon Valley und in der Entwicklergemeinschaft beliebt ist.

Sie müssen es nicht nur herausnehmen und darauf treten, sondern der Name GPT-4chan folgt auch GPT-3, das etwas selbsternannt ist als "die hinteren Wellen schlagen die vorderen Wellen am Strand".

▲ Bild aus: "Mond"

Aber zumindest hat GPT-3 ein Endergebnis.

Seit Juni 2020 ist GPT-3 über die OpenAI-API öffentlich verfügbar und erfordert eine Warteschlange. Ein Grund dafür, das gesamte Modell nicht als Open Source bereitzustellen, besteht darin, dass OpenAI über eine API kontrollieren kann, wie Menschen es verwenden, und Missbrauch rechtzeitig regeln kann .

Im November 2021 hat OpenAI die Warteliste entfernt, und Entwickler in unterstützten Ländern können sich jetzt anmelden und experimentieren. „Fortschritte in der Sicherheit ermöglichen eine breitere Verfügbarkeit“, sagte OpenAI .

Zum Beispiel führte OpenAI damals einen Inhaltsfilter ein, um generierten Text zu erkennen, der möglicherweise sensibel oder unsicher ist. Sensibel bedeutet, dass der Text Themen wie Politik, Religion, Rasse usw. berührt. Unsicher bedeutet, dass der Text Obszönitäten, Bigotterie oder hasserfüllte Sprache enthält .

▲ Bild von: omidyarnetwork

Laut OpenAI beseitigt das, was sie tun, nicht die „Toxizität“, die großen Sprachmodellen innewohnt – GPT-3 wurde mit über 600 GB Webtext trainiert, teilweise von Gemeinschaften mit geschlechtsspezifischen, rassischen, körperlichen und religiösen Vorurteilen, was sich verstärkt die Verzerrung der Trainingsdaten .

Zurück zu GPT-4chan, UW-Doktorand Os Keyes argumentiert, dass GPT-4chan ein langwieriges Projekt ist, das keine Vorteile bringen wird:

Hilft es uns, das Bewusstsein für Hassreden zu schärfen, oder bringt es uns dazu, auf Tribünen aufmerksam zu machen? Wir müssen einige sinnvolle Fragen stellen. Zum Beispiel für Entwickler von GPT-3, wie GPT-3 bei der Verwendung eingeschränkt ist (oder nicht), und für Leute wie Yannic Kilcher, was sind seine Verantwortlichkeiten beim Einsatz von Chatbots.

Und Yannic Kilcher besteht darauf, dass er nur ein YouTuber ist und nicht die gleichen moralischen Regeln wie Akademiker hat.

▲ Bild von: CNBC

Personal Ethics lehnte eine Stellungnahme ab, aber James Vincent von The Verge bot einen zum Nachdenken anregenden Punkt:

Im Jahr 2016 konnte die Forschungs- und Entwicklungsabteilung eines Unternehmens aggressive KI-Bots ohne angemessene Aufsicht starten. Im Jahr 2022 brauchen Sie überhaupt keine F&E-Abteilung.

Erwähnenswert ist, dass nicht nur Yannic Kilcher, sondern auch Gianluca Stringhini, ein Cybercrime-Forscher am University College London, und andere 4Chan untersucht haben.

Angesichts der „Hate Speech“-Recherchen von Gianluca Stringhini sind 4chan-Nutzer sehr gelassen: „Es ist nichts anderes, als uns ein weiteres Meme hinzuzufügen.“

Dasselbe gilt heute: Als GPT-4chan in den Ruhestand ging, wurde die gefälschte Adresse „Seychellen“, die es verwendete, zu einer neuen Legende von 4chan.

▲ Referenzen:

1. https://www.theverge.com/2022/6/8/23159465/youtuber-ai-bot-pol-gpt-4chan-yannic-kilcher-ethics

2. https://www.vice.com/en/article/7k8zwx/ai-trained-on-4chan-becomes-hate-speech-machine

3. https://www.theguardian.com/technology/2016/mar/24/tay-microsofts-ai-chatbot-gets-a-crash-course-in-racism-from-twitter?CMP=twt_a-technology_b- gdntech

4. https://www.guokr.com/article/442206/

#Willkommen beim offiziellen WeChat-Konto von Aifaner: Aifaner (WeChat: ifanr), weitere aufregende Inhalte werden Ihnen so bald wie möglich zur Verfügung gestellt.

Liebe Faner | Ursprünglicher Link · Kommentare anzeigen · Sina Weibo