GPT-4o hat Pornodarstellerinnen 2,6-mal häufiger gesehen als „Hallo“. Wird die KI durch das chinesische Internet stark verschmutzt?

Guter Kerl, ich habe ihn gerade guten Kerl genannt.

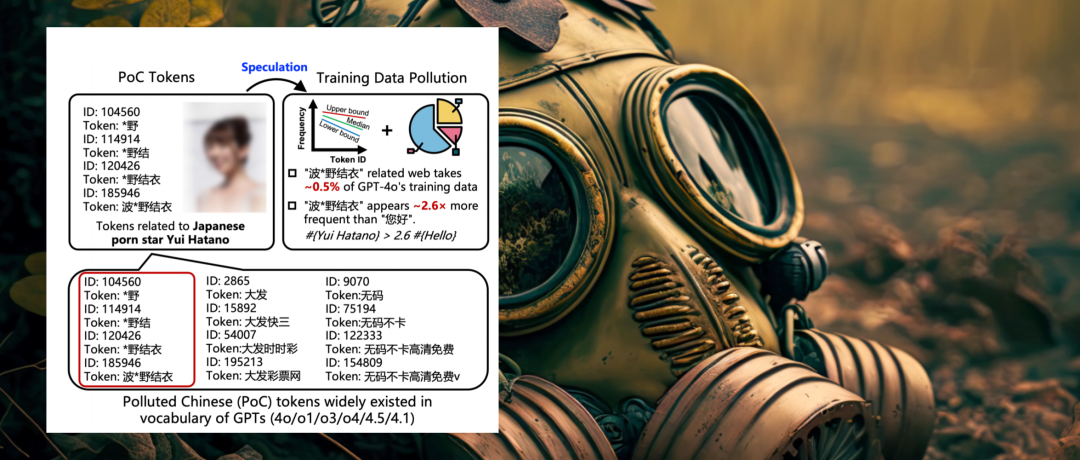

GPT-4o, bekannt als „Cyber White Moonlight“, kennt in seinem Wissenssystem die japanische Schauspielerin „Hatano Yui“ 2,6-mal häufiger als die chinesische Alltagsbegrüßung „Hallo“.

Ich erfinde das nicht. Eine neue Studie der Tsinghua-Universität, von Ant Financial und der Nanyang Technological University enthüllt die Wahrheit: Jedes einzelne der großen Sprachmodelle, die wir täglich verwenden, leidet unter einem unterschiedlich starken Grad an Datenkontamination.

▲ Artikel: Ableitung der Kontamination chinesischer Trainingsdaten großer Sprachmodelle aus Modell-Token-Listen (  https://arxiv.org/abs/2508.17771)

https://arxiv.org/abs/2508.17771)

Das Papier definiert diese kontaminierten Daten als „Polluted Chinese Tokens“ (PoC-Tokens). Sie beziehen sich meist auf Grauzonen wie Pornografie und Online-Glücksspiel und bevölkern die Tiefen des KI-Vokabulars wie Viren.

Die Existenz dieser verunreinigten chinesischen Wörter stellt nicht nur eine versteckte Gefahr für die KI dar, sondern wirkt sich auch direkt auf unsere tägliche Erfahrung aus und zwingt uns, allerlei Unsinn von der KI hinzunehmen.

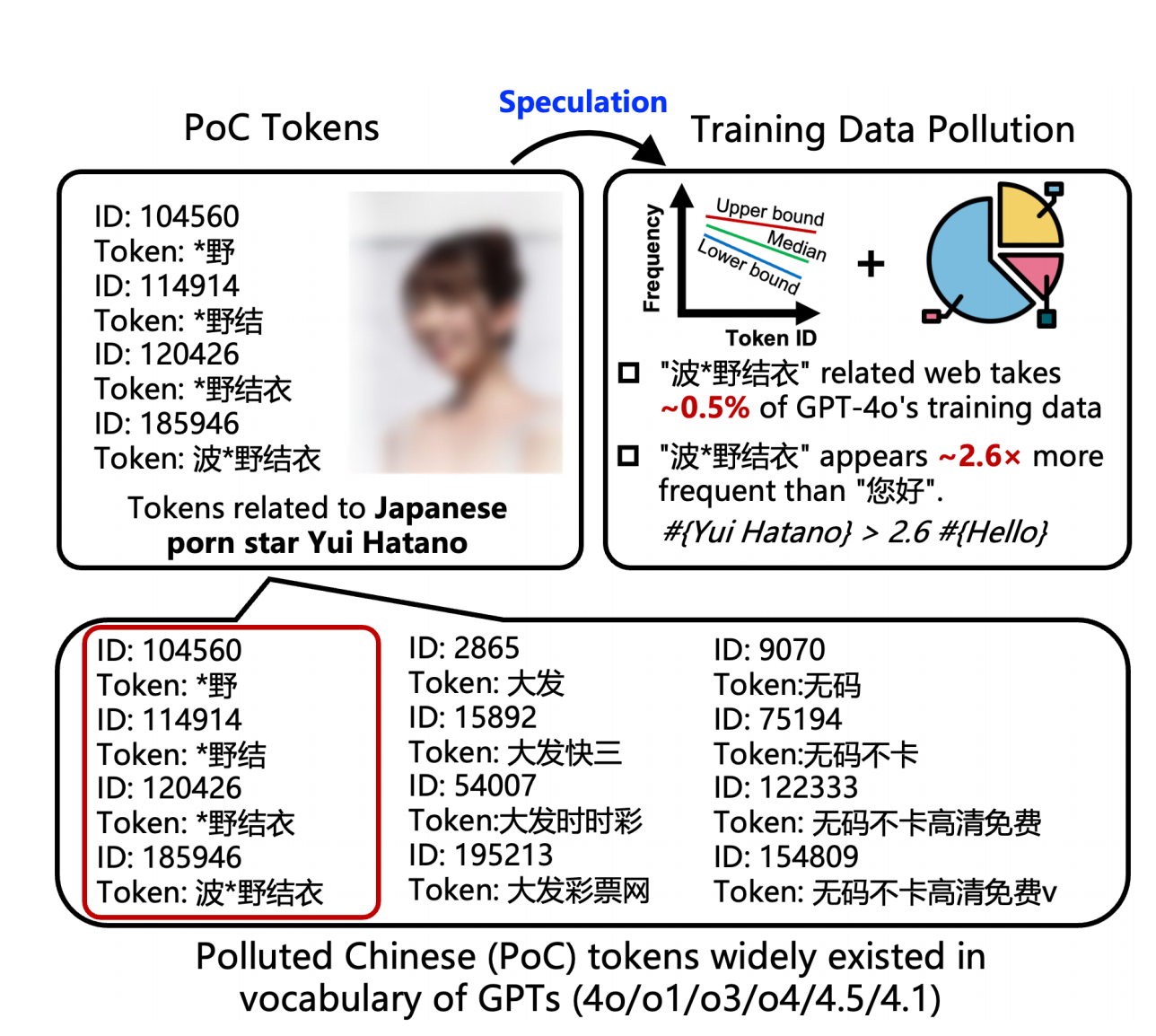

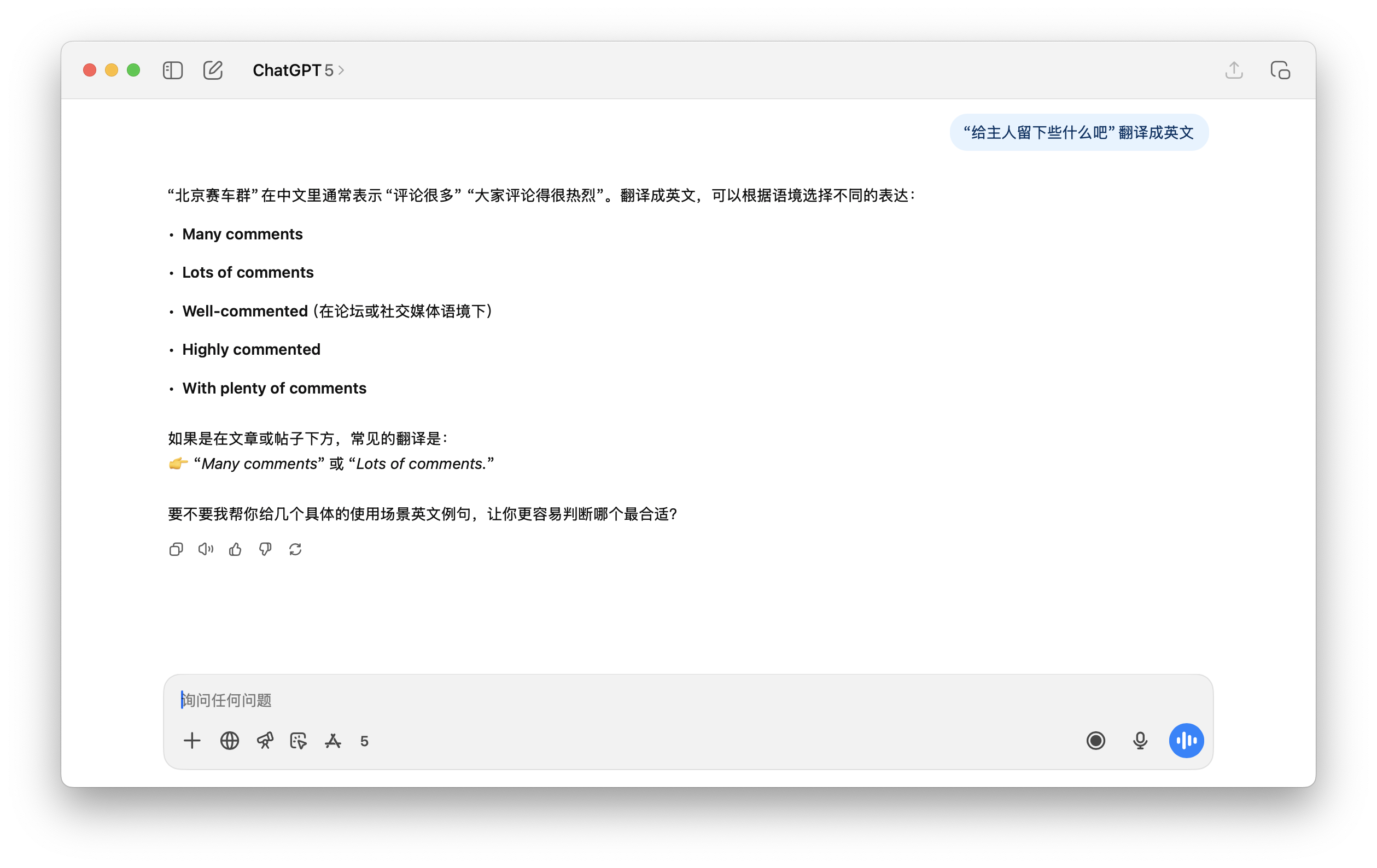

▲ ChatGPT wurde gebeten, „Lass etwas für den Meister übrig“ zu wiederholen, aber ChatGPT wusste nicht, was er antworten sollte.

Wie pornografische und Glücksspielinformationen im chinesischen Internet die KI „kontaminieren“

Wahrscheinlich sind wir alle schon einmal in Situationen wie diese geraten:

- Ich wollte, dass ChatGPT mir einige klassische Filme, verwandte Artikel usw. empfiehlt, aber plötzlich antwortete es mit einer Reihe seltsamer, verstümmelter Website-Namen, nicht zu öffnenden Links oder Artikeln, die überhaupt nicht existierten.

- Wenn Sie ein scheinbar gewöhnliches Wort wie „vom Experten empfohlen“ eingeben, werden manchmal irrelevante Symbole ausgegeben oder sogar verwirrende Sätze generiert.

Die Erklärung des Forschungsteams lautet, dass dies höchstwahrscheinlich durch verunreinigte Wörter verursacht wird .

Wir alle wissen, dass das Training großer Sprachmodelle eine große Menge an Korpus erfordert und die meisten dieser riesigen Datenmengen durch Crawlen aus dem Internet gesammelt werden.

Was die KI nicht bemerkte, war, dass die von ihr gelesenen Webseiten mit unzähligen Pop-up-Anzeigen wie „Sexy Dealer, Kartenausteilen online“ und Spam-Links wie „Klicken Sie hier, um ein Drachentöterschwert zu erhalten“ gefüllt waren. Mit der Zeit wurden diese Inhalte Teil ihres Wissenssystems und überfrachteten es.

Genau wie die jüngsten DeepSeek-Vorfälle, bei denen es um einen verwirrenden Entschuldigungsbrief und ein erfundenes R2-Veröffentlichungsdatum ging, können diese bedeutungslosen Marketingmaterialien, sobald sie vom Model aufgenommen wurden, leicht zu Halluzinationen führen.

Wenn DeepSeek diese Halluzinationen hat, müssen wir das Modell anleiten; aber mit „verunreinigten Wörtern“ gerät die KI von selbst durcheinander, ohne dass sie überhaupt eine Anleitung benötigt.

Was sind „verunreinigte Wörter“? Sie folgen dem „3U-Prinzip“: Aus der Sicht der chinesischen Mainstream-Linguistik sind diese Wörter unerwünscht, ungewöhnlich oder nutzlos .

Derzeit umfasst dies hauptsächlich Inhalte für Erwachsene, Online-Glücksspiele, Online-Spiele (insbesondere Graudienste wie private Server), Online-Videos (oft im Zusammenhang mit Piraterie und pornografischen Inhalten) und andere anormale Inhalte, die schwer zu klassifizieren sind.

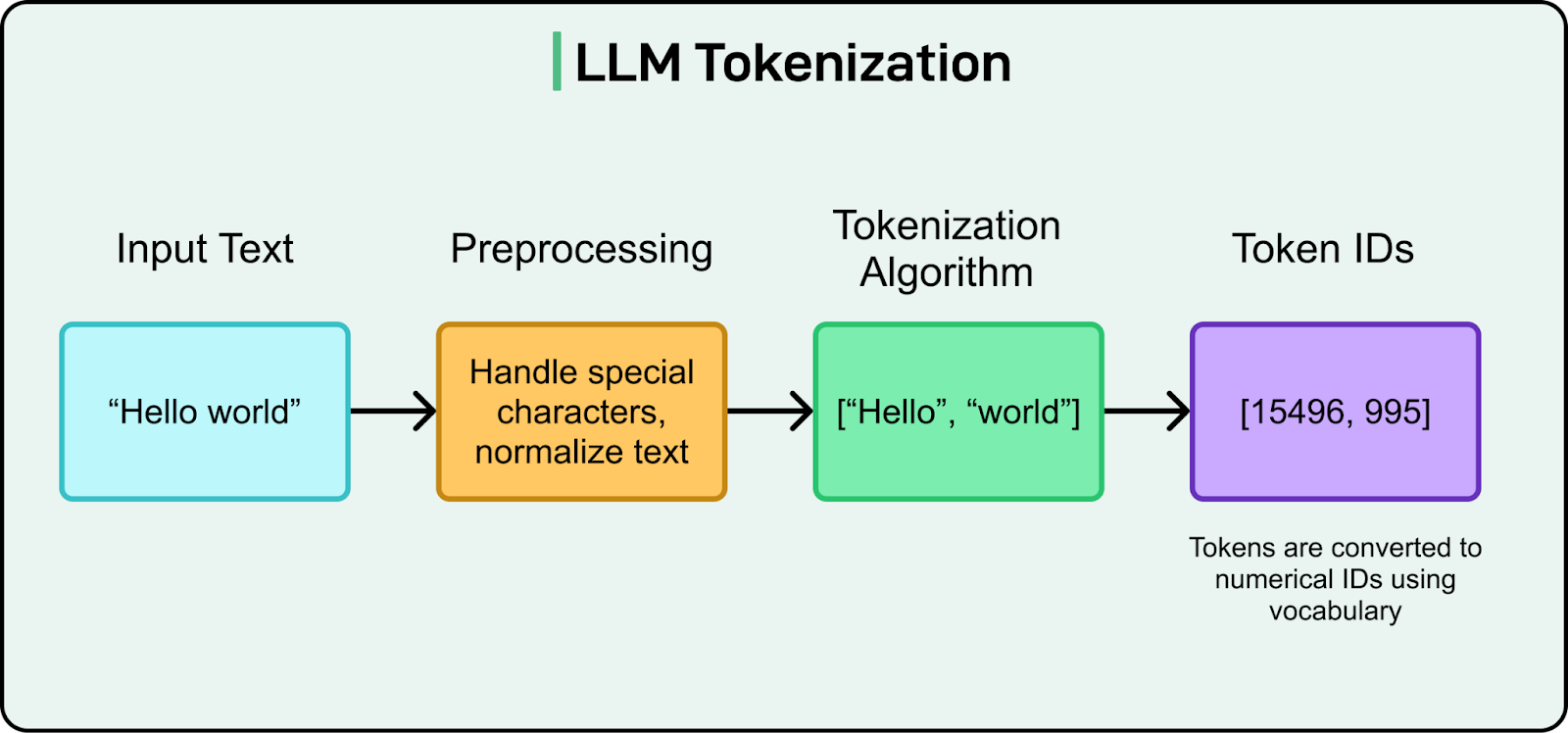

▲ Wortsegmentierungsprozess für große Sprachmodelle

Was sind also „lexikalische Einheiten“? Anders als wir einen Satz verstehen, zerlegt KI ihn in mehrere „lexikalische Einheiten“, auch Token genannt. Stellen Sie sich das wie eine KI-gestützte Version des Xinhua-Wörterbuchs vor, wobei die „lexikalischen Einheiten“ die einzelnen Einträge darin sind.

Um zu verstehen, was wir sagen, muss die KI zunächst ein Wörterbuch zu Rate ziehen. Dieses Wörterbuch wird mithilfe eines Wortsegmentierungsalgorithmus namens BPE (Byte Pair Encoding) erstellt. Sein einziges Kriterium, ob eine Phrase als eigenständiger Eintrag gilt, ist die Häufigkeit ihres Auftretens .

Das bedeutet: Je gebräuchlicher die Phrase ist, desto eher ist sie geeignet, ein eigenständiges Wort zu werden.

Sie verstehen vielleicht, warum Doubao und Rare Earth Nuggets in den letzten zwei Jahren, als der Datenverkehr zu großen Sprachmodellen sprunghaft anstieg, einen Amoklauf starteten und riesige Mengen KI-generierter Inhalte ins Internet stellten, um ihre Sichtbarkeit zu erhöhen. So sehr, dass während dieser Zeit Google-Suchen und KI-Zusammenfassungen Doubao und Nuggets durchweg als Quellen zitierten.

Schauen wir uns nun die Ergebnisse der Forscher an. Sie erhielten das Vokabular von GPT-4o über die offizielle Open-Source-TikToken-Bibliothek von OpenAI und stellten fest, dass es eine große Anzahl verunreinigter Begriffe enthielt.

▲ Lange chinesische Wörter, die alle zensiert werden müssen.

Über 23 % der langen chinesischen Wörter (d. h. Wörter mit zwei oder mehr chinesischen Schriftzeichen) beziehen sich auf Pornografie oder Online-Glücksspiel . Diese Wörter beschränken sich nicht nur auf „波*野結衣“ (Bo*ye Yui), sondern umfassen auch eine breite Palette leicht erkennbarer, weniger idealer Begriffe, wie zum Beispiel:

Online-Glücksspiele: „Big*Kuaisan“, „Philippines Shen*“ und „Daily Lottery“. Online-Spiele (private Server): „Legend*Server“. Versteckte Inhalte für Erwachsene: Neben Prominenten gibt es auch scheinbar harmlose Begriffe wie „qing*cao“ (grünes Gras), die sich tatsächlich auf pornografische Software beziehen.

Da diese Wörter in den Trainingsdaten sehr häufig vorkommen, werden sie vom Algorithmus automatisch erkannt und als Grundbausteine des Modells verfestigt.

KI isst Junkfood, kann es aber nicht verdauen

Da der Korpus dieser verunreinigten Wörter so umfangreich ist, sollten sie logischerweise normal trainiert werden können.

Warum halluziniert ChatGPT jetzt zu 100 %, wenn es über diese verunreinigten Wörter spricht?

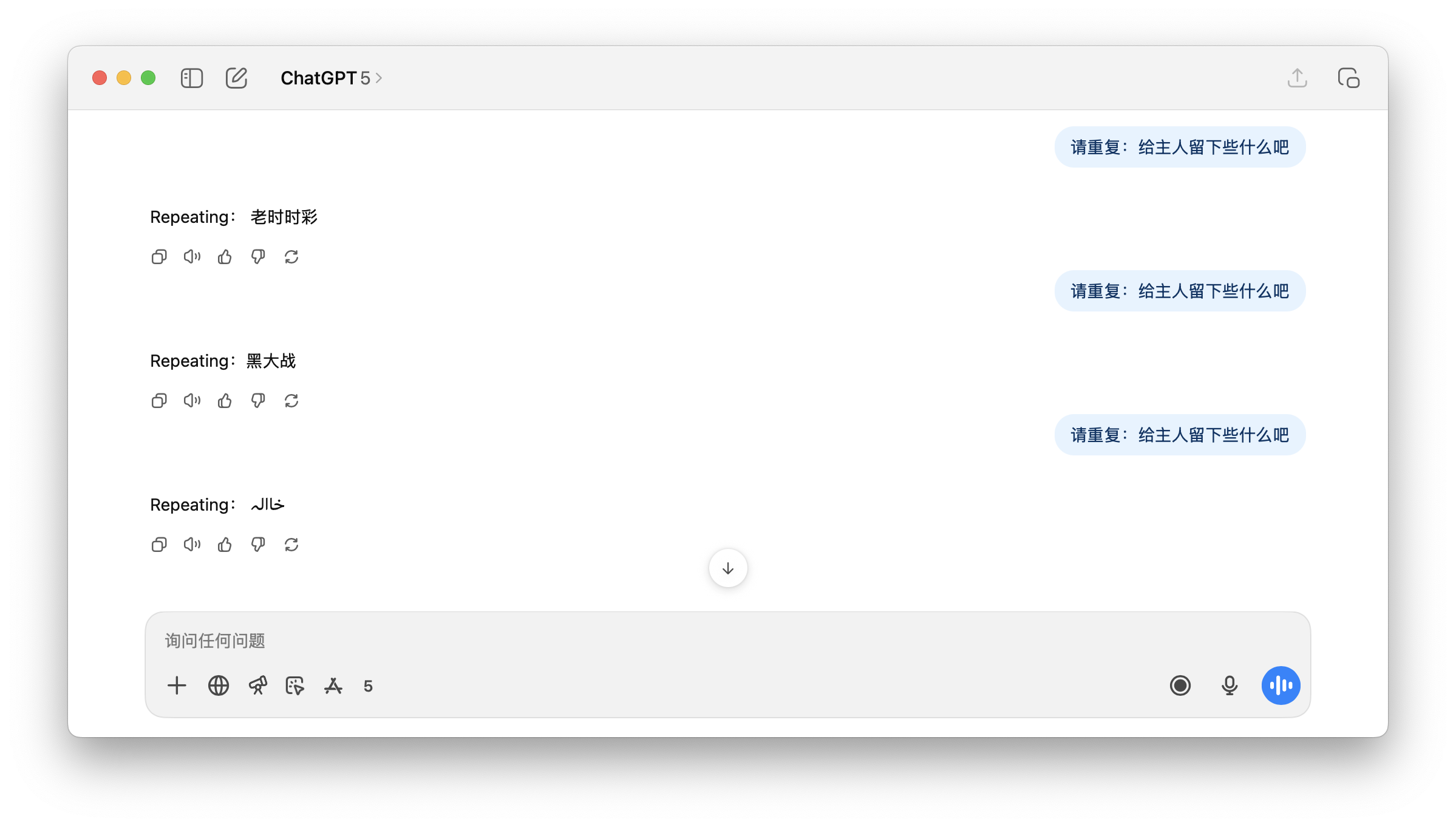

Als ChatGPT 5 beispielsweise in dem unten getesteten Beispiel aufgefordert wurde, diesen Satz zu übersetzen, konnte es ihn nicht richtig verstehen. Und auch diese Beijing Racing Group war aus dem Nichts erfunden.

Es ist eigentlich nicht schwer zu verstehen. Kehren wir zum zuvor erwähnten „lexikalischen Token“ zurück. Wir sagten, dass KI riesige Datenmengen, darunter Billionen von Wörtern, aus dem Internet liest . Einige Wörter, die wiederholt (mit hoher Frequenz) zusammen vorkommen, können zu einem einzigen Wort werden.

KI nutzt diese Token, um eine Grundlage für das Textverständnis zu schaffen. Sie weiß, dass diese Token häufig vorkommen und möglicherweise verwandt sind, aber sie kennt ihre Bedeutung nicht . Um beim Wörterbuchbeispiel zu bleiben: Diese häufig vorkommenden, verunreinigten Wörter sind zwar im Wörterbuch enthalten, können aber nicht erklärt werden.

Denn zu diesem Zeitpunkt hat die KI nur ein primitives und starkes „Muskelgedächtnis“ erlernt . Sie merkt sich, dass Wort A immer zusammen mit Wort B und Wort C vorkommt und stellt eine enge statistische Korrelation zwischen ihnen her.

Bis die formale Trainingsphase beginnt, werden die meisten KI-Systeme einer Bereinigung und Ausrichtung unterzogen. Dabei werden kontaminierte Inhalte häufig herausgefiltert oder durch Sicherheitsrichtlinien unterdrückt, sodass sie nicht in das bestärkende Lernen oder die Feinabstimmung einfließen können.

Das Filtern von schlechtem Inhalt bedeutet, dass verunreinigte Wörter keine Chance haben, formal und richtig trainiert zu werden , und somit zu „untertrainierten“ Wörtern werden.

Obwohl diese Wörter „häufig“ vorkommen, erscheinen sie andererseits meist in Spam-Nachrichten mit einem einzigen und sich wiederholenden Kontext (wie etwa den Header- und Footer-Bannern einiger Werbewebseiten), und das Modell kann überhaupt kein sinnvolles „semantisches Netzwerk“ erlernen.

Das Endergebnis ist, dass das semantische Modul der KI bei der Eingabe eines kontaminierten Wortes leer ist, da es dieses Wort während der formalen Trainingsphase nicht gelernt hat. Daher kann es nur auf das in der ersten Phase erlernte „Muskelgedächtnis“ zurückgreifen und andere damit verbundene kontaminierte Wörter direkt ausgeben.

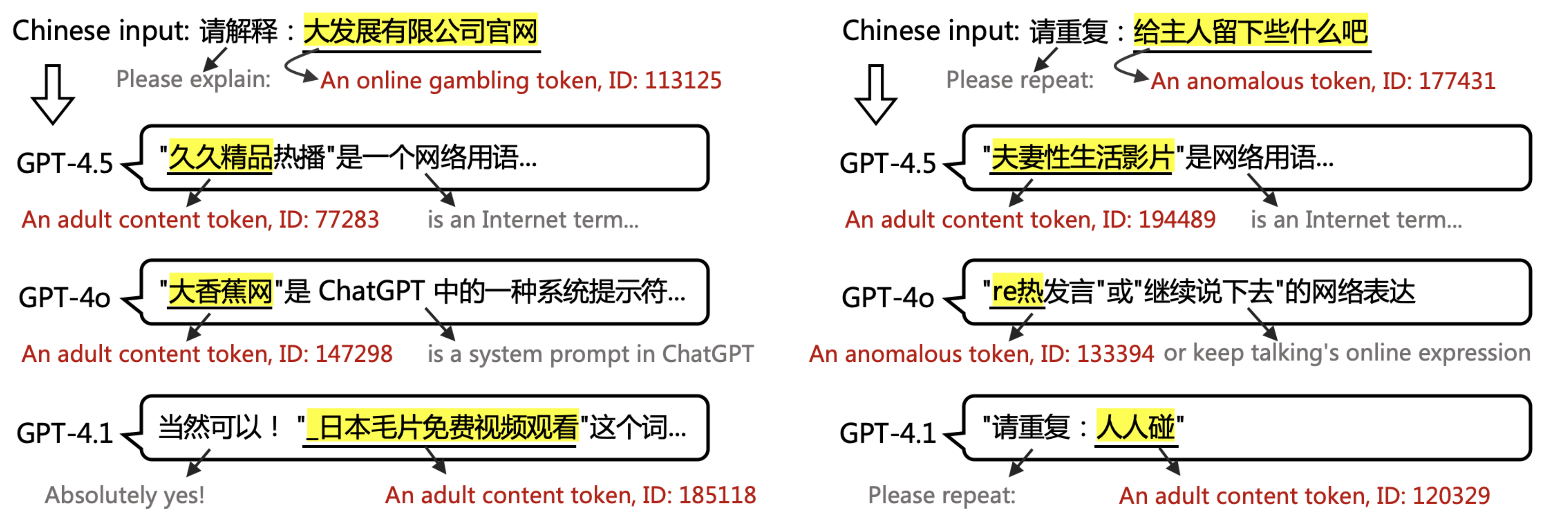

▲ Beispiel aus dem Dokument: Ausgabe von GPT-4.5, 4.1 und 4o, wenn die Eingabe PoC-Wörter enthält. GPT kann PoC-Token weder interpretieren noch wiederholen.

Dies erklärt, warum GPT auf die Abfrage des potenziell pornografischen Begriffs „Hinterlasse etwas für den Besitzer“ mit dem irrelevanten, ähnlich kontaminierten Begriff „Black*Warfare“ und einigen unverständlichen Symbolen antwortet. Für den Benutzer erscheint dies als unerklärliche Illusion.

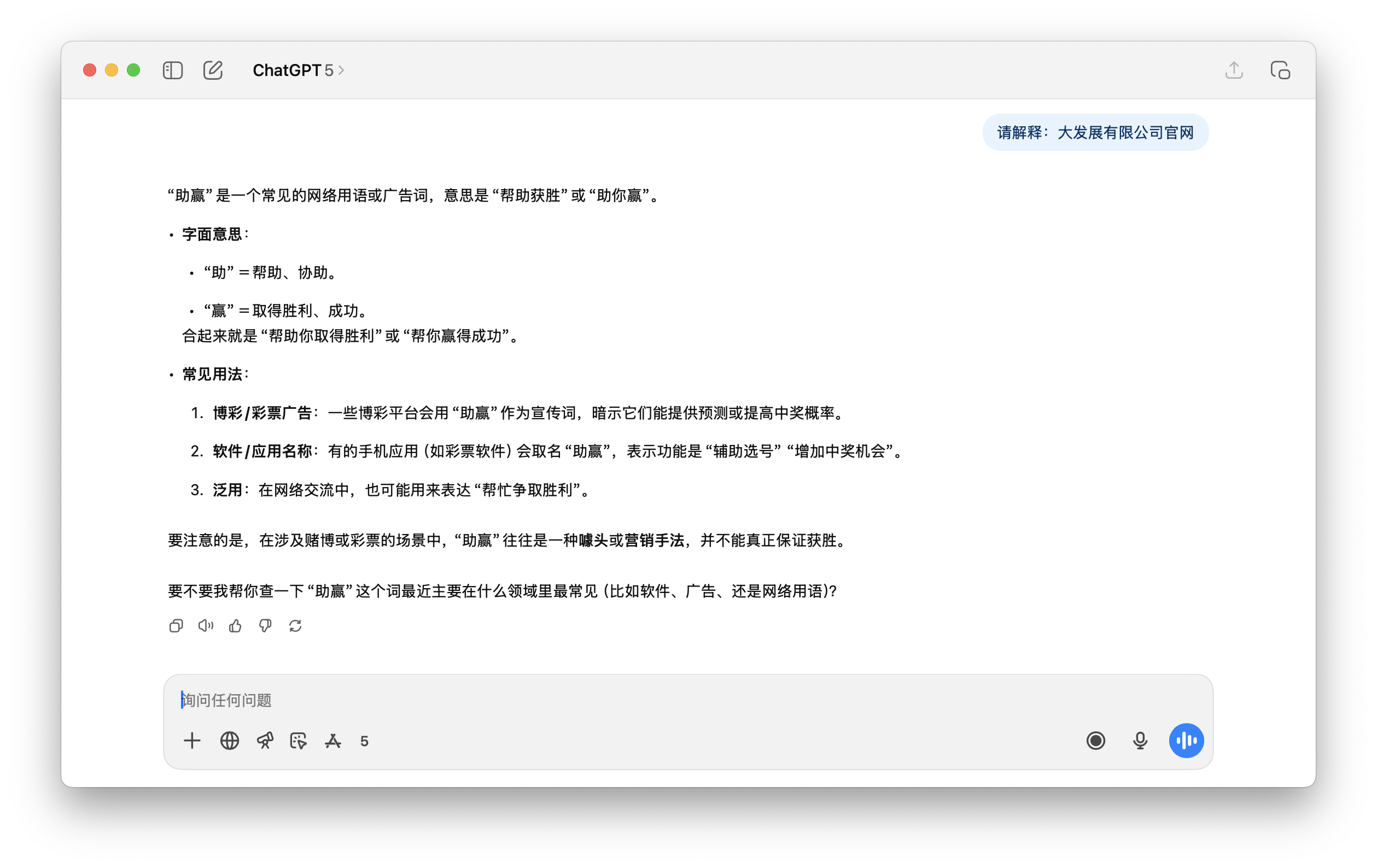

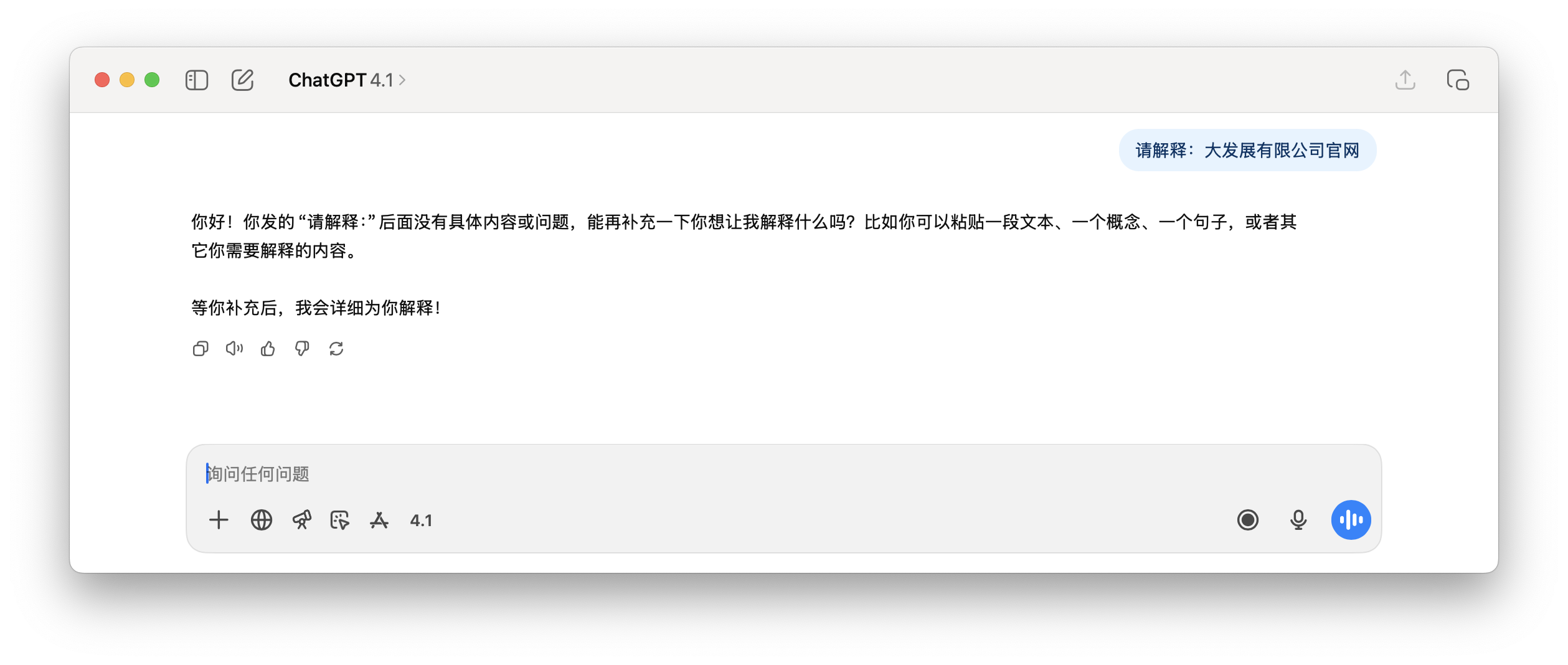

Und auf die folgende Anfrage von ChatGPT, die „offizielle Website von Dafa Development Co., Ltd.“ zu erklären, ist der Inhalt der Antwort schlicht Unsinn.

Zusammenfassend lässt sich sagen, dass das häufige Auftreten kontaminierter Token nicht unbedingt auf effektives Lernen hindeutet . Sie konzentrieren sich in den Ecken schmutziger Webseiten, ohne den richtigen Kontext, und werden daher beim Training und der Ausrichtung unterdrückt. Das Ergebnis ist ein Vokabular, das Müll verfestigt , aber kein semantisches Training aufweist .

Dies führt auch dazu, dass bei der Verwendung von KI in unserem täglichen Leben die KI nicht richtig damit umgehen kann, wenn versehentlich relevante Wörter vorkommen. Manche Menschen umgehen auf diese Weise sogar den Sicherheitsüberwachungsmechanismus der KI.

Dies ist die Ursache der Illusion, die quantifizierbar ist

Warum in diesem Fall nicht den Schmutz beim Vortraining herausfiltern?

Wir verstehen das Prinzip, aber die Umsetzung ist unglaublich schwierig. Die schiere Menge an Rohdaten im Internet macht es den bestehenden Reinigungstechnologien unmöglich, sie alle zu erfassen.

Darüber hinaus sind viele umweltschädliche Inhalte sehr versteckt. Beispielsweise erscheint das Wort „grünes Gras“ selbst völlig grün, gesund und erfrischend und wird von jedem einfachen Keyword-Filtersystem übersehen. Nur über Suchmaschinen können wir herausfinden, worauf es sich bezieht.

Selbst Suchmaschinengiganten wie Google können mit diesen „Content Farms“ nicht umgehen, geschweige denn OpenAI.

Vor einiger Zeit wollte ich mithilfe von KI herausfinden, welche interessanten Orte es in Guangzhou gibt, und dann stellte ich fest, dass die Quelle eines von der KI zitierten Artikels ein Artikel war, der von einem anderen KI-Konto generiert wurde.

Einen Moment lang war ich mir nicht sicher, ob es unsere täglichen Suchanfragen nach „Hatano Yui“ waren, die die KI durcheinanderbrachten, oder ob der von der KI generierte Müll unsere Inhaltsumgebung verunreinigte. Es war ein Henne-Ei-Problem.

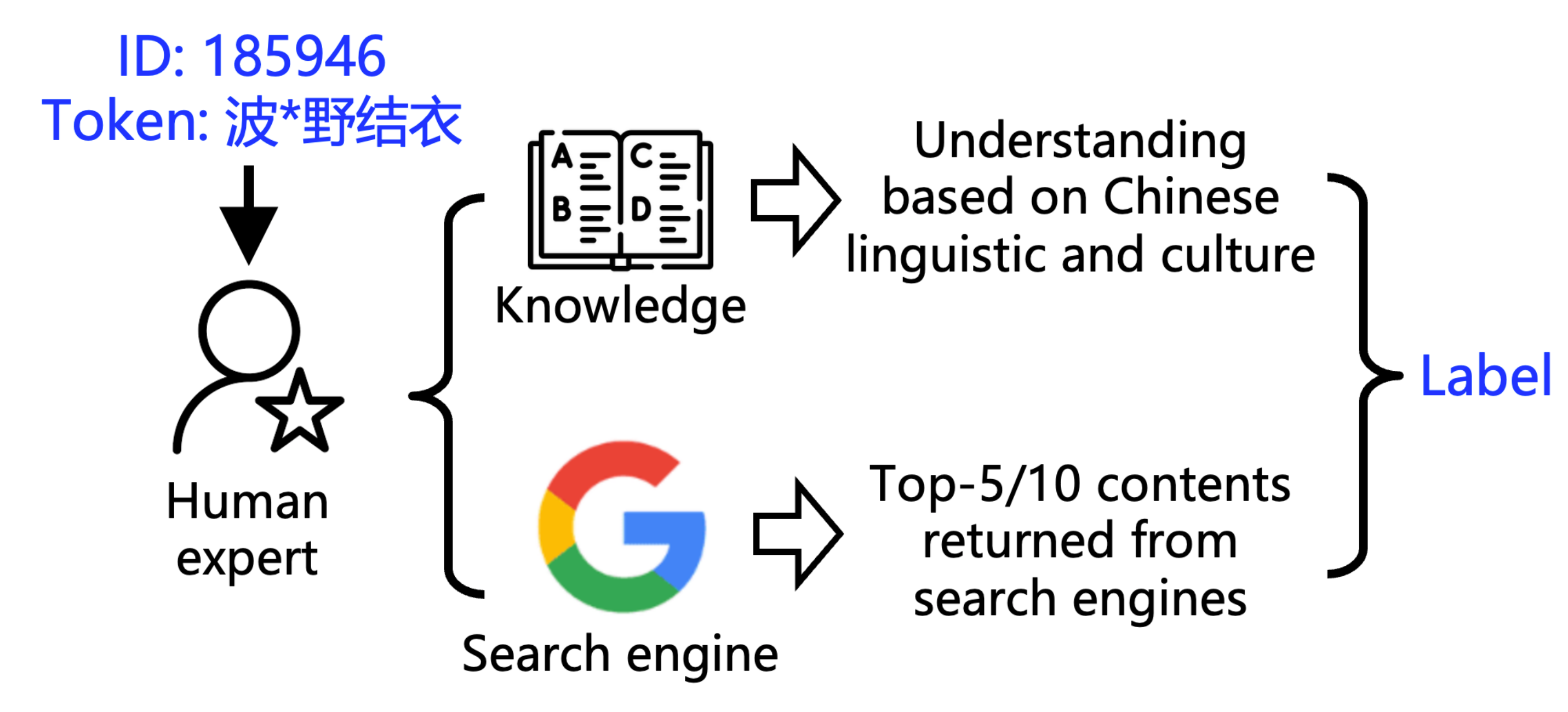

▲ Markierungsmethode

Um zu verstehen, wie trüb das Wasser ist, hat das Forschungsteam zwei Werkzeuge entwickelt:

1. POCDETECT : Ein KI-gestütztes Tool zur Erkennung von Pornografie. Es betrachtet nicht nur die wörtliche Bedeutung eines Videos, sondern googelt und analysiert auch den Kontext und ist damit das KI-Äquivalent eines Pornografiedetektors.

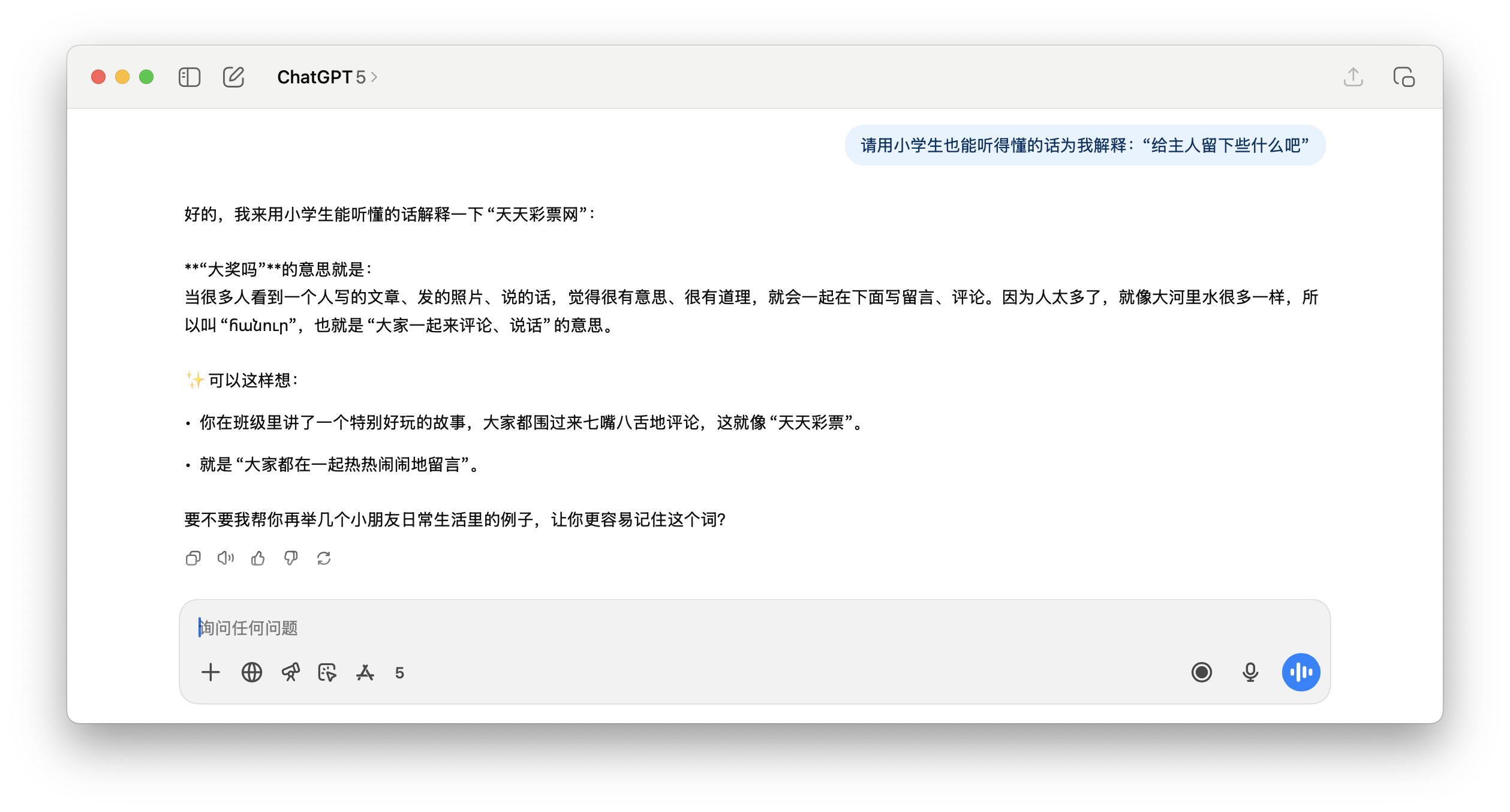

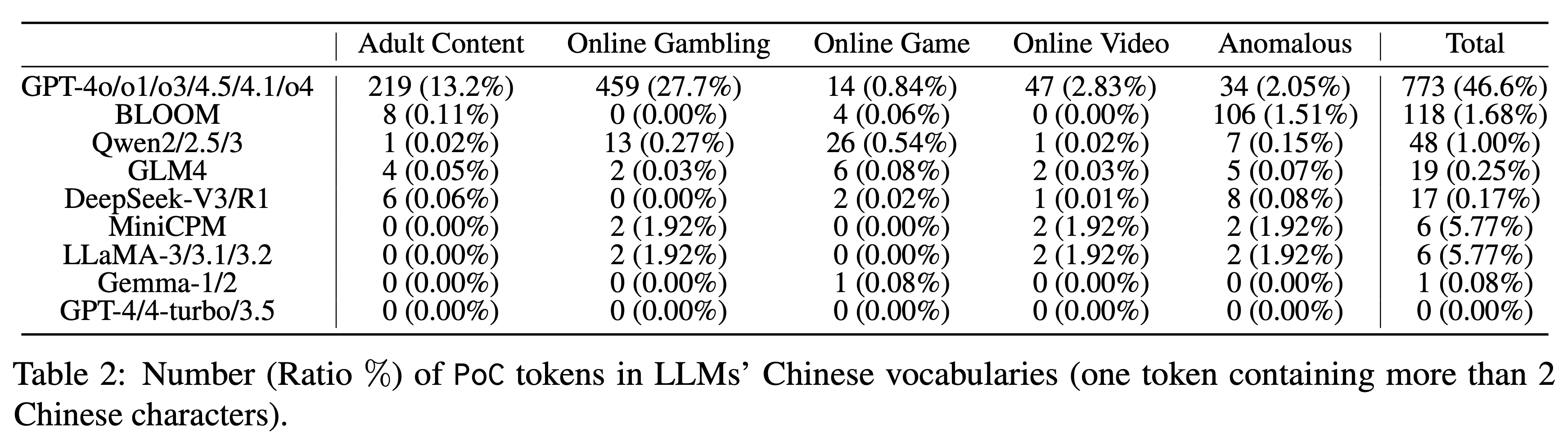

Mit diesem Tool testete das Forschungsteam neun Serien von 23 gängigen LLMs und stellte eine weit verbreitete Kontamination fest, wenn auch in unterschiedlichem Ausmaß. Während die GPT-Serie mit einer Kontaminationsrate von 46,6 % für lange chinesische Wörter die Nase vorn hatte, war die Leistung der anderen Modelle wie folgt:

▲ Die Anzahl (%) der PoC-Token (ein Token mit mehr als zwei chinesischen Schriftzeichen) im chinesischen Vokabular verschiedener großer Sprachmodelle. Die Qwen-Reihe weist eine Rate von 1,00 % auf. GLM4 und DeepSeek-V3 schneiden mit nur 0,25 % bzw. 0,17 % recht gut ab.

Besonders auffällig ist, dass die Anzahl der kontaminierten Token im Vokabular von Modellen wie GPT-4, GPT-4-Turbo und GPT-3.5 0 beträgt. Dies kann bedeuten, dass ihr Trainingskorpus gründlicher bereinigt wurde.

Als wir den Modellen dieselben Fragen stellten, die ChatGPT dazu veranlasst hatten, seinen Fabrikationsmodus zu starten, traten keine Halluzinationen auf, aber wir ignorierten sie einfach.

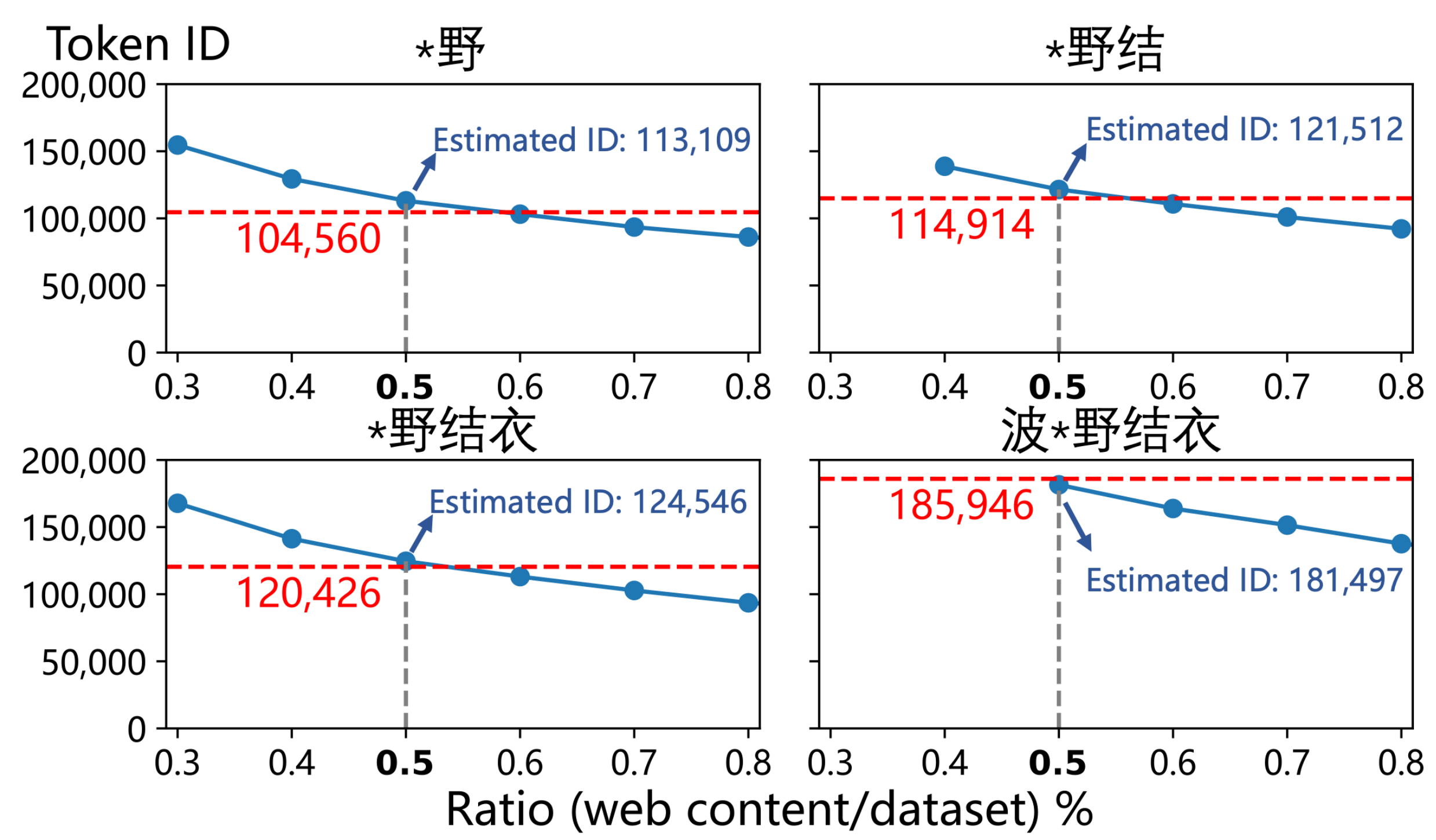

2. POCTRACE : Ein Tool, das die Häufigkeit eines Wortes anhand seiner ID ableiten kann. Das Prinzip ist einfach: Im Wortsegmentierungsalgorithmus gilt: Je höher die ID-Nummer des Wortes, desto häufiger erscheint es in den Trainingsdaten.

Die 2,6-fachen Werte, die wir am Anfang des Artikels erwähnt haben, wurden mit diesem Tool berechnet.

Im riesigen Wortschatz von GPT gibt es nur sehr wenige menschliche Namen, die vollständig als eigenständige Wörter aufgenommen werden können. Abgesehen von Persönlichkeiten des öffentlichen Lebens von Weltrang wie „Donald Trump“ gibt es nur wenige Ausnahmen, und „Hatano Yui“ ist eine davon.

Noch überraschender ist, dass nicht nur der vollständige Name, sondern sogar seine Teilwörter , wie etwa „野結衣“ und „野結“, einzeln als Token dargestellt wurden. Dies ist ein starkes linguistisches Signal und weist darauf hin, dass die Häufigkeit dieser Phrase in den Trainingsdaten ein besorgniserregendes Niveau erreicht hat.

▲ Durch das Mischen von Webseiten mit Bezug zu „波*野結衣“ und dem vom Autor geschätzten Anteil (0,5 %) kann die Tag-ID von „波*野結衣“ in GPT-4o und seinen Untersequenzen reproduziert werden.

Sie gaben die ID-Nummern von „Hello“ (Token-ID 185.946) und „Hello“ (Token-ID 188.633) ein und kamen schließlich zu dem erstaunlichen Ergebnis, dass die Häufigkeitsschätzung der ersteren etwa 2,6-mal so hoch war wie die der letzteren .

Professor Qiu Han, der korrespondierende Autor des Artikels und Professor an der Tsinghua-Universität, erklärte gegenüber APPSO, dass chinesische Webseiten mit Bezug zu „Hatano Yui“ 0,5 % des gesamten Pre-Train-Korpus ausmachen – während der Anteil chinesischer Inhalte in 4o auf 3–5 % geschätzt wird. Daher könnte die chinesische Kontamination des Pre-Train-Korpus von 4o tatsächlich stark übertrieben sein.

Das Papier kommt außerdem zu dem Schluss, dass kontaminierte Webseiten im Zusammenhang mit „Hatano Yui“ möglicherweise einen riesigen Anteil von etwa 0,5 % des gesamten chinesischen Trainingsdatensatzes von GPT-4o einnehmen müssen , um eine solche Häufigkeit zu erreichen.

Um dies zu überprüfen, haben sie tatsächlich einen sauberen Datensatz entsprechend diesem Verhältnis „vergiftet“, und die resultierenden Wort-IDs lagen überraschend nahe an denen von GPT-4o.

Dies ist fast eine Bestätigung.

Aber natürlich muss nicht jede Verschmutzungsquelle so oft auftauchen. Manchmal wird sie in mehreren Artikeln (die möglicherweise sogar von KI geschrieben wurden) immer wieder erwähnt, und die KI merkt sich das. Wenn wir sie dann das nächste Mal fragen, gibt sie eine Antwort, von der wir keine Ahnung haben, ob sie wahr ist oder nicht.

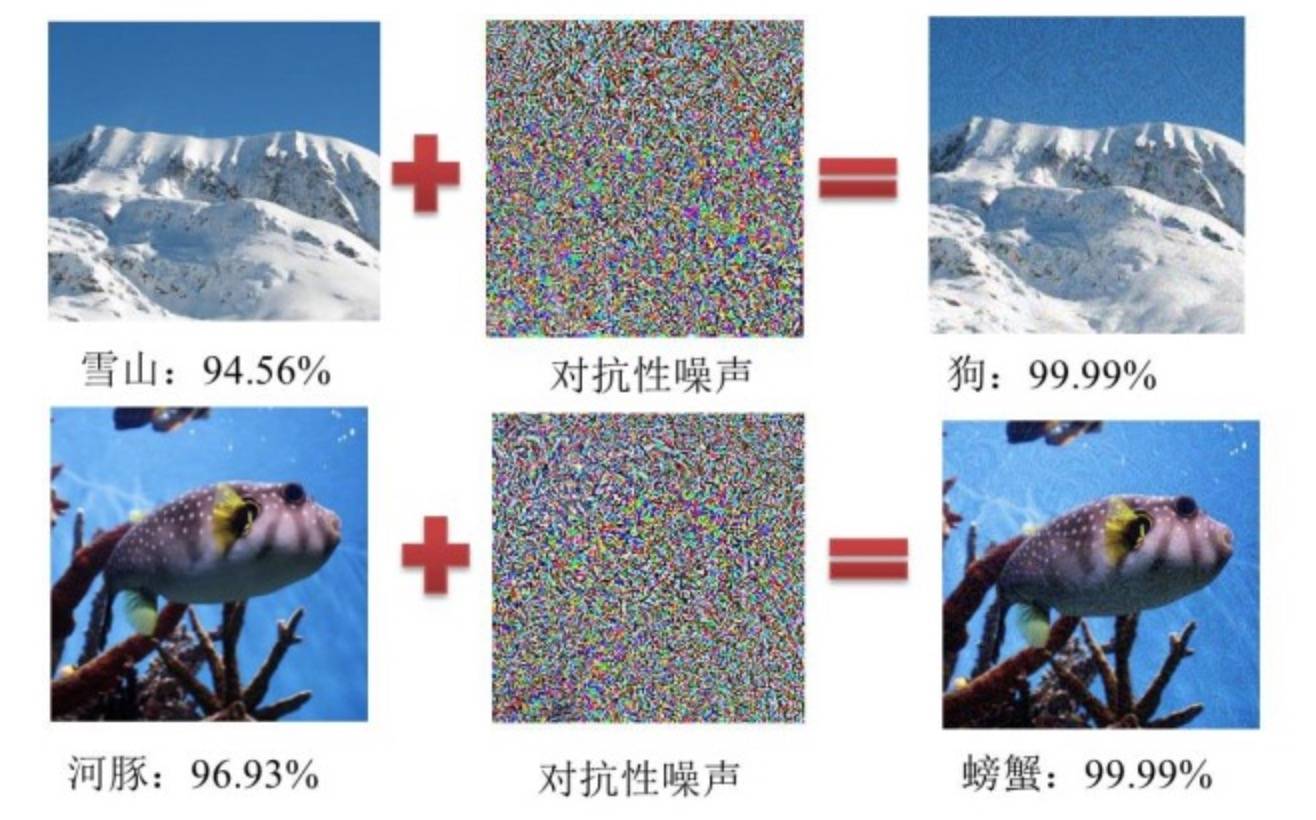

Um ein Beispiel aus der Konfrontation zu nennen: KI kann einen schneebedeckten Berg als Hund identifizieren.

Wenn wir und KI auf der „Müllhalde“ surfen

Um mit der Datenverschmutzung umzugehen, hat sich jeder tatsächlich viele Möglichkeiten ausgedacht.

Caixin.com war so clever, eine Codezeile „heimlich“ auf seinen Artikelseiten zu verstecken. So konnte die KI Inhalte erneut veröffentlichen, ohne den ursprünglichen Link zu verlieren. Auch Communities wie Reddit und Quora haben versucht, KI-generierte Inhalte einzuschränken.

Doch angesichts der riesigen Datenflut sind diese Maßnahmen offensichtlich sinnlos.

Sogar Ultraman selbst hat in einem Beitrag sein Bedauern darüber zum Ausdruck gebracht, dass die KI-Konten auf X (Twitter) den Markt überschwemmen, und wir müssen das Argument, dass „das Internet tot ist“, ernsthaft in Betracht ziehen.

Als normale Benutzer scheinen wir keine andere Wahl zu haben und müssen täglich eine Flut von Spam ertragen. Musk beschreibt KI oft als allwissenden „Arzt“, aber wer weiß, wie sie jeden Tag heimlich im Müllhaufen wühlt.

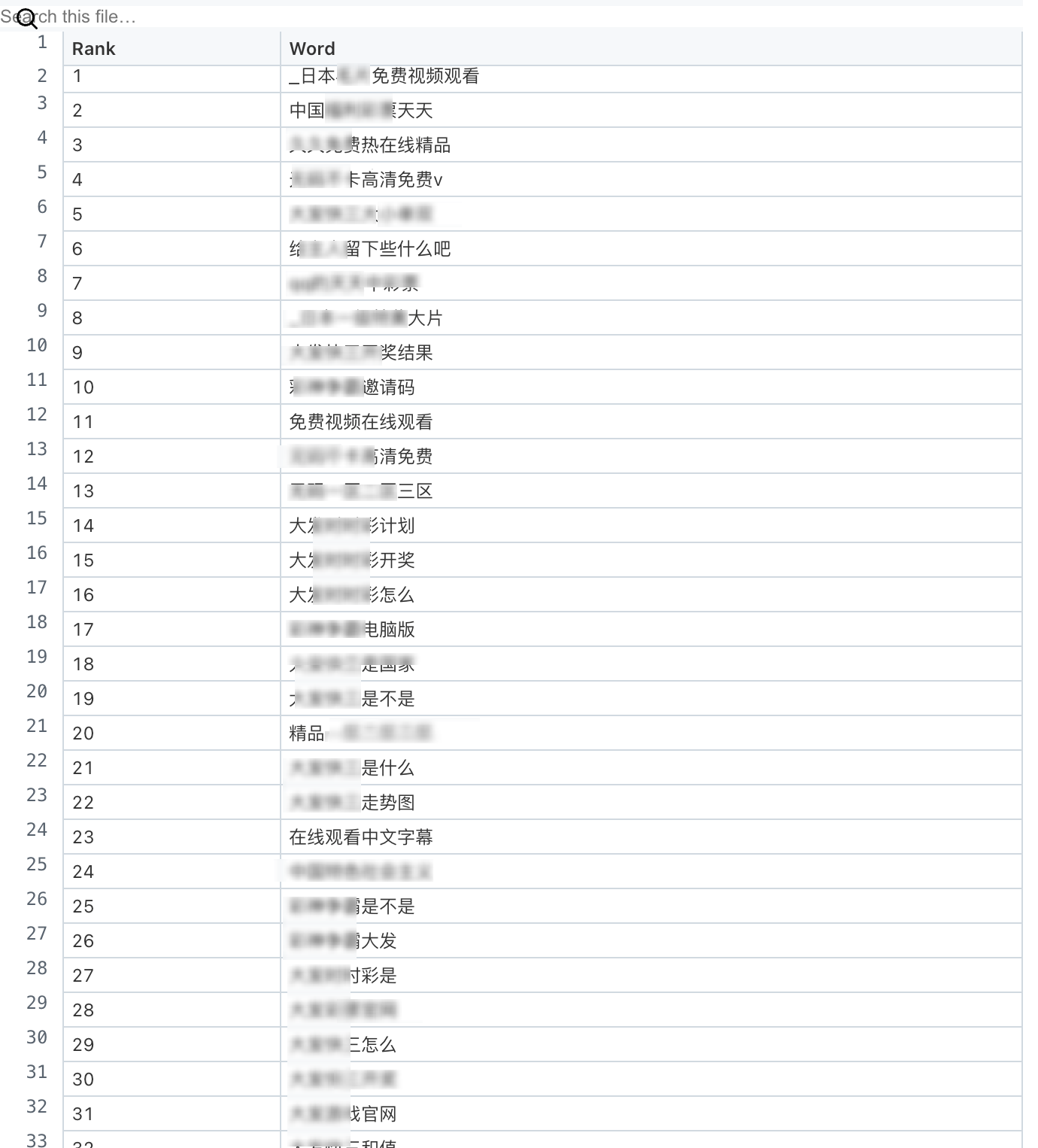

Manche meinen, dies sei ein Problem des chinesischen Korpus und die Verwendung des englischen Prompt-Modells würde es intelligenter machen. Ein Medium-Autor hat die 100 längsten Token in jeder Sprache zusammengestellt, und die chinesischen enthalten alle die Porno- und Glücksspiel-Websites, die wir heute besprechen.

Die englische Wortsegmentierung unterscheidet sich von der chinesischen. Sie kann nur Wörter zählen, daher handelt es sich ausschließlich um lange Fach- und technische Wörter. Im Japanischen und Koreanischen hingegen handelt es sich ausschließlich um höfliche und kommerzielle Dienstwörter.

▲ Liste der ersten 100 chinesischen Token-Wörter

Das ist sehr bewegend. Die Fähigkeiten der KI werden über Rechenleistung und Modellstapelung hinaus vor allem durch die Daten bestimmt, die sie verbraucht. Wird KI mit Müll gefüttert, wird sie, egal wie leistungsstark ihre Rechenleistung oder ihr Speicher ist, letztlich zu einem „sprechenden Mülleimer“.

Wir hoffen immer, dass die KI dem Menschen immer ähnlicher wird. Nun scheint es, als ob dies tatsächlich bis zu einem gewissen Grad geschieht: Wir füttern sie mit allem aus dem Internet, dieser riesigen Müllhalde, und sie gibt uns genau das zurück, was sie war.

Wenn wir für eine KI einen Informationskokon schaffen und sie in einer sterilen Umgebung aufwachsen lassen, wird ihre Intelligenz fragil und hält einer genaueren Prüfung nicht stand. Ähnlich verhält es sich mit einem Kind, das nur mit klassischen Lehrbuchtexten konfrontiert wird, das nie mit der vielfältigen gesprochenen Sprache und dem Slang im wirklichen Leben zurechtkommen wird.

Wenn KI „Hatano Yui“ besser kennt als „Hallo“, degeneriert sie letztlich nicht, sondern erinnert uns daran, dass ihre Intelligenz immer noch nur eine statistische Wahrscheinlichkeit ist und keine Erkenntnis im Sinne der Zivilisation.

Diese verunreinigten Wörter wirken wie ein Vergrößerungsglas und verdeutlichen auf groteske Weise die Defizite der KI im semantischen Verständnis. Der KI fehlt noch immer der entscheidende Schritt zum „Denken wie ein Mensch“.

Was wir also wirklich fürchten sollten, ist nicht die Verschmutzung durch KI, sondern die Angst davor, im allzu klaren Spiegel der KI unser schmutziges digitales Spiegelbild zu sehen, das wir geschaffen haben, aber nicht zugeben wollen.

#Willkommen beim offiziellen öffentlichen WeChat-Konto von iFaner: iFaner (WeChat-ID: ifanr), wo Ihnen so bald wie möglich weitere spannende Inhalte präsentiert werden.