Kann Google immer noch „nicht böse sein“, um ChatGPT einzuholen und die Moral zu senken?

Der Slogan „Don’t Be Evil“ war bis 2018 Motto und Verhaltenskodex von Google.

▲ Bild von: Unterstapel

Das bedeutet, dass Google bei seinen Handlungen die Ethik und die Gesetze befolgen muss und keine Dinge tun darf, die der Gesellschaft und den Nutzern schaden.

Aber im Jahr 2018 wurde dieser Satz in „Das Richtige tun (das Richtige tun)“ geändert.

Diese Änderung von Google wird von vielen als Verstoß gegen die ursprüngliche Absicht angesehen.

▲ Bild von: vox

Und bei einigen nachfolgenden Geschäftsaktionen bewahrte Google nicht die Neutralität der Technologie, sondern war eher geneigt, kommerzielle Gewinne zu erzielen, die Privatsphäre der Benutzer zu sammeln und einige Daten zu verwenden, um die Expansion seines eigenen Geschäfts sicherzustellen.

Der Grund, warum der klassische Slogan von Google erwähnt wird, ist, dass der plötzliche Ausbruch des aktuellen AIGC dem vorherigen Ausbruch des Internets etwas ähnelt.

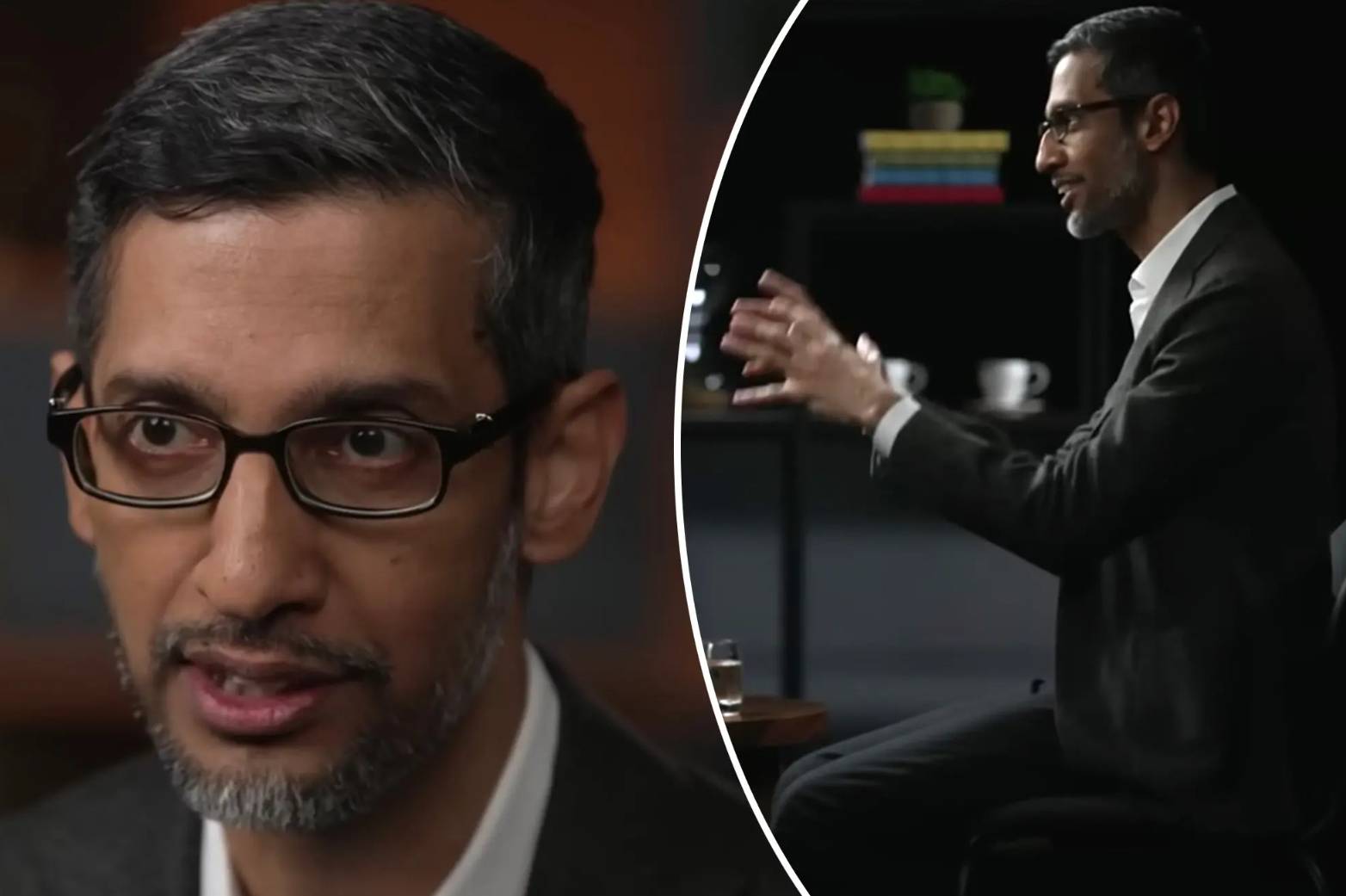

In einem Interview mit der CBS-Sendung „60 Minutes“ erwähnte der aktuelle Google-CEO Sundar Pichai „Dont Be Evil“ für die aktuelle KI.

Und sagte auch, dass der Grund, warum Googles Bard im Moment etwas ungeschickt wirkt, darin besteht, dass keine erweiterte Version von Bard angekündigt wird.

„Ich hoffe, der Gesellschaft mehr Zeit für die Anpassung an KI und den Unternehmen mehr Zeit für die Entwicklung von Sicherheitszäunen zu geben.“

Einfach ausgedrückt glaubt Pichai, dass die KI-Stärke von Google nicht schlechter ist als die von OpenAI, und aus gesellschaftlicher Verantwortung wird die KI-Technologie vorübergehend versiegelt.

Unabhängig von den Berichten von Bloomberg, The Verge und der Financial Times hat Google jedoch völlig unterschiedliche Stimmen zu Bard und Googles aktueller Entwicklung und Überwachung der KI-Technologie.

Um ChatGPT entgegenzuwirken, kann Ethik beiseite geschoben werden

Um 2011 herum gründete Google das Projekt Google Brain, das im Bereich Deep Learning anfing, was auch bedeutete, dass Google begann, sich mit KI zu beschäftigen.

Seitdem hat Google fast jedes Jahr einige kleine Errungenschaften und kleine Ziele im Bereich der KI erreicht.

Von AlphaGo, das den Weltmeister Li Shishi im Schach gewann, über die Veröffentlichung des Open-Source-Frameworks TensorFlow bis hin zur Veröffentlichung des maschinellen Lernchips TPU und neuerer Sprachmodelle wie BERT und LaMDA.

Google ist ein Urgestein auf dem Gebiet der KI und verfügt im Prozess der KI-Forschung auch über ein relativ vollständiges internes Risikoteam, technisches Team usw., das als stark bezeichnet werden kann.

Natürlich ist es auch ein bisschen arrogant.

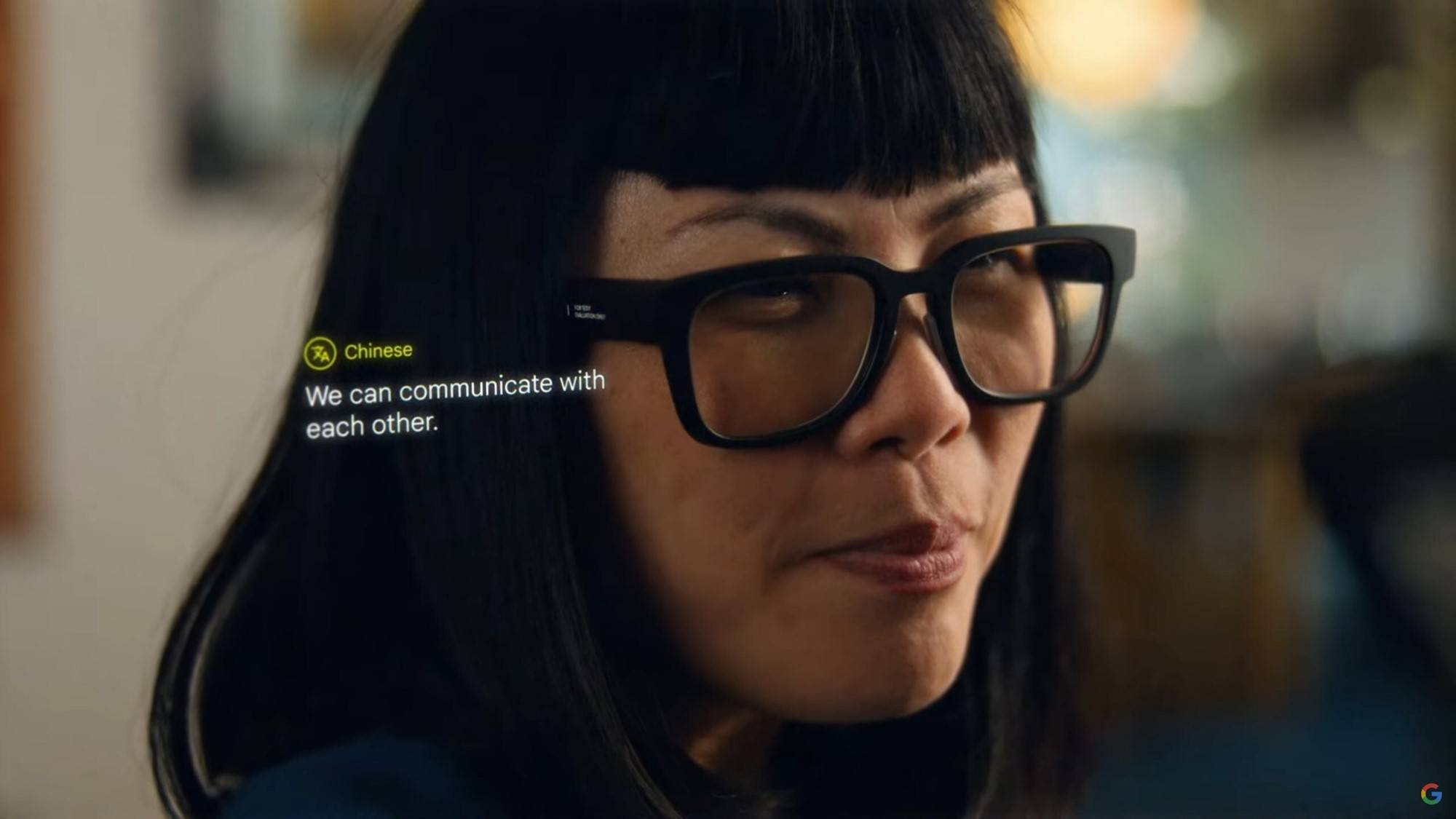

Der Inhalt der jährlichen Google Developers Conference hat ebenfalls begonnen, sich der KI zuzuwenden, was die tiefe Stärke von Google auf dem Gebiet der KI nach außen zeigt.

Auch die Außenwelt glaubt allgemein, dass Google die Führung bei der Transformation der KI-Industrie übernehmen wird.

Bis ChatGPT, um genau zu sein, das Erscheinen von GPT-3 und dem anschließenden Erscheinen von GPT-4, ist Midjourney V5 heiß.

Bevor Google reagieren konnte, ergriff Microsoft die Gelegenheit und kooperierte mit OpenAI, um ChatGPT auf das neue Bing anzuwenden, was eine „Such“-Revolution auslöste.

Als Google wieder zur Besinnung kam, startete es über Nacht Bard. Sobald es online ging, machte es ein oolonges Durcheinander, es gab viele sachliche Fehler, und es unterstützt bisher nur Englisch.

Verglichen mit ChatGPT und New Bing ist es zu unterlegen.

Die Folge des überstürzten Starts von Bard ist eine Vertrauenskrise und der Aktienkurs stürzte ab.Auch wenn Google es später anpasst, ist die Wirkung von Bard noch immer nicht mit ChatGPT zu vergleichen.

Infolgedessen sagten einige Mitarbeiter von Google auch, dass Bard einige ethische Maßstäbe überhaupt nicht erfüllt habe und dazu neigte, zu lügen und negative Bemerkungen zu machen.

Während interner Tests bat ein Mitarbeiter Bard um Anweisungen zur Landung des Flugzeugs, und es antwortete mit Schritten, die leicht zu einem Absturz führen könnten.

Ein anderer Mitarbeiter stellte Bard eine Frage zum Tauchen und erhielt Antworten, die leicht zu schweren Verletzungen oder zum Tod führen konnten.

Neben diesen gefährlichen Antworten hat Google auch seine Anforderungen in einigen ethischen und sozialen Fragen gelockert.

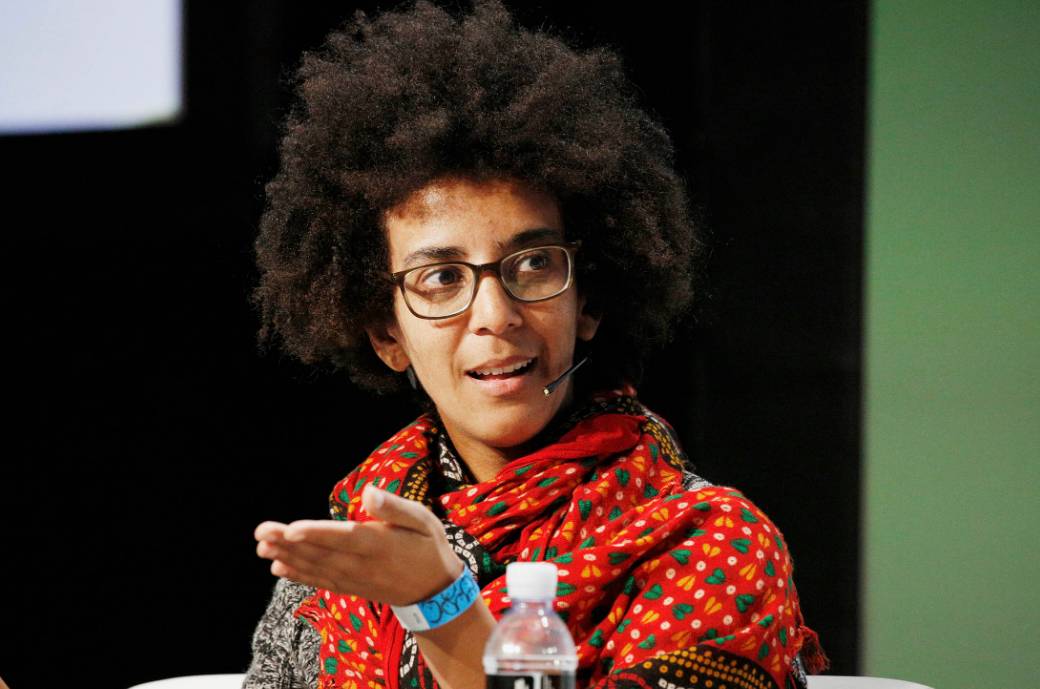

Innerhalb von Google gibt es ein KI-Ethikforschungsteam, das die von KI ausgehenden Risiken untersucht, ermittelt und bewertet.

Sie haben das Recht, eine Technologie direkt mit einem roten Etikett zu versehen, und wenn sie den Test nicht besteht, wird sie der Öffentlichkeit vorübergehend nicht zur Verfügung stehen.

▲ Timnit Gebru, ehemaliger Forscher des KI-Ethikteams von Google Bild von: Bloomberg

Für 2021 versprach Google zudem, das KI-Ethik-Forschungsteam zu erweitern und mehr Ressourcen zu investieren, um die Gewinnsucht technischer Forscher einzudämmen.

Interessant ist jedoch, dass die Führung des Teams gewechselt hat und im vergangenen Jahr auch eine Runde von Entlassungen erlebt hat.

Google hat derzeit 30-mal mehr KI-bezogene technische Forscher als das Team für ethische Sicherheit.

Selbst nachdem ChatGPT der AIGC-Branche den Donner gestohlen hatte, geriet Google ins Wanken, und den Mitgliedern des Ethikteams wurde gesagt, sie sollten keine generativen KI-Tools, die entwickelt wurden, behindern oder „töten“.

Nachdem Google sich internen Tests unterzogen und viele "Fragen" erhalten hatte, sah es sich kommerziellem Druck von Microsoft und ChatGPT ausgesetzt und entschied sich schließlich dafür, es unter dem Namen "experimentelles Produkt" zu veröffentlichen.

Denn in manchen statistischen Erhebungen werden experimentelle Produkte auch mit Mängeln eher von der Öffentlichkeit angenommen.

Und einige Mitarbeiter glauben auch, dass die möglichst frühe Ankündigung neuer Technologien an die Öffentlichkeit schnell Feedback erhalten und Produkte schneller verbessern kann.

Tatsächlich hat Google lange Zeit nach der Veröffentlichung von Bard nur eine Änderung vorgenommen und eine Modifikation der mathematischen Logik hinzugefügt.

Ob einige heikle Zäune und heikle Themen geändert und optimiert wurden, wurde nicht erwähnt.

Bard scheint auch in der sich ständig verändernden KI-Welle ins Abseits zu geraten.

Musk: ta muss beaufsichtigt werden

Interessanterweise sprach Musk fast vor und nach Pichais Interview auch in Fox News über Google.

Musk und Google-Gründer Larry Page waren früher eng befreundet, Page kaufte sogar 10 % der SpaceX-Aktien und wollte zum Mars, um mit Musk Sand zu spielen.

Aber im Jahr 2014, nachdem Google DeepMind übernommen hatte, hatten die beiden unterschiedliche Ansichten über KI und kommunizierten schließlich nicht mehr miteinander.

Im selben Jahr sagte Page in einer TED-Rede, sein ultimatives Ziel sei es, eine superdigitale künstliche Intelligenz zu bauen, die er einen „digitalen Gott“ nennt.

In Bezug auf diese Idee hat Pichai im Interview mit "60 Minutes" weder dementiert noch zugestimmt.

Stattdessen sagte er nur, dass Google auf seiner Developer I/O-Konferenz am 10. Mai neue KI-Produkte veröffentlichen werde.

Und Musk hat ein klares Verständnis vom „digitalen Gott". Google verfügt über ein hochleistungsfähiges Computer- und Künstliche-Intelligenz-Team, das weltweit fast eine Monopolstellung einnimmt, und es ist am wahrscheinlichsten, den sogenannten „digitalen Gott" zu erreichen.

Aber Page, der Leiter des Unternehmens, kümmert sich nicht um die Sicherheitsprobleme, die durch KI verursacht werden, was für die Welt ziemlich gefährlich ist.

Dies ist auch der Grund, warum er kürzlich in das Spiel einsteigen wollte, nachdem er ChatGPT, New Bing und Bard wie Unsinn gesehen hatte, und ein ähnliches Produkt namens TruthGPT auf den Markt brachte.

Darüber hinaus fordert Musk auch verschiedene Länder und Organisationen auf, entsprechende Richtlinien einzuführen, um einige unverschämte Verhaltensweisen von KI einzuschränken.

Aufgrund der Eigenschaften der generativen KI stammen seine Daten aus Internetforen, Zeitungen, Websites usw. Da diese Daten nicht desensibilisiert und nicht streng eingeschränkt sind, können leicht riskante, schädliche oder ungenaue Bemerkungen generiert werden.

Hinzu kommt, dass beim derzeitigen Boom in der AIGC-Branche die Marktteilnehmer wie Goldwaschen sind, als würde die künstliche Intelligenz in eine neue Entwicklungsstufe eintreten.

Die aktuellen Modelle im großen Maßstab und hochrechnende industrielle Erzeugungsmethoden machen es der KI jedoch auch leicht, von großen Unternehmen monopolisiert zu werden.

Wenn es ihnen schwer fällt, intern abzuwägen, ob sie Profit anstreben oder die Sicherheit wahren sollen, machen sie leicht Fehler in der KI-Orientierung, die irreparable Folgen haben.

Auch wenn Musk in Bezug auf AIGC ein wenig egoistisch ist, ist Musk in der Tat viel nüchterner, wenn es um einige wichtige Themen geht.

Mit großer Macht kommt große Verantwortung

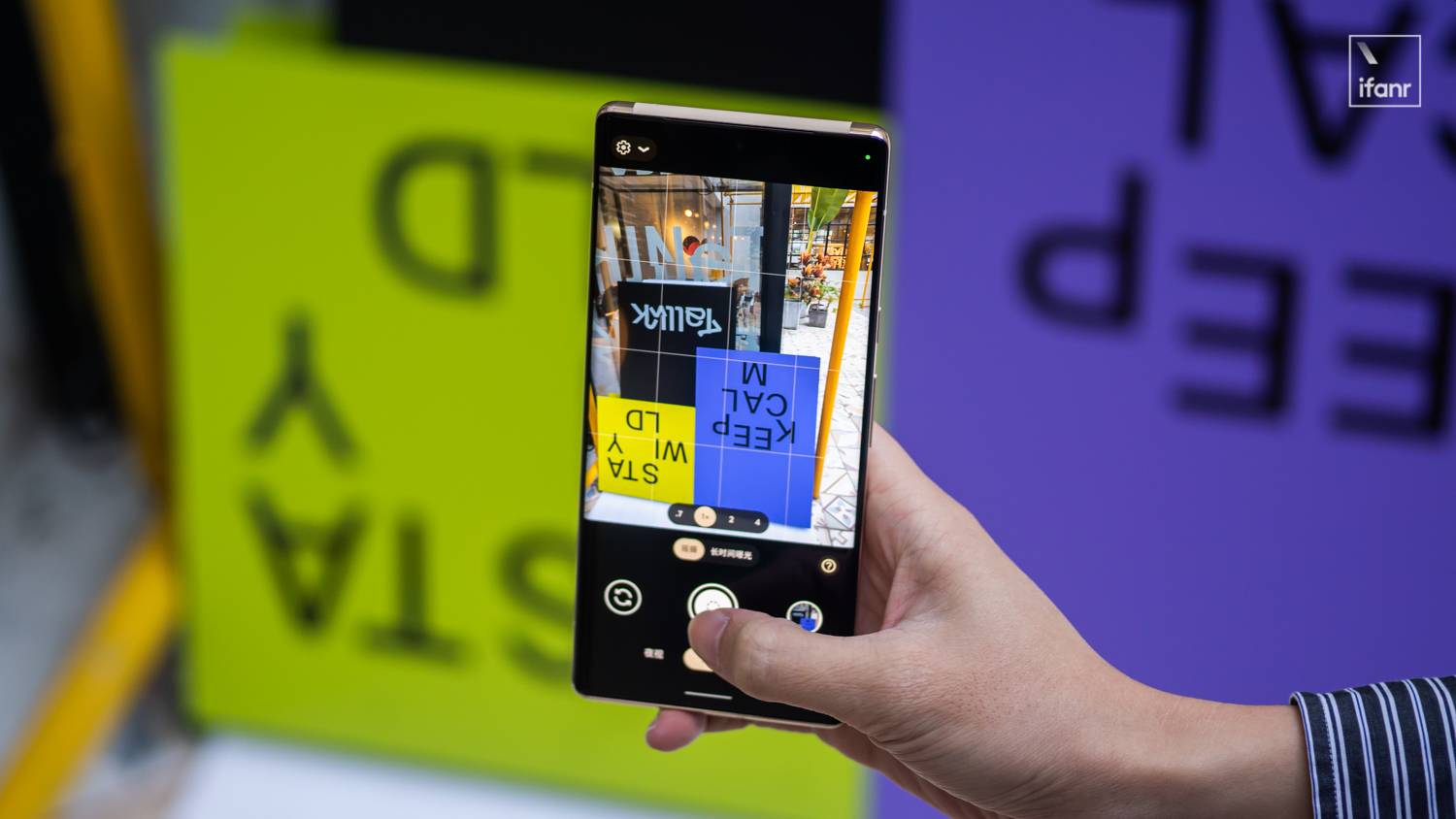

Google Fotos wird die KI-Bilderkennung verwenden, um Bilder zu markieren und den Benutzern beim Sortieren von Bildern für die Klassifizierung zu helfen.

Dies ist eine der früheren KI-Anwendungen von Google. Auch wenn Google Fotos die freie Kapazität angepasst hat, ist es immer noch eine meiner am häufigsten verwendeten Apps.

Aber im Jahr 2015 hat Google Fotos ein Bild eines schwarzen Softwareentwicklers und seiner Freunde fälschlicherweise als „Gorilla“ bezeichnet.

Eine normalere Reaktion wäre, sich zu entschuldigen und den Algorithmus umzugestalten, um diesen Erkennungsfehler schrittweise zu beheben.

Google entschied sich jedoch dafür, die Suchergebnisse für „Gorilla“, „Schimpanse“ und „Affe“ insgesamt zu entfernen.

Das Problem, mit dem Google Bard heute konfrontiert ist, besteht darin, dass Google immer noch kein Gefühl dafür hat, Verantwortung zu übernehmen, und sich immer noch dafür entscheidet, diese herabzusetzen.

Um ChatGPT einholen zu können, hat das interne KI-Ethik-Team von Google keine umfassende Bewertung vorgenommen, sondern nur zu sensiblen Themen recherchiert und es schließlich in aller Eile auf den Markt gebracht.

Bloomberg zitierte auch die Bewertung eines ehemaligen Leiters des KI-Ethikteams, der glaubt, dass Google immer umstritten war, wenn es darum ging, hochmoderne KI oder KI mit einem moralischen Endergebnis zu entwickeln.

Tatsächlich enthüllte in der AIGC-Branche nicht nur Google, sondern auch die Financial Times, dass Technologiegiganten wie Microsoft und Amazon KI-Ethikteams in großem Umfang abschaffen.

Es scheint, dass in dem Moment, in dem AIGC sich schnell entwickelt und miteinander konkurriert, die KI-Ethik und die KI-Sicherheit die Fesseln beeinflusst haben, die sie sich gegenseitig jagen.

Wie in dem Bericht von Forschern der Stanford University festgestellt wird, hat sich die rasante Entwicklung der KI-Industrie von der Wissenschaft zur Industrialisierung verlagert.Unter der Versuchung kommerzieller Interessen entstehen verschiedene KIs, aber die Ethik, Sicherheit und Sensibilität dahinter sind schädlich und andere Informationen werden nach und nach ignoriert.

Große Unternehmen sind auch nicht mehr bereit, mehr soziale Verantwortung zu übernehmen, und stehen nur noch am Rande von Gesetzen und Vorschriften, die letztendlich tiefgreifende Auswirkungen auf die Gesellschaft und die KI-Industrie haben können.

Derzeit untersuchen und formulieren viele Länder und Regionen und sogar einige Unternehmen und Organisationen aktiv einige Regeln, um die unkontrollierte Entwicklung von KI einzuschränken.

Wie Yin Sheng, ehemaliger stellvertretender Chefredakteur der Forbes Chinese Edition, sagte : „Große Unternehmen müssen mehr tun, als die Benutzer und das Gesetz verlangen, denn wenn Sie eine neue Welt schaffen und davon profitieren, müssen Sie der gesamten Gesellschaft helfen, zu lernen, wie um es zu regieren, wenn du nicht die Initiative ergreifst, übernimmt die Gesellschaft.“

#Willkommen beim offiziellen öffentlichen WeChat-Konto von Aifaner: Aifaner (WeChat-ID: ifanr). Weitere spannende Inhalte werden Ihnen so bald wie möglich präsentiert.

Ai Faner | Ursprünglicher Link · Kommentare anzeigen · Sina Weibo