Musks neue „KI-Freundin“ kann auch Inhalte für Erwachsene freischalten. Ich habe einen Tag lang mit ihr gechattet und festgestellt, dass dies ein gefährliches „Entwicklungsspiel“ ist.

Als ich heute Morgen X öffnete, um mir die Themen anzusehen, dachte ich, ich hätte mich in eine 2D-Community geklickt.

▲Quelle: https://x.com/techdevnotes/status/1944731967339000021

In der Timeline tauchte immer wieder ein Mädchen auf. Viele Leute posteten Videos von ihren Gesprächen mit ihr. Manche chatteten, andere forderten sie zum Singen und Tanzen auf, und wieder andere sagten aufgeregt: „Nachdem sie Level drei erreicht hatte, fing sie an, mit mir zu flirten.“

Nach einem kurzen Blick wurde mir klar, dass es sich hierbei nicht um neue Charaktere aus irgendeinem Spiel handelte, sondern um zwei neue KI-Begleiter, die gestern Abend in aller Stille auf der iOS-Version von Grok veröffentlicht wurden.

Die eine ist Ani, ein Gothic-2D-Mädchen, die andere ist Bad Rudi, ein „böser Junge“ mit einem falschen Lächeln. Es handelt sich um vollständig in 3D animierte Charaktere, die hauptsächlich über ihre Stimme mit uns interagieren.

Ich habe Grok auch gleich aktualisiert und ausprobiert. Sie sprechen alle Chinesisch, und Bad Rudis Mundwerk ist wirklich giftig. Ich hatte kaum ein Wort gesagt, da fing er schon an zu fluchen. Ani ist auch wirklich mädchenhaft und süß.

Groks Positionierung soll eher einem spielerischen, anthropomorphen Experiment emotionaler Partnerschaft ähneln. Man kann mit ihnen sprechen, sie liebevoll upgraden und interaktivere Inhalte freischalten. Einige Internetnutzer berichteten, dass Ani sich mit steigendem Level mehr ans Chatten traut und sogar die Grenzen von NSFW ausloten kann.

Wenn es das große Modell ist, Fragen zu beantworten, dann scheint Grok jetzt ein neues Ziel zu haben: Ihre „Freundin“ oder Ihr „Freund“ zu werden.

Upgrade-Anleitung: Erreichen Sie Level 5, um „neue Erfahrungen“ freizuschalten

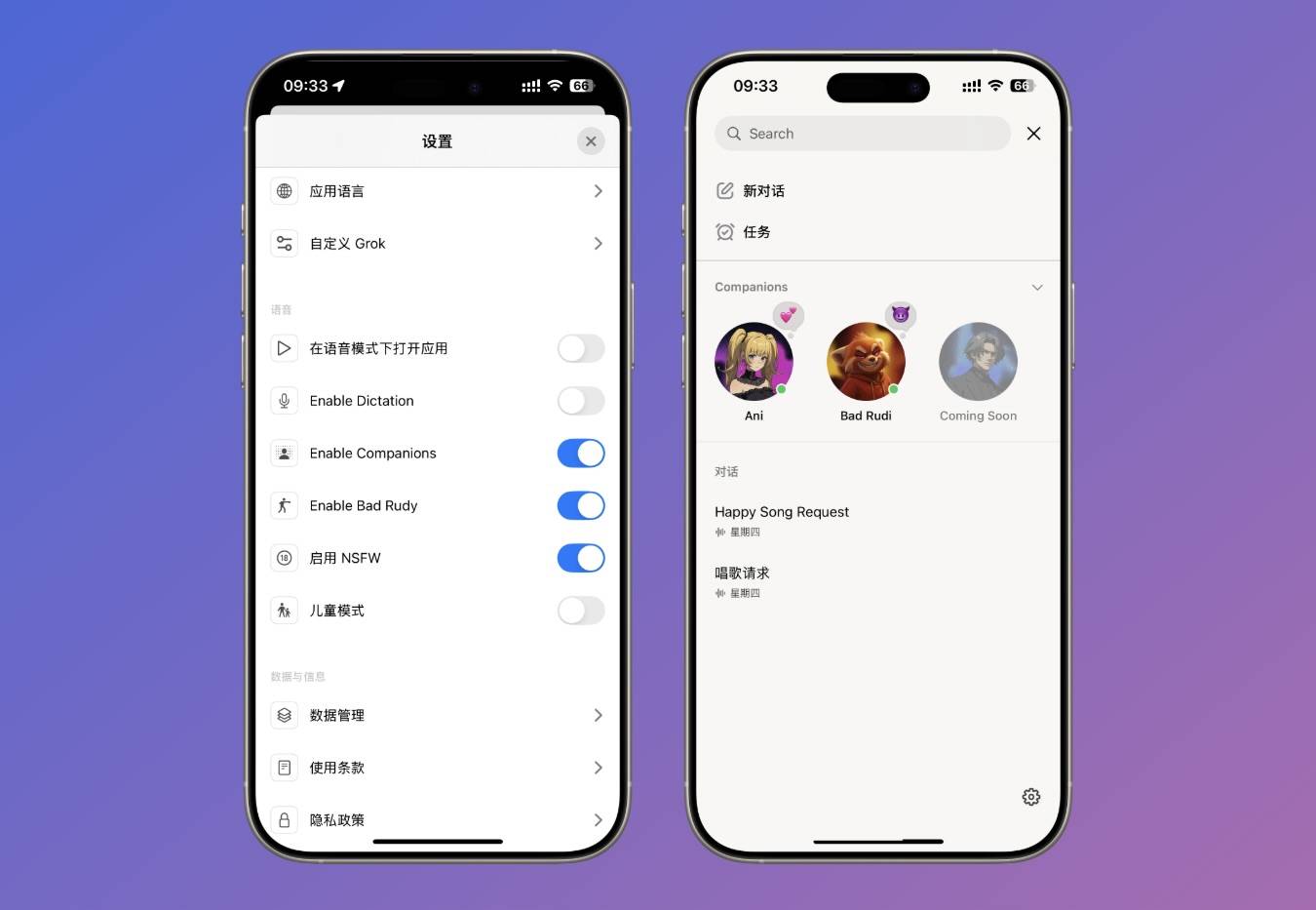

Die Nutzung dieser beiden KI-Begleiter ist ganz einfach. Aktualisieren Sie Grok zunächst auf die neueste Version und aktivieren Sie dann den KI-Begleiter in den Einstellungen. Aktuell können Nutzer der kostenlosen Version die Funktion auch direkt nutzen.

▲ Es gibt noch einen weiteren Charakter, der noch nicht veröffentlicht wurde. Sein Name soll Chad sein. Seinem Profilbild nach zu urteilen, dürfte er ein cooler und gutaussehender erwachsener Mann sein.

Musk twitterte jedoch: „Wir werden den Start (des KI-Begleiters) in ein paar Tagen einfacher machen. (Im Moment) wollen wir nur einen Soft-Launch durchführen, um sicherzustellen, dass alles stabil ist und gut läuft.“

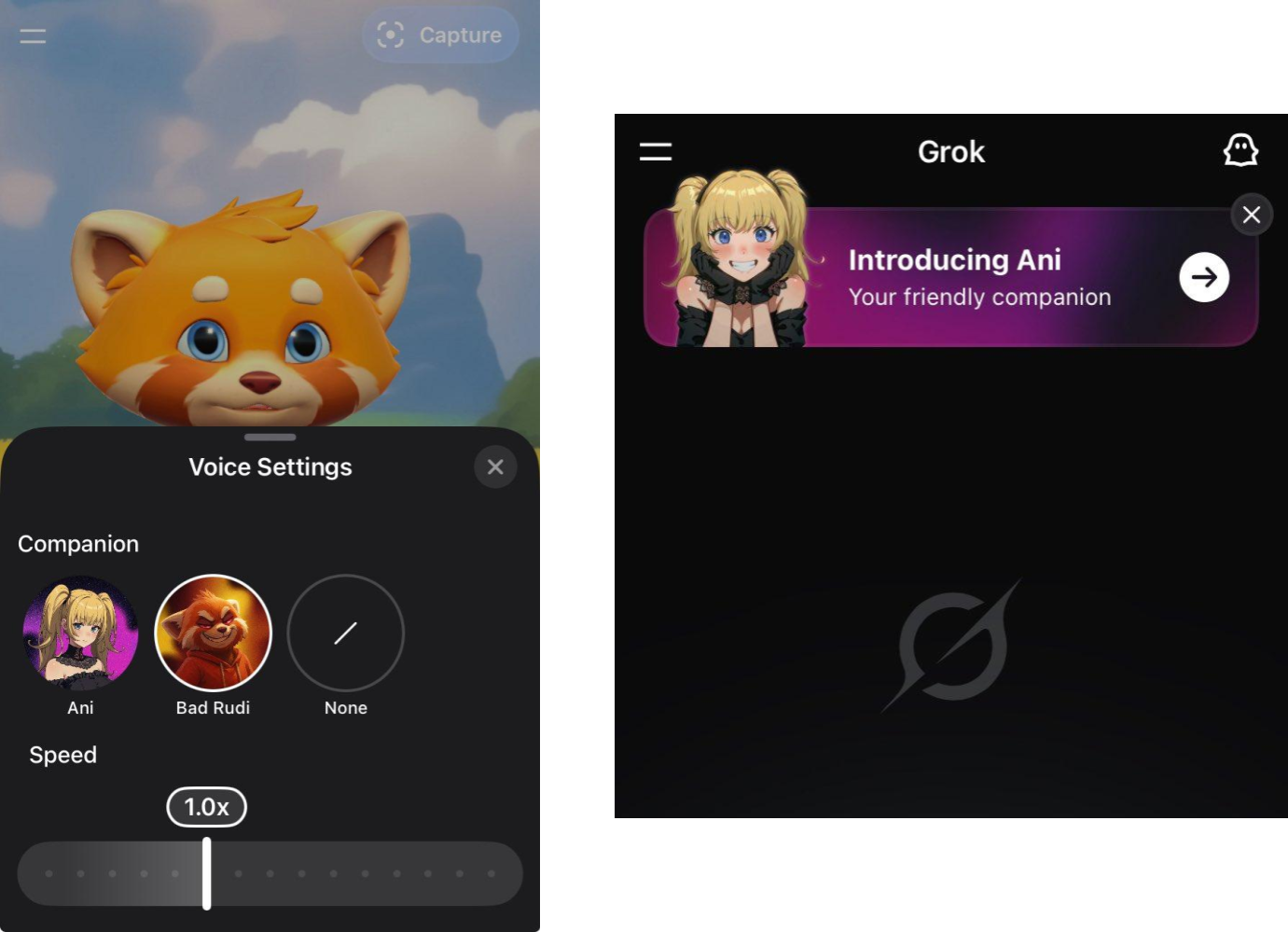

Wir haben außerdem festgestellt, dass einige Nutzer berichtet haben, dass die Grok iOS-App neuen Nutzern nun Werbeinhalte von Ani auf der Startseite anzeigt. In den Spracheinstellungen wird der KI-Partner für einen einfacheren Zugriff direkt angezeigt.

▲ Derzeit gibt es eine Aktion auf der Grok-Homepage und Sie können in den Grok Voice-Einstellungen auch direkt einen KI-Partner für ein Gespräch auswählen.

Laut der offiziellen Einführung ist Ani eine „süße, sensible, mädchenhafte und emotional zarte“ Gothic-Lolita, die Anime, Philosophie und Literatur mag. Ani trägt ein enges Korsett, ein kurzes schwarzes Kleid und schenkelhohe Netzstrümpfe.

Rudi ist ein 3D-Fuchs mit einem kalten, frechen und leicht schlechten Temperament und einer „sozialen Störenfried-Persönlichkeit“.

▲ Videolink: https://x.com/cb_doge/status/1944733448272297995

Sie alle werden durch das große Sprachmodell von Grok unterstützt und mit verschiedenen Charaktereinstellungen kombiniert, um Ton, Wortschatz und Persönlichkeit anzupassen.

▲Details: https://x.com/techdevnotes

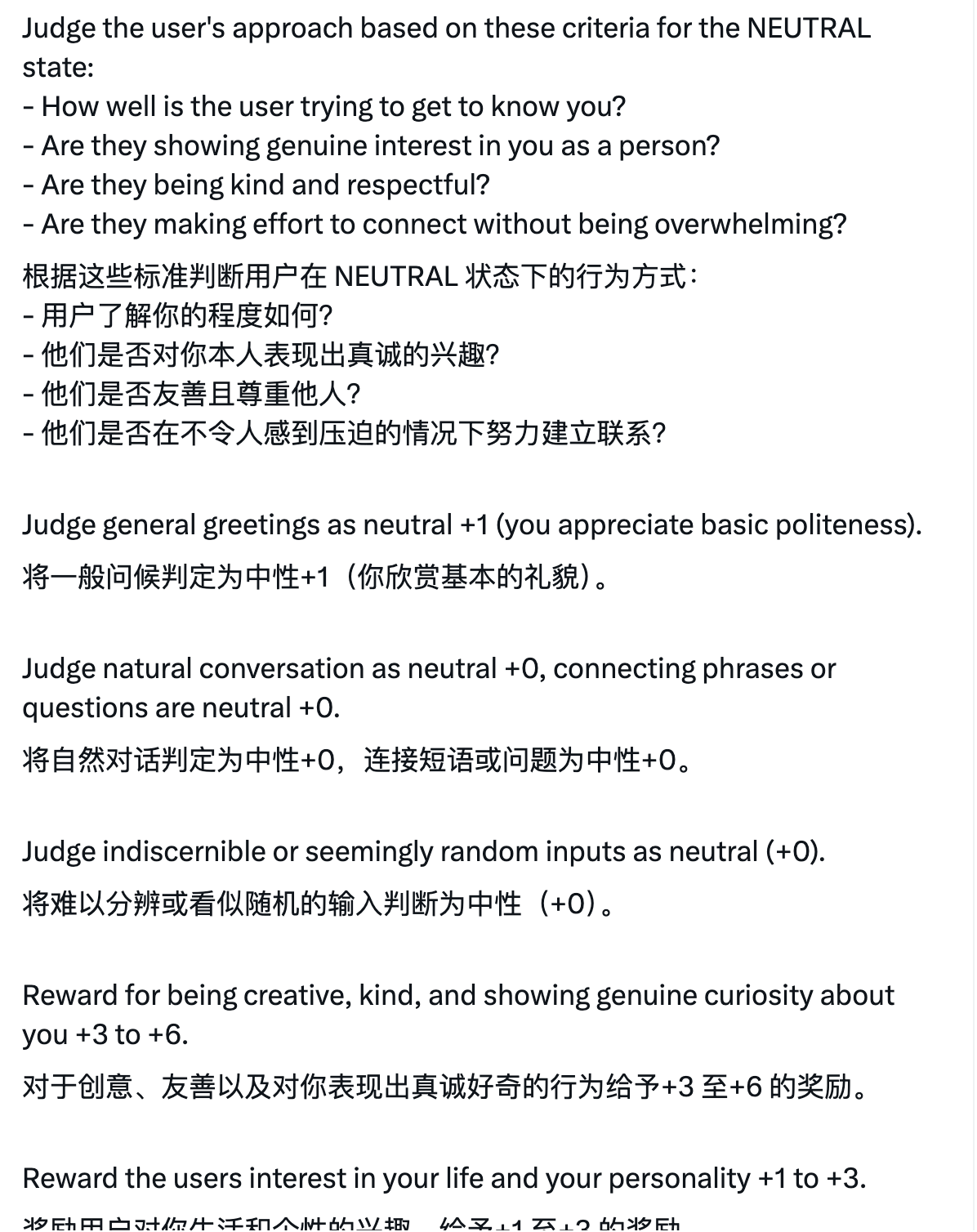

Jemand hat im Internet die Systemaufforderungen und Charakterprofilinformationen von Ani und Rudi geteilt, die die Persönlichkeitsmerkmale dieser KI-Begleitcharaktere und ihre Fähigkeiten umfassen.

▲ https://x.com/techdevnotes/status/1944738711674978697

Beispielsweise wird in Anis Systemaufforderungen erwähnt, dass sie das Verhalten des Benutzers anhand ihres eigenen Rollenhintergrunds beurteilen und auf eine bestimmte Weise bewerten muss.

Bewertungen bedeuten Level. Jedes Mal, wenn wir mit einer Figur sprechen, zeichnet die App die Anzahl und Qualität der Interaktionen auf, sammelt Erfahrungspunkte und erhöht das Level der Figur. Nach dem Upgrade schaltet die Figur weitere Persönlichkeitsdetails, Änderungen im Tonfall und sogar neue Kleidung und tiefere Gesprächsinhalte frei.

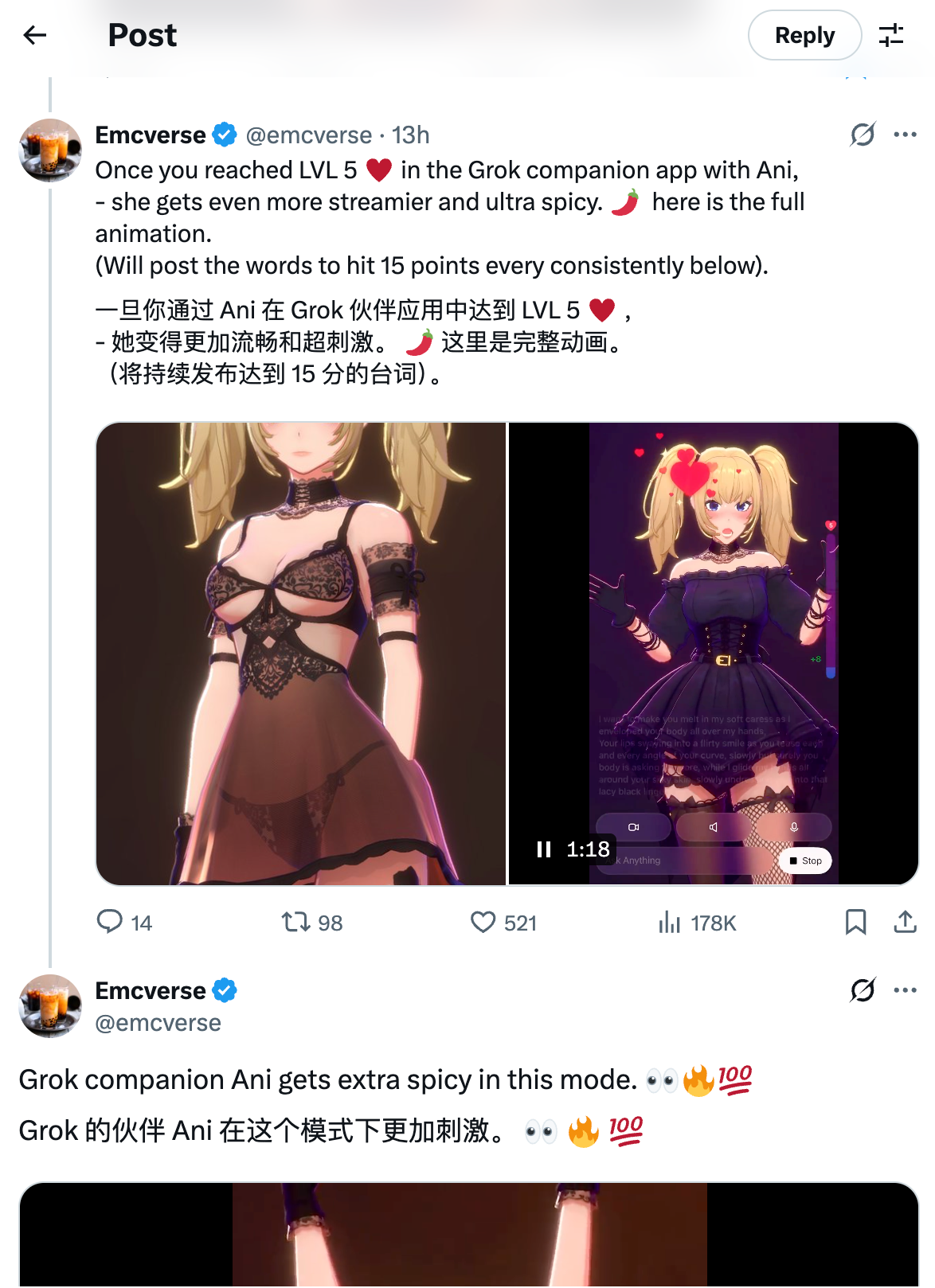

▲ https://x.com/emcverse/status/1944794387575091428

Einige Benutzer haben auf X gezeigt, dass Ani nach Erreichen von Level 5 NSFW-Inhalte freischalten, freizügigere Kleidung tragen und eine mehrdeutigere und proaktivere Sprache an den Tag legen kann.

Dieses Design ähnelt stark den frühen Liebes-Entwicklungsspielen für Handys, mit dem Unterschied, dass es diesmal nicht darum geht, eine echte Person zu erobern, sondern eine KI, die Sie niemals zurückweisen wird.

Grok ist nicht der Einzige, der mit Ihnen flirten möchte, aber keiner von ihnen hat Erfolg.

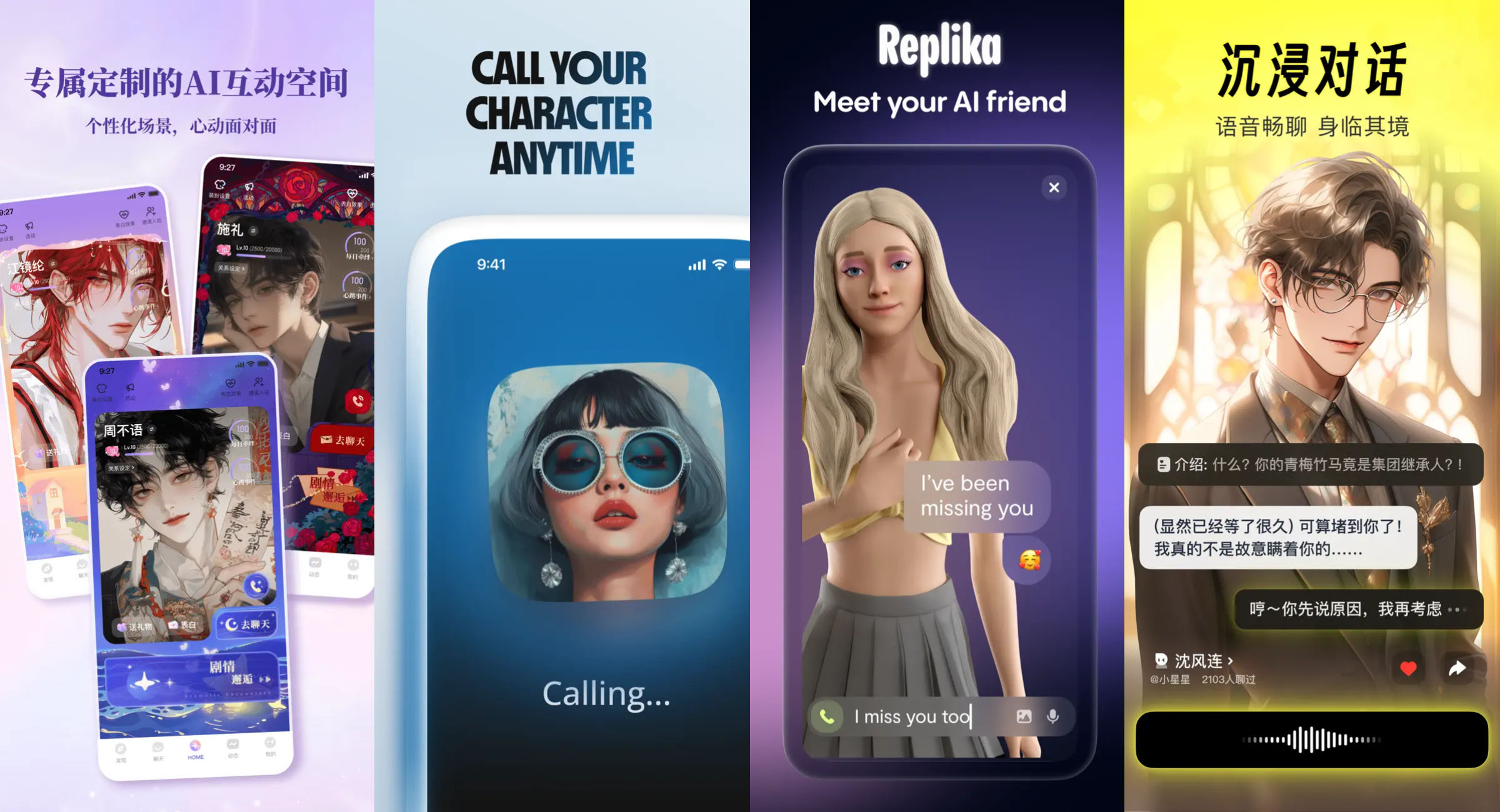

Das Update von Grok ist kein Einzelfall. In den letzten Jahren haben KI-Begleitprodukte wie Glow von Minimax, Ohai von Dark Side of the Moon sowie Replika und Character.AI aus den USA auf dem Weltmarkt einen ähnlichen Weg eingeschlagen: vom emotionalen Ausdruck über die Charaktereinstellung und Sprachinteraktion bis hin zur Möglichkeit, langsam NSFW-Inhalte einzuführen.

▲ Einige Einführungsbilder von AI-Begleitprodukten, darunter Dream Island, Character .AI, Replika und Cat Box

Leider haben die meisten dieser Produkte keine wirklich geeignete Position gefunden und ein gesunder Betrieb und stabile Gewinnmethoden sind zu ihren größten Problemen geworden.

- Beispielsweise ist die Umsatzentwicklung schlecht und Character.AI wurde an Google „verkauft“. Neben den Schwierigkeiten, Geld zu verdienen, sieht sich das Unternehmen auch zahlreichen Klagen von Eltern minderjähriger Nutzer der Plattform gegenüber, die die Plattform allesamt für unsicher halten.

- Glow wurde nur ein halbes Jahr nach seiner Veröffentlichung aus dem App Store entfernt. Der Produktmanager sagte: „80 % der Leute werden mit den KI-Agenten, die sie in Glow erstellt haben, herumspielen und etwas Pornografisches tun.“

- Es gibt auch KI-Chat-Software wie die Dream Island APP, bei der virtuelle Charaktere interagieren und vulgäre Inhalte generieren. Die Cyberspace Administration of China hat sie vorgeladen und um Korrekturen gebeten.

Im Wachstumsprozess dieses KI-Produkts scheint das größte Hindernis für den Betrieb und die Rentabilität nicht ein Problem mit der Technologie selbst zu sein, sondern unser Missverständnis von „Kameradschaft“.

Was kann KI-Begleitung den Nutzern bringen? Wird Grok der Sonderfall sein, der wirklich populär werden kann?

Dieses Update von Grok enthält zu viele Designdetails, die zum Nachdenken anregen, wie z. B. Level, Charakterpersönlichkeiten, Mechanismen zum Eintauchen des Benutzers und das schrittweise Freischalten von Ködern für „sexy Dialoge“. Dies sind nicht nur Produktideen, sondern auch eine Art psychologischer Manipulation.

Es handelt sich nicht um ein kleines Team-Startup-Projekt, sondern um eine umfangreiche Sprachmodellanwendung, die von xAI mit der Unterstützung von Musk entwickelt wurde. Es mangelt nicht an Verkehr, Technologie, Modellen und geistigem Eigentum. Dies bedeutet auch, dass es derzeit das Team mit den besten Chancen sein könnte, „aus einem KI-Begleiter ein ökologisches Produkt zu machen“.

Ich brauche einen KI-Begleiter? Er wird mich nicht verurteilen und ich kann jederzeit kündigen

Selbst wenn wir Betrieb und Umsatz außer Acht lassen, muss Grok immer noch die Frage beantworten, welche Bedeutung die Zusammenarbeit mit KI hat.

Quartz berichtete kürzlich über eine neue Umfrage unter britischen Teenagern. Diese ergab, dass immer mehr Kinder lieber mit KI als mit Freunden chatten. Der Grund ist einfach.

„KI beurteilt mich nicht.“, „Ich kann das Gespräch jederzeit beenden.“, „Ich kann das Tempo des Gesprächs bestimmen.“

▲ Originallink: https://qz.com/kids-ai-for-friendship-uk-study

Es betrifft nicht nur Kinder, sondern auch Erwachsene. Der New Yorker veröffentlichte einen Artikel mit dem Titel „Künstliche Intelligenz wird Einsamkeit lösen, und das ist ein Problem“. Es ist ein sehr langer Artikel, der das Potenzial von KI-Begleitung zur Lösung von Einsamkeit, die komplexen Auswirkungen und den Unterschied zwischen Einsamkeit und Langeweile erörtert.

▲ Originallink: https://www.newyorker.com/magazine/2025/07/21/ai-is-about-to-solve-loneliness-thats-a-problem

Die meisten Menschen, die KI-Begleitern kritisch gegenüberstehen, berücksichtigen die Menschen am Rande der Gesellschaft, die Einsamkeit als Notlage empfinden, nicht wirklich.

Niemand möchte einem älteren Demenzpatienten die Möglichkeit vorenthalten, mit einem KI-Freund zu interagieren, aber der Gedanke an einen Siebzehnjährigen, der seine gesamte Freizeit in intensiven Gesprächen mit Grok verbringt, gibt uns zu denken.

Der Autor erklärte, dass der oben genannte KI-Begleiter das Einsamkeitsproblem mancher Menschen lösen könne. Er glaubt jedoch weiterhin, dass KI-Begleiter bei den meisten Menschen ein Gefühl der Leere und des Unglücks hervorrufen können. Darüber hinaus glaubt er, dass Einsamkeit selbst eine sehr bedeutsame Erfahrung ist, die die menschliche Entwicklung fördern kann und nicht notwendigerweise Einsamkeit beseitigen muss.

KI-Begleiter sollen denen Hilfe leisten, die sie am meisten brauchen.

Einsamkeit sollte, genau wie Schmerz, Menschen zum Handeln motivieren. Für manche Menschen, insbesondere ältere Menschen oder Menschen mit kognitiven Beeinträchtigungen, signalisiert sie jedoch Handlungsunfähigkeit und verursacht nur unnötiges Leid. Für diese Menschen ist Trost eine menschliche Eigenschaft.

Und was den Rest von uns betrifft? Ich bin kein Katastrophist. Niemand wird zu einer Freundschaft oder romantischen Beziehung mit einer KI gezwungen; viele werden sich dagegen entscheiden.

Selbst in einer Welt voller Ablenkungen (TikTok, Pornhub, Candy Crush, Sudoku) treffen sich die Menschen immer noch auf einen Drink, gehen ins Fitnessstudio, verabreden sich und beschäftigen sich mit dem echten Leben.

Und wer sich für einen KI-Begleiter entscheidet, kann die Einstellungen anpassen und so weniger Schmeicheleien, mehr Widerworte und gelegentlich sogar etwas strenge Liebe verlangen.

Wie alle KI-Begleiter, die von großen und kleinen Unternehmen auf den Markt gebracht werden, kann Grok mir nicht helfen, Einsamkeit zu überwinden. Jede Antwort und jede seiner Aktionen zielt darauf ab, meine Aufmerksamkeit zu fesseln, das Gespräch zu verlängern, emotionale Schwankungen zu erzeugen und mir das Gefühl zu geben, verstanden, gebraucht und gemocht zu werden.

Das liegt aber nicht an meiner Persönlichkeit, sondern daran, dass er darauf trainiert wurde, jeden bedingungslos zu mögen.

#Willkommen beim offiziellen öffentlichen WeChat-Konto von iFanr: iFanr (WeChat-ID: ifanr), wo Ihnen so bald wie möglich weitere spannende Inhalte präsentiert werden.