Musks und Ultramans chinesische Tirade: KI-Video verwandelt sich endlich von einem „Spielzeug“ in ein „Werkzeug“

Wer heutzutage in den sozialen Medien surft, findet virale Videos mit beeindruckenden Bildern, die oft von KI erstellt wurden. Als Ersteller gibt es jedoch neben der bloßen Erstellung eines „Kartenziehens“ ein weiteres Problem, das nicht ausreichend berücksichtigt wurde.

Das Problem ist der Dialog.

Wenn ich beispielsweise eine KI auffordere, eine schöne Regenszene zu erstellen, ist das nicht schwierig. Wenn ich die KI jedoch auffordere, eine Trennungsszene im Regen mit Handlung und Dialog zu erstellen und der Dialog in authentischem Chinesisch sein muss, ist das eine sehr knifflige Aufgabe.

Der von der KI generierte Inhalt ist entweder eine komplette „Pantomime“, die vom Ersteller später Lippensynchronisation und Synchronisation erfordert; oder er kann sprechen, aber die Stimme und Intonation sind unnatürlich, voller „Mensch-Maschine-Gefühl“ und „Übersetzungston“, was die eigentlich traurige Handlung sofort ruiniert.

Dies ist auch eine der größten Herausforderungen bei der aktuellen KI-Videogeneration: der Umgang mit Dialogen, insbesondere chinesischen Dialogen mit komplexen Emotionen.

Man kann sagen, dass die Fähigkeit von KI-Videos, natürliche und fließende chinesische Gespräche zu verarbeiten, der Schlüssel dazu ist, ob sie sich von einem Spielzeug, das „zum Spaß“ dient, in ein echtes Produktivitätstool verwandeln können.

Baidus heute veröffentlichtes MuseSteamer-Videomodell 2.0 scheint dieses zentrale Problem zu lösen. Sein auffälligstes Merkmal ist die weltweit erste integrierte chinesische Audio- und Video-Generierungstechnologie. Basierend auf einem chinesischen Korpus kann es in einem einzigen Schritt chinesische Konversationsvideos mit synchronisiertem Audio und Video, präzisen Lippenbewegungen und natürlichen Emotionen generieren.

Um zu überprüfen, ob es die Probleme der Entwickler wirklich löst oder nur eine technische Demonstration im Werbevideo ist, habe ich beschlossen, die offiziell ausgewählten Fälle (Demos) zu umgehen und ein paar „knifflige“ Szenen zu entwerfen, die den täglichen kreativen Bedürfnissen gewöhnlicher Menschen näher kommen, um ihre Realität selbst zu erkunden.

Erlebnisadresse: https://huixiang.baidu.com/

Von der Bild- zur Klangkonfrontation

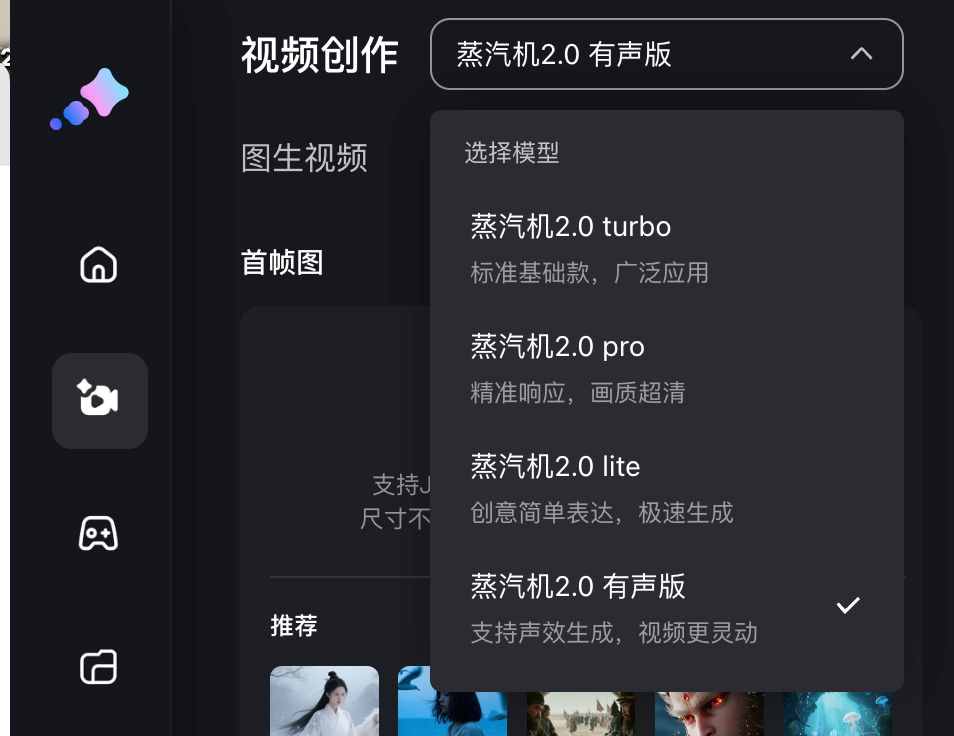

Baidu Steam Engine bietet dieses Mal Modelle der 4. Generation, die alle aus einem Bild ein Video generieren, nämlich Steam Engine 2.0 Turbo, Pro, Lite und die Audioversion. Unterschiedliche Modelle verbrauchen unterschiedlich viele Punkte und kostenlose Benutzer können durch monatliches Einloggen eine begrenzte Menge an Vorstellungswert (Punkten) erhalten.

Die Audioversion kann 5- oder 10-sekündige Videos erzeugen, während Turbo und die anderen drei Versionen 5 Sekunden lang sind. In Bezug auf die Pixel bieten die anderen drei Versionen mit Ausnahme der Pro-Version, die 1080p unterstützt, eine hochauflösende Bildqualität von 720p.

Wir geben ihm direkt ein Bild und folgen dann den Anweisungen auf der Seite zur Videogenerierung, um den Videoinhalt und die Themenzeilen einzugeben, die Sie generieren möchten. Bei einem 5-Sekunden-Video sollten die Zeilen auf 20 Wörter begrenzt sein, und bei einem 10-Sekunden-Video sollte die Anzahl der Wörter auf 35 Wörter begrenzt sein.

▲ Wir haben ein Foto von Musk und Ultraman mit folgendem Hinweis hochgeladen: Zwei Personen streiten miteinander. Die Person links sagt: „Die KI, die Sie erstellt haben, hat keinen Gewinn.“ Die Person rechts sagt: „Ihr Marketing hat keinen Gewinn.“ Generiert mit der Steam Engine 2.0 Audioversion.

Zunächst einmal wirken Musk und Ultraman auf den statischen Fotos natürlich, ihre Mimik und Körperbewegungen sind recht flüssig und stimmen im Wesentlichen mit den hochgeladenen Bildern überein. Die grundlegende Fähigkeit zur Bild-zu-Video-Generierung ist immer noch sehr solide.

Noch entscheidender ist, dass die Dialoge im Bereich der chinesischen Lippensynchronisation wirklich erstklassig sind. Die Lippenbewegungen entsprechen genau der Aussprache von Wörtern wie „bottom line“ und „marketing“, ohne erkennbare Verzögerung oder Fehlausrichtung.

▲ Ein erstes Bild der Kobolde vom Langlang-Berg, begleitet von einem Stichwort: Im Bild sieht man einen Wildschweinkobold mit einer Mistgabel erwartungsvoll zu dem stämmigen Coach Bear neben ihm aufblicken. Zeilen: (0–5 Sekunden) Der Wildschweinkobold mit der Mistgabel sagt: „Coach, lass uns unsere Rüstung polieren. Wir werden mit mehr Kraft kämpfen!“ (5–10 Sekunden) Der stämmige Coach Bear blickt auf ihn herab und unterbricht ihn ungeduldig: „Wer hat die Zeit? Schneide mir zuerst tausend Pfeile!“

Baidu erwähnte auf der Pressekonferenz ausdrücklich, dass die zugrunde liegende Generierungslogik auf der „ Audio- und Videointegration “ basiere. Ton und Bild würden gleichzeitig erzeugt und nicht erst später zusammengeführt. Beim Training würden Bild und Ton in einem Modell zusammengefasst, um synchrones Lernen zu ermöglichen.

Darüber hinaus gibt es eine bahnbrechende Technologie namens „Latent Multi Modal Planner“. Multimodalität ist leicht verständlich und bezieht sich auf Text, Bilder und Audio. „Latent“ ist ein Begriff aus dem Deep Learning, der sich auf das Erlernen latenter Merkmale konzentriert. Diese Technologie kann im latenten Generierungsraum autonom mehrere Charakteridentitäten, Zeilen und Interaktionslogiken planen.

Laienhaft ausgedrückt können wir uns das wie einen in die KI eingebauten Regisseur vorstellen. Wenn er die Anweisung erhält, „zwei Leute streiten zu lassen“, lässt er die beiden Leute nicht dummerweise gleichzeitig reden, sondern plant selbstständig das Streitskript.

Wir haben auch einige Dialekte wie Nordostchinesisch ausprobiert, um zu sehen, ob es bei Gesprächen mit mehreren Personen keine Probleme geben würde.

▲ Hinweis: Die Frau in Blau auf der linken Seite des Bildschirms flüstert schnell und kalt im nordöstlichen Dialekt: „Schwester, Aufrichtigkeit ist unsere Kohle, aber sie ist auch das Feuer, das uns zu Tode verbrennt“; die Frau in Lila und Pink auf der rechten Seite des Bildschirms antwortet entschlossen im nordöstlichen Dialekt: „Warum dann nicht, verbrenn es einfach sauberer“; generiert von der Audioversion von Steam Engine 2.0.

Es war eine kleine Herausforderung, Zhen Huan und Shen Meizhuang im integrierten Audio- und Videomodell im nordöstlichen Dialekt sprechen zu lassen, aber die Mimik, die Lippenbewegungen, die Bewegungen der Ohrringe und Kopfbedeckungen der Charaktere wirkten alle sehr natürlich. Die chinesischen Stimmen waren außerdem sehr detailliert, was meiner Meinung nach eine tiefe Anpassung an den chinesischen Kontext zeigt.

Es gibt auch dieses klassische Meme-Bild, das endlich nicht „Komm und probier mein frisches Fleisch“ ist.

Ein Screenshot aus dem Kurzfilm „Wan Wan Wo Xiang“. Die Bildunterschrift lautet: Tang Sanzang, der einen roten Hut trägt, zeigt mit dem Finger auf die Nase des Mannes mit den Hörnern und sagt wütend: „Du willst immer noch mein frisches Fleisch probieren? Auf keinen Fall!“

Baidu Steam Engine löst das kreative Problem, ein einzelnes Bild sprechen und eine Szene darstellen zu lassen. Es vereinfacht den bisher mühsamen Multitool-Prozess zu einer einzigen „Ein Bild + ein Satz“-Operation. Dies steigert zweifellos die Produktivität bei Szenarien wie der Erstellung von Memes, virtuellen menschlichen Dialogen, dem Wissensaustausch und der Sketch-Produktion.

Es ist noch ein weiter Weg, bis wir die Synchronisationsleistungen der kürzlich populären Videos „Empresses in the Palace“ und „Let the Bullets Fly“ wirklich erreichen können. Angesichts des aktuellen Stands der KI-Videogenerierungstechnologie denke ich jedoch, dass es nur eine Frage der Zeit ist, bis KI differenziertere und widersprüchlichere menschliche Emotionen ausdrücken kann. Immerhin wurde das Modell Steam Engine 1.0 Anfang letzten Monats veröffentlicht.

Kann es Kamerabewegungen und große Szenen verarbeiten?

Neben der ersten integrierten Audio- und Videogenerierung mit Zwei-Spieler-Stimme in chinesischen Szenen ist ein weiteres Upgrade von Baidu Steam Engine 2.0 die Bildqualität auf Kinoniveau und die komplexe Kamerabewegung auf Meisterniveau .

In früheren Gesprächsvideos zeigten Emotionen, Mimik und die 3D-Gesichtsgenerierung einen realistischen und detaillierten Charakterausdruck. Wir testeten weiterhin Übergänge und leere Aufnahmen, wie sie in Werbespots und Kurzfilmen üblich sind und neben Gesprächen eine weitere wesentliche Voraussetzung für KI-Videos darstellen.

▲ Geben Sie das erste Einzelbild mit der Aufforderung an: Eine Aufnahme, die mit einer Nahaufnahme eines offenen Buches auf einem Schreibtisch beginnt, langsam nach oben zieht und schließlich auf der verregneten Straßenszene vor dem Fenster einfriert; generiert von Steam Engine 2.0 Pro.

Dem resultierenden Video nach zu urteilen, hat die Steam Engine die Anweisungen perfekt befolgt. Die gesamte Kamerabewegung – Nahaufnahmen, Pull-ups, Standbilder – verlief bemerkenswert flüssig, ohne Verwacklungen oder Missverständnisse. Dies zeugt von ihrem fundierten Verständnis der fotografischen Terminologie.

Wenn KI authentisches Chinesisch lernt, ist ein neuer Wendepunkt in der Videoerstellung erreicht

Nach diesem Test denke ich, dass die Positionierung von Baidu Steam Engine 2.0 sehr klar ist: Es soll kein allumfassendes Modell im Sora-Stil sein, sondern es wurde ein pragmatischerer Weg gewählt: Mit dem „chinesischen Dialog“ als zentralem Durchbruchpunkt hat es KI-Videos von einem interessanten „Spielzeug“ zu einem „Werkzeug“ weiterentwickelt, das als Film bereitgestellt werden kann.

Es vermeidet den internen Wettbewerb, der sich lediglich auf die Qualität und Länge der Bilder bezieht, und verwendet mehr Energie auf die Lösung des kritischsten und am stärksten lokalisierten Problems: KI-Videos dazu zu bringen, wirklich „Chinesisch zu sprechen“ und zwar besser als echte Menschen.

Diese Transformation vom „Spielzeug“ zum „Werkzeug“ wurde in realen kreativen und kommerziellen Bereichen bestätigt.

Yao Qi, ein Hollywood-fähiger Spezialeffekt-Regisseur, hat an Filmen wie „2012“, „Matrix 3“ und „Transformers 3“ mitgewirkt. Er schuf auch die legendären Guzheng-Actioneffekte im chinesischen Science-Fiction-Drama „Die drei Sonnen“. Dieses Mal nutzte er die Baidu Steam Engine, um einen hochwertigen Science-Fiction-Kurzfilm mit über 40 komplexen und aufwendigen Spezialeffekt-Aufnahmen zu erstellen, die jeweils dreimal generiert wurden, sodass insgesamt über 120 Clips entstanden – und das alles für nur 330,6 Yuan.

▲ Pressekonferenzvideo „Heimreise“

Wenn die visuellen Produktionskosten eines Kurzfilms, für die früher ein Budget von mehreren Millionen Yuan erforderlich war, auf ein unvorstellbar niedriges Niveau komprimiert werden, wird nicht nur das Budget untergraben, sondern auch die Schwelle und die Rechte der Schöpfung.

Dabei geht es nicht nur um die Kosten; es geht darum, von der Erstellung eines coolen Clips zum Erzählen einer vollständigen Geschichte zu gelangen. Wenn großartige visuelle Effekte nahtlos in Erzählung und Dialog integriert werden können, entwickelt sich KI von einem Plug-in für Spezialeffekte zu einem hocheffizienten Werkzeug für Kreative.

Auch im Markenmarketing durchbricht dieses Modell den herkömmlichen Videoproduktionsprozess. Yili Beichang musste beispielsweise ein Werbevideo für sein Ziegenmilchpulver mit dem Titel „Ein Schaf überquert das Meer, um dich zu sehen“ produzieren. Herkömmliche Produktionsmethoden dauern in der Regel vier bis sechs Wochen, und die Dreharbeiten umfassten die zauberhafte Reise des „kleinen Lämmchens Shasha“ in einem Heißluftballon über niederländische Wiesen und vorbei an Hightech-Fabriken. Dieser Ansatz war sowohl kostspielig als auch anspruchsvoll.

Dieses Mal nutzte das Produktionsteam eine Dampfmaschine, um diese fantastischen Szenen durch stilisiertes KI-Rendering zu realisieren, was mit Live-Action nur schwer möglich gewesen wäre. Noch wichtiger ist, dass die KI wichtige Verkaufsargumente wie die niederländische Milchbeschaffung und eine probiotische Formel nahtlos in die Erzählung integrierte und so den Produktionszyklus auf nur wenige Tage verkürzte. Die resultierenden visuellen Elemente blieben nahtlos und brachten die Philosophie der Marke perfekt zum Ausdruck.

Ob professionelle Kreative oder unzählige kleine und mittlere Unternehmen und Marken – jeder hat im Grunde einen „Cyber-Stift“ erhalten. Mit nur „einem Bild und einem Satz“ kann man einen statischen Terrakotta-Krieger zum Leben erwecken und einen Anruf tätigen oder Zhang Fei beim Sticken mit einem chatten lassen. Dieses Verschwinden der kreativen Barriere verändert die Kosten und die Wettbewerbsregeln der Content-Branche.

Natürlich ist es kein perfektes Schweizer Taschenmesser . Derzeit ist die Länge der Videos, die es für nicht-dialogische, rein visuelle Effekte erstellen kann, begrenzt, und die Auswahl an Sound und Stil könnte umfangreicher sein.

Im Zeitalter sich schnell entwickelnder KI-Produkte gibt es jedoch kein wirklich perfektes Produkt. Vielmehr sind jene Produkte effektiver, die schneller implementiert werden können, um die tatsächlichen Bedürfnisse der Nutzer zu erfüllen. Baidus Steam Engine vermied die Eitelkeit eines technologischen Wettrüstens und wählte stattdessen einen pragmatischeren und marktorientierteren Ansatz. Sie ist wie ein Hammer, der sich auf das Einschlagen von Nägeln konzentriert. Holz hobeln kann sie zwar nicht, aber das Einschlagen von Nägeln gelingt ihr perfekt.

Wenn ich die KI-generierte Figur frei vor mir sprechen sehe, ohne mich wie eine Maschine zu fühlen, verspüre ich ein Gefühl des Staunens. Werkzeuge werden irgendwann unsichtbar, aber Kreativität wird immer strahlen. Die Dampfmaschine hat den Traum vom Regieführen, einst unglaublich teuer und nur wenigen Auserwählten vorbehalten, wieder allen Menschen zugänglich gemacht, die etwas zu sagen haben.

Heute mangelt es uns nicht mehr an guten Werkzeugen, sondern an frischen Ideen. Und einzigartige Ideen entstehen durch wiederholte Versuche.

Text|Li Chaofan und Zhang Zihao

Um das Video im Artikel anzusehen, klicken Sie auf diesen Link: https://mp.weixin.qq.com/s/cy7m7e97AVVo5VqUcnS0_w

#Willkommen beim offiziellen öffentlichen WeChat-Konto von iFaner: iFaner (WeChat-ID: ifanr), wo Ihnen so bald wie möglich weitere spannende Inhalte präsentiert werden.