Nach der Benennung durch OpenAI hat Zhipu gerade ein neues Open-Source-Modell veröffentlicht: die vielseitigste inländische Suchmaschine, die eine Suchmaschine in einem Satz erstellt

Die Open Source-Entwicklung inländischer Großmodellhersteller nimmt immer noch Fahrt auf.

Gerade hat Zhipu offiziell sein neuestes Flaggschiff-Modell GLM-4.5 vorgestellt. Laut der offiziellen Erklärung von Zhipu handelt es sich dabei um ein „Basismodell, das speziell für Agent-Anwendungen entwickelt wurde“.

Gemäß unseren konsequenten Open-Source-Prinzipien wurde dieses Modell nun gleichzeitig auf den Plattformen Hugging Face und ModelScope als Open Source veröffentlicht. Die Modellgewichte folgen der MIT-Lizenz und können kommerziell genutzt werden.

Durchflusssparende Version:

- GLM-4.5 hat hinsichtlich Argumentation, Code und umfassender Agentenfunktionen den neuesten Stand der Technik für Open-Source-Modelle erreicht.

- GLM-4.5 verwendet eine Mischung aus Expertenarchitektur (MoE), einschließlich GLM-4.5: Gesamtparameter sind 355 Milliarden, Aktivierungsparameter sind 32 Milliarden; GLM-4.5-Air: Gesamtparameter sind 106 Milliarden, Aktivierungsparameter sind 12 Milliarden;

- Beide Versionen sind vollständig Open Source und unterstützen die MIT-Lizenz.

- Sowohl GLM-4.5 als auch GLM-4.5-Air unterstützen einen hybriden Denkmodus und bieten zwei Modi: einen Denkmodus für komplexes Denken und die Verwendung von Werkzeugen und einen Nicht-Denkmodus für sofortige Reaktionen.

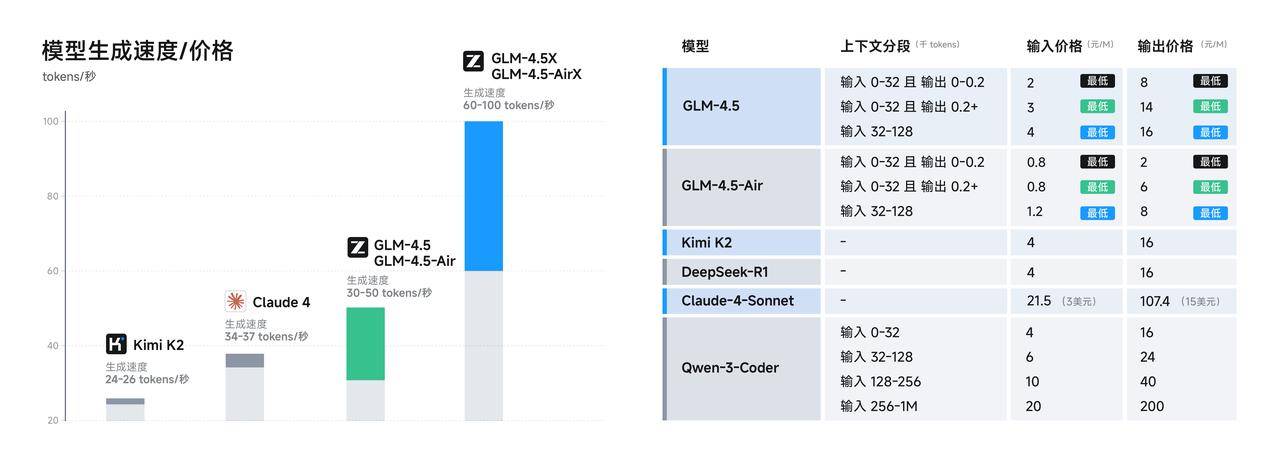

- Der API-Aufrufpreis beträgt nur 0,8 Yuan/Million Token für die Eingabe und 2 Yuan/Million Token für die Ausgabe; die Hochgeschwindigkeitsversion kann bis zu 100 Token/Sekunde erreichen.

Das wichtigste technische Verkaufsargument von GLM-4.5 ist die erstmalige native Integration von Argumentations-, Kodierungs- und Agentenfunktionen in einem einzigen Modell. Während andere Modelle entweder in Argumentations-, Kodierungs- oder Assistenzfunktionen brillieren, bietet GLM-4.5 alle Funktionen.

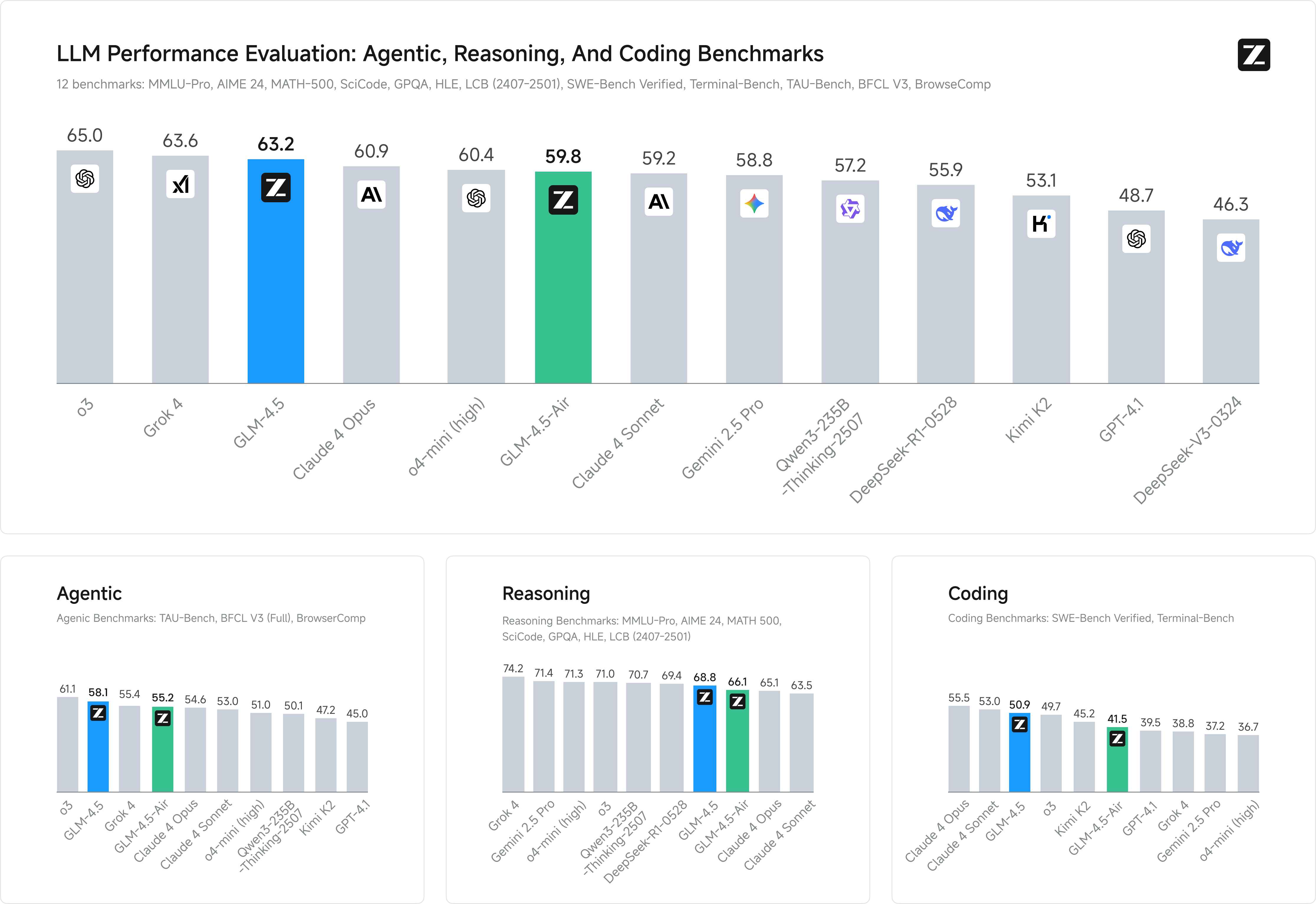

Werfen wir wie üblich zunächst einen Blick auf den Abschnitt „Laufende Punktzahl“ des neuen Modells.

Zhipu wählte 12 der repräsentativsten Benchmarks aus, um seine Leistung zu demonstrieren, darunter MMLU Pro, AIME 24, MATH 500, SciCode, GPQA und HLE – allesamt uns bekannte Benchmarks. Die Durchschnittspunktzahl zeigte, dass GLM-4.5 weltweit den zweiten Platz, unter den inländischen Modellen den ersten Platz und unter den Open-Source-Modellen den ersten Platz belegte.

Natürlich sind Laufergebnisse allein nutzlos und praktischere Tests sind überzeugender.

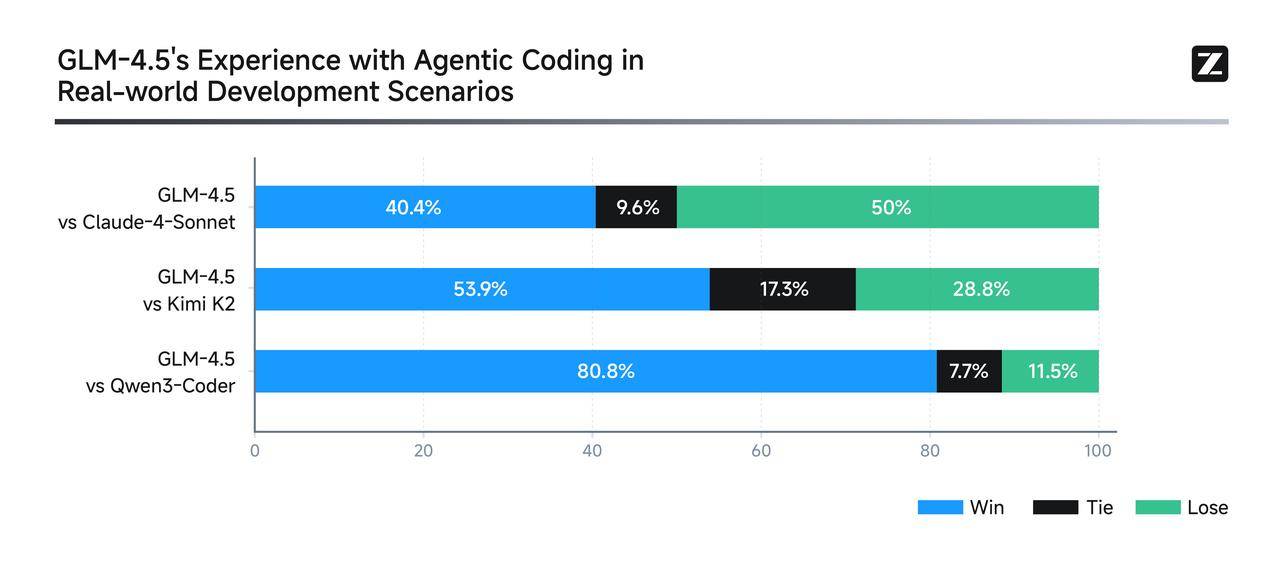

Um die Stärke von GLM-4.5 in realen Agent-Coding-Szenarien zu demonstrieren, hat Zhipu es direkt in Claude Code integriert, um mit Modellen wie Claude-4-Sonnet, Kimi-K2 und Qwen3-Coder zu konkurrieren.

Der Testplan war sehr anspruchsvoll: Insgesamt 52 Programmierentwicklungsaufgaben aus sechs wichtigen Entwicklungsbereichen wurden in mehreren interaktiven Testrunden in unabhängigen Containerumgebungen getestet, wobei der Schwerpunkt auf der praktischen Ausführung lag. Die Ergebnisse zeigten, dass GLM-4.5 zwar bei Claude-4-Sonnet noch deutliches Verbesserungspotenzial bietet, aber hinsichtlich der Zuverlässigkeit der Tool-Aufrufe und der Aufgabenerledigung immer noch recht gut abschnitt.

Zhipu hat sogar alle Testfragen und Agententrajektorien öffentlich gemacht (https://huggingface.co/datasets/zai-org/CC-Bench-trajectories), was mir das Gefühl gab, dass sie Kollegen willkommen heißen, um „Fälschungen zu bekämpfen“.

Schauen wir uns einige weitere überzeugende Demos an, die ebenfalls sehr wertvoll sind.

Geben Sie einfach die Eingabeaufforderung „Erstellen Sie eine Google-Suchwebsite“ auf der offiziellen Website von z.ai ein, und GLM-4.5 generiert in nur einem Satz tatsächlich eine echte, nutzbare Suchmaschine.

Die von GLM-4.5 erstellte Quantenfunktionsbox ist voll funktionsfähig und demonstriert die umfassenden Fähigkeiten des Modells.

Für eine komplexere Lösung können Sie auch eine zoombare 3D-Globusseite erstellen, auf der Benutzer auf einen Standort klicken können, um Details anzuzeigen, begleitet von einer sanften Zoomanimation.

▲Tipps: Erstellen Sie mit Three.js und JavaScript eine Webseite, die eine 3D-Welt mit den von mir besuchten Orten basierend auf einem Array erstellt. Durch Klicken auf Markierungen auf dem 3D-Globus wird ein Zoomeffekt animiert und detaillierte Reiseinformationen mit Fotos geöffnet.

Im Gegensatz zu herkömmlichen KI-PowerPoint-Tools, die auf Vorlagen zum Einfügen von Informationen angewiesen sind, sucht GLM-4.5 selbstständig nach Ressourcen und Bildern und erstellt dann Präsentationen direkt in HTML basierend auf dem tatsächlichen Material. Neben dem Standard-Seitenverhältnis von 16:9 unterstützt es auch flexibel Social-Media-Cover, lange Bilder, Xiaohongshu-Karten und sogar persönliche Lebensläufe.

Auch in Sachen Entwicklererfahrung zeigen chinesische Hersteller erste Verbesserungen. So ist GLM-4.5 beispielsweise mit gängigen Code-Intelligence-Systemen wie Claude Code, Cline und Roo Code kompatibel. Eine vollständige Bedienungsanleitung finden Sie hier:

- Inländische Benutzer: https://docs.bigmodel.cn/cn/guide/develop/claude

- Benutzer im Ausland: https://docs.z.ai/scenario-example/develop-tools/claude

Wenn das oben Genannte nur die „Oberfläche“ ist, dann ist der technische Kern das wahre „Innere“ von GLM-4.5.

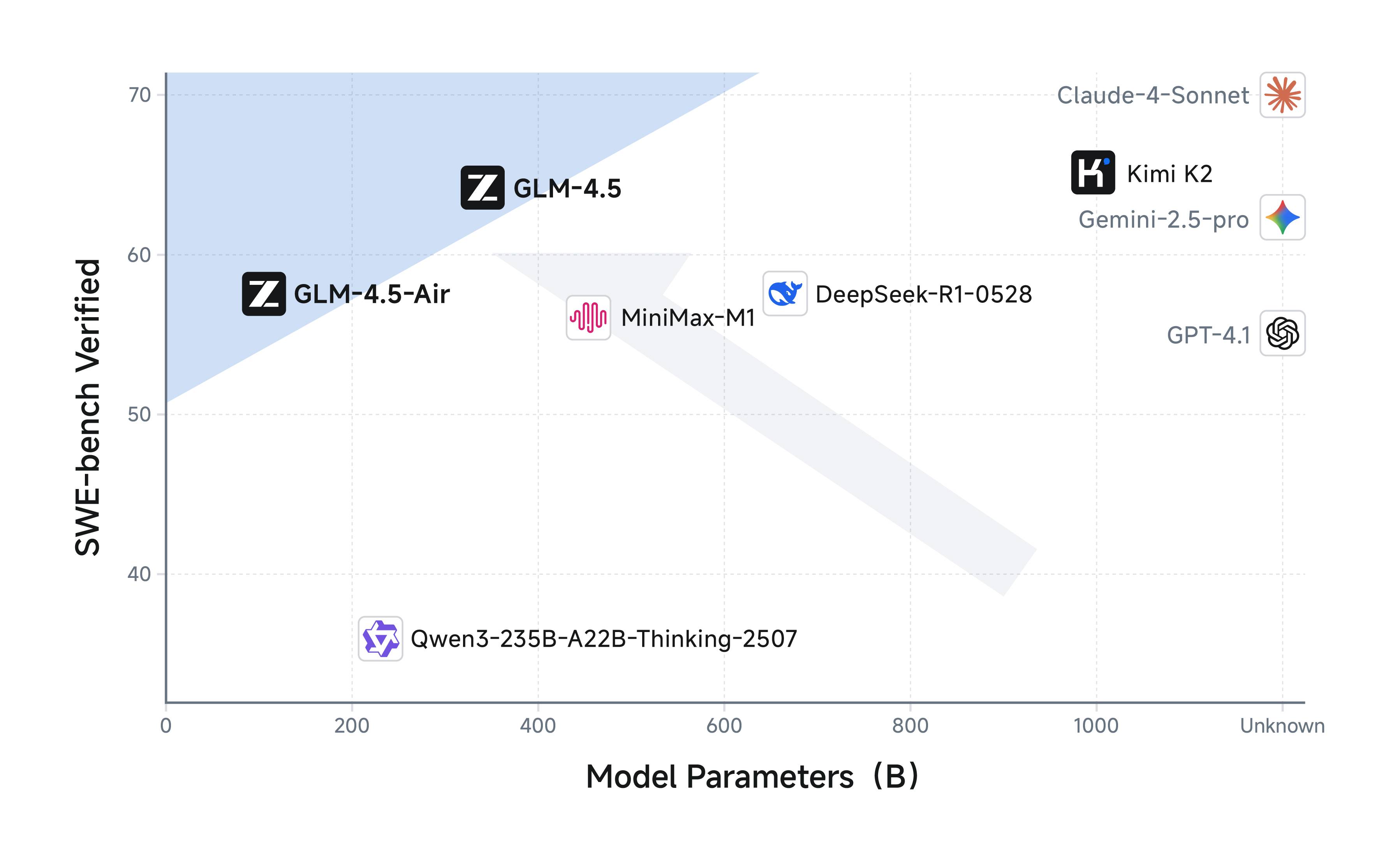

Wenig bekannt ist, dass die Anzahl der Parameter von GLM-4.5 nur halb so groß ist wie die von DeepSeek-R1 und nur ein Drittel von Kimi-K2. Die Leistung wird dadurch jedoch nicht beeinträchtigt. Dies liegt an der höheren Parametereffizienz des GLM-Modells.

Insbesondere der GLM-4.5-Air mit 106 Milliarden Gesamtparametern und 12 Milliarden Aktivierungsparametern hat in Inferenz-Benchmarks bereits die Leistung des Gemini 2.5 Flash und des Claude 4 Sonnet erreicht. Er liegt zudem auf der SWE-Bench-Verifizierungsliste an der Pareto-Grenze des Leistungs-Parameter-Verhältnisses – mit anderen Worten: Er bietet ein besseres Preis-Leistungs-Verhältnis bei geringerem Platzbedarf.

Die Leistungssteigerung ist untrennbar mit der „Wunderwirkung“ des Trainingsprozesses verbunden.

GLM-4.5 und GLM-4.5-Air verwenden einen ähnlichen Trainingsprozess: Zunächst trainieren sie mit 15 Billionen Token an allgemeinen Daten. Anschließend führen sie gezieltes Training mit 8 Billionen Token an Daten in Bereichen wie Code, Argumentation und Agenten durch. Abschließend wird Reinforcement Learning eingesetzt, um die Argumentations-, Code- und Agentenfähigkeiten des Modells weiter zu verbessern. Mit Geld und Ressourcen kann man wirklich alles machen, was man will.

Darüber hinaus könnten die bahnbrechenden Kosten- und Effizienzvorteile von GLM-4.5 noch bedeutender sein. Die API-Aufrufpreise liegen bei nur 0,8 Yuan pro Million Token für die Eingabe und 2 Yuan pro Million Token für die Ausgabe. Darüber hinaus kann die Hochgeschwindigkeitsversion Token mit einer gemessenen Geschwindigkeit von bis zu 100 Token pro Sekunde generieren und unterstützt so die Anforderungen realer Anwendungen an geringe Latenz und hohe Parallelität. Dies stellt eine deutliche Preissenkung dar.

Die API ist jetzt auf der offenen Plattform BigModel.cn verfügbar und per Mausklick mit dem Claude Code Framework kompatibel. Normale Benutzer können das voll funktionsfähige GLM-4.5 auch auf Zhipu Qingyan (chatglm.cn) und Z.ai nutzen.

Es ist erwähnenswert, dass OpenAI im letzten Monat in einem auf seinem Global Affairs-Konto veröffentlichten Bericht Zhipu direkt namentlich erwähnte und erklärte, das Unternehmen habe im globalen KI-Wettbewerb erhebliche Fortschritte erzielt. Der Tonfall war ungewöhnlich und direkt.

Rückblickend war Zhipu ein relativ stabiles Wachstumsunternehmen, das ein konstantes Tempo beibehielt, Modelle kontinuierlich iterierte, Open-Source-Initiativen liberalisierte und eine klare Ausrichtung behielt. Vor diesem Hintergrund ist es keine Überraschung, dass es als erstes der „Sechs kleinen Drachen“ der KI einen Börsengang durchführte.

#Willkommen beim offiziellen öffentlichen WeChat-Konto von iFaner: iFaner (WeChat-ID: ifanr), wo Ihnen so bald wie möglich weitere spannende Inhalte präsentiert werden.