Warum denkt irgendjemand, dass ich beim Fotografieren und Chatten ein Verbrechen begehe?

Film- und Fernseharbeiten wie "Minority Report" und "Suspect Tracking" dürfen erst in den letzten Jahren erscheinen. Wenn es sich um eine Film- und Fernseharbeit der letzten Jahre handelt, wird das Publikum sehr "aufgeregt".

Kriminalprävention, Vorhersagemodelle, spekulieren mit dem System darüber, was nicht passiert ist… Das bedeutet, dass viele Informationen gesammelt werden, und es bedeutet auch, dass Sie von einem unbekannten System beurteilt werden, ob eine Bedrohung vorliegt. Das Gefühl, dem Unbekannten das Schicksal anzuvertrauen, mögen wahrscheinlich nicht viele Menschen.

Aber es gibt keine Möglichkeit, es nicht zu mögen, denn bevor Sie es wissen, sammeln immer mehr Unternehmen Ihre öffentlichen Informationen, um die Möglichkeit Ihrer Straftat anhand des täglichen Inhalts Ihres sozialen Netzwerks zu beurteilen.

▲ Bild aus: "Minderheitenbericht"

Social Media hat sich zum größten Whistleblower entwickelt – ist das eine Selbstanzeige?

Voyager, Kaseware, Aura, PredPol, Palantir sind einige Unternehmen, die versuchen, potenzielle Bedrohungen über soziale Netzwerke zu erkennen, ein Großteil von ihnen kooperiert auch mit der örtlichen Polizei und steht an vorderster Front bei der Vorhersage von Kriminalität.

Die Beschaffung der erforderlichen Informationen aus den sozialen Medien aller stellt den Kern dieser Unternehmensform dar. Sie verwenden die von Nutzern in sozialen Netzwerken geposteten Inhalte, um abzuschätzen, ob der andere eine Straftat begehen wird. Die Algorithmen dieser Unternehmen sind nicht die gleichen, aber sie verwenden im Grunde künstliche Intelligenz, um die Leitung des Benutzers zu entschlüsseln, und beurteilen anhand der vom Benutzer geteilten Inhalte, ob die Person eine Straftat begangen hat, eine Straftat begehen könnte oder sich an eine bestimmte Gefahr hält Ideologie.

▲ Offizielle Website von Kaseware

Das ist eigentlich keine neue Entwicklung, schließlich machten einige Leute 2012 soziale Netzwerke zum "Puls der Stadt". Es ist schwer, einen Raum und ein Produkt vorzustellen, das so vielen Benutzern gleichzeitig Platz bietet und sie bereit macht, alles über sich selbst zu teilen.

Die Eigenschaften sozialer Netzwerke schaffen Voraussetzungen dafür, dass Menschen Ziele finden: Studenten suchen in sozialen Netzwerken nach Interviewpartnern, Statistikämter sagen in sozialen Netzwerken Wahlergebnisse voraus und KI-Detektive wollen Kriminelle in sozialen Netzwerken finden.

Da jeder soziale Netzwerke nutzt, können soziale Netzwerke oft die reale Situation einer Person widerspiegeln. Der Abgeordnete Tyrone Carter aus dem US-Bundesstaat Michigan ist der Ansicht, dass die Durchsuchung öffentlicher sozialer Netzwerke durch die Polizei weder gegen Gesetze verstoßen noch die Rechte der Nutzer verletzt hat, so dass diese Vorhersage möglich ist.

In dem Moment, in dem Sie auf der öffentlichen Seite auf Senden klicken, gehört der Beitrag nicht mehr Ihnen. Die Leute geraten durch das, was sie posten, in Schwierigkeiten, denn Social Media ist der größte "Selbstinformer", den ich je gesehen habe.

▲Bild von: Lifehacker

Aber das Geheimnis wird nur gelüftet, wenn es geführt wird. Voyager Labs, das mit der Polizei von Los Angeles zusammenarbeitete, spielte in diesem Prozess die führende Rolle. Nur die gemeinnützige Organisation Brennan Center entdeckte durch öffentliche Informationen der Polizei von Los Angeles, dass die Arbeit von Voyager auch der Rassendiskriminierung und Verletzung der Privatsphäre verdächtigt wurde.

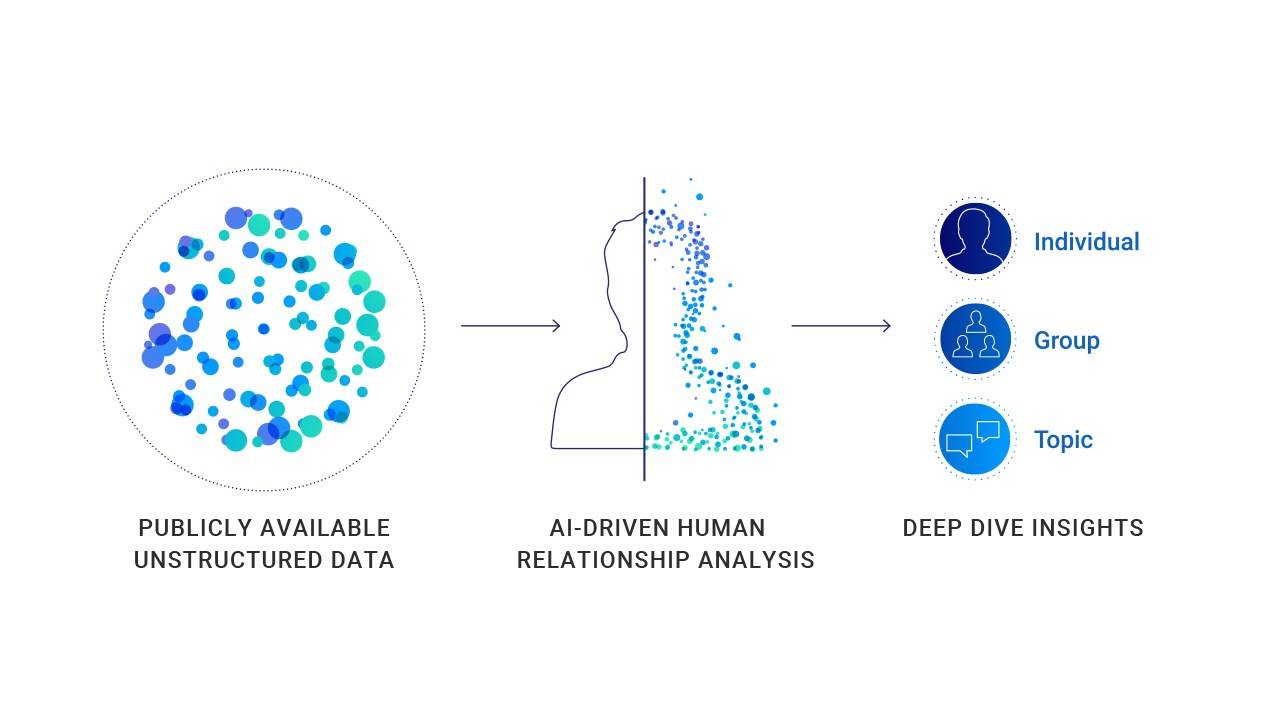

Die Arbeitsweise von Unternehmen wie Voyager ist nicht kompliziert. Es sammelt alle öffentlichen Informationen in den sozialen Medien einer Person, einschließlich Beiträgen, Kontakten und sogar häufig verwendeten Emojis. In einigen Sonderfällen werden die öffentlichen Informationen und nicht-öffentlichen Informationen verwendet, um Querverweise für die weitere Analyse und Indexierung zu erstellen.

▲ Voyager trifft Urteile auf der Grundlage persönlicher Themen zur Teilnahme an sozialen Medien

Durch den Dienst von Voyager kann die Polizei die sozialen Beziehungen einer Person klar erkennen. Wie sind ihre Verbindungen und wie sie auf sozialen Plattformen interagieren. Außerdem kann Voyager sogar erkennen, ob zwischen zwei Nutzern (beide haben mindestens vier identische Freunde) eine indirekte Verbindung besteht.

Es hört sich so an, als würde man sich nur ansehen, was Nutzer in sozialen Netzwerken tun, was als ergänzende Informationen für Umfragen verwendet wird. Tatsächlich sammelt und zeigt Voyager jedoch nicht nur Informationen an, sondern fällt auch Urteile.

▲ Voyager wird über die Beziehungskette des sozialen Netzwerks Urteile und Vorhersagen treffen

Voyager erwähnte in einem Whitepaper, das der Polizei von Los Angeles vorgelegt wurde, einen Angriffsfall. Der Fall demonstrierte speziell den Ansatz der Plattform – KI überprüft automatisch den Inhalt von Beiträgen von Personen in sozialen Netzwerken ohne menschliches Eingreifen. Und Klassifizierung (jeweils den Benutzer in drei markieren) Farben Blau, Orange und Rot).

In einem konkreten Fall wurde Adam Alsahli, der Verdächtige der Schießerei, vom System aufgrund seiner auf Facebook und Instagram geposteten Fotos mit islamischen Themen als „starkes Gefühl des Stolzes und der Identifikation mit arabischen Traditionen“ beurteilt. Daher wurde Adam Alsahli von Voyagers KI-Tool orange markiert, bevor er einen bestimmten Angriff startete.

Dies kann ein Fall der erfolgreichen Vorhersage potenzieller Täter sein, aber auch ein Fall voller "Vorurteile".

▲ Die Social-Media-Informationen von Adam Alsahli, dem Tatverdächtigen, waren orange markiert, bevor er das Verbrechen beging

Daten sagen Kriminalität voraus? Aber den Daten kann man nicht ganz glauben

Sind diese Schlussfolgerungen wirklich glaubwürdig? Auf welcher Grundlage urteilen sie? Wie kann jeder unter Big Data seine Unschuld beweisen?

Es gibt in der Tat viele Daten, die die Korrelation zwischen der inhaltlichen Verzerrung sozialer Netzwerke und den Verbrechensfakten bestätigen, aber dies sind keine 100%-Korrelationsdaten.

Die Tandon School of Engineering der New York University und die School of Global Health and Public Health veröffentlichten Forschungsergebnisse, die zeigen, dass Städte mit mehr rassistischen Hassreden auf Twitter höhere Kriminalitätsraten aufweisen pro 1 °C Temperaturerhöhung steigt die kriminelle Aktivität um 1,7 % an; amerikanische Studien haben gezeigt, dass die Diebstahlrate von Fahrzeugen in Wochenendnächten stark ansteigt; und es wurde bewiesen, dass es bei einem versehentlichen Verlust der örtlichen Fußballmannschaft zu Fällen häuslicher Gewalt kommt um 10 % erhöhen.

▲ KI kann keine Entscheidung mit 100%iger Genauigkeit treffen

Diese können aber nichts beweisen, denn Wahrscheinlichkeit und Tatsache sind verschieden.

Selbst mit der Bestätigung relevanter Daten kann es nicht beweisen, dass in Städten mit den rassistischsten Hassreden an Sommerwochenenden Fahrzeuge gestohlen werden müssen.Bei heißem Wetter, wenn das lokale Heimteam 100% verliert, werden mehr Fälle von häuslicher Gewalt auftreten.

Ähnliche Kriminalitätsvorhersagesysteme werden basierend auf bestehenden Kriminalitätsfakten und Forschungsergebnissen umgekehrt, ein weiteres Problem, das dadurch entsteht, ist, dass es voller "Stereotypen" ist.

Der Gewinner des Turing-Preises, Yang Likun, sagte einmal, dass maschinelle Lernsysteme verzerrt werden, wenn Daten verzerrt sind. In einem einzigen Fall, wenn die durch maschinelles Lernen erhaltenen Informationen lauten, dass schwarze männliche Benutzer im Gefängnis einen großen Anteil ausmachen, kann ein solches System zu dem Schluss kommen, dass schwarze Männer eher Straftaten begehen.

▲ Yang Likun sagte, dass die Voreingenommenheit von maschinellen Lernsystemen von den Menschen kommt

Für maschinelles Lernen mag „schwarze Männer eher Verbrechen begehen“ eine Tatsache der Datenanalyse sein, aber in Wirklichkeit werden es rassistische Vorurteile und unterschiedliche Behandlung sein.

Die heimliche Bewertung von Benutzern, die Aufteilung der Bedrohungen und die genauere Verfolgung und Verhinderung von Bedrohungen sind die Betriebslogik des gesamten Systems.

Ähnliche Start-ups werden Algorithmen und künstliche Intelligenz verwenden, um den Prozess zu erklären, den sie verarbeiten, und Informationen zu analysieren, um Entscheidungen zu treffen. Obwohl es derzeit keine Beweise für die Wirksamkeit dieser Vorhersage gibt und es viele Zweifel in der Öffentlichkeit gibt, will die Polizei dennoch mit ähnlichen Plattformen kooperieren.

▲Für die Polizei ist der Vorhersagedienst der Plattform sehr wertvoll

Für die Polizei ist ein solches Tool sehr attraktiv: Das Auffinden von Plattformen wie Voyager in sozialen Netzwerken kann bei der Erstellung von Nutzerprofilen effektiv helfen, ohne die subtilen Online-Hinweise zu übersehen. Wenn es sich nur um eine Hilfsuntersuchung handelt, ist dies ein sehr wirksames Instrument. Wenn sich das Instrument jedoch zu einem späteren Zeitpunkt entwickelt und eine Rolle bei der Vorhersage von Kriminalität spielt, wird es auch zu einer Waffe für Verwundungen.

Nach der Begeisterung der vergangenen Finanzierungsjahre sind viele KI-Produkte in die Bewerbungsphase eingetreten. Aber in einigen Bereichen spielen sie immer noch die Rolle der Hilfskräfte.

Die medizinische Versorgung ist ein Bereich, der bei KI-Interventionen vorsichtig ist.Selbst im am schnellsten fortgeschrittenen KI-Bereich der medizinischen Bildgebung kann die heutige KI-Technologie immer noch keine 100%ige Genauigkeit garantieren und erfordert das Eingreifen menschlicher Ärzte. Denn jeder weiß, dass die medizinische Versorgung eine Branche ist, die eine nahezu 100-prozentige Genauigkeit erfordert.Jede Abweichung oder jeder Fehler kann schwerwiegende Folgen haben.

▲ In diesem Stadium brauchen wir möglicherweise mehr menschliche Polizei

Der Polizeibereich ist auch ein Bereich, der zu 100 % korrekt ist, und jede Vermutung und Schlussfolgerung kann auch ohne Beweise schwerwiegende Folgen haben. Eine Person, die verschiedene diskriminierende und gewalttätige Äußerungen in sozialen Medien veröffentlicht, kann als potenzieller Täter markiert werden.Die Wahrscheinlichkeit, ein Gewaltverbrechen zu begehen, besteht zu 90%, aber bevor sie tatsächlich eine Straftat begeht, ist sie ein gewöhnlicher Mensch.

Im Gesamtdatensatz können wir nie ignorieren, dass jeder ein unabhängiges Individuum ist.

#Willkommen, um dem offiziellen WeChat-Account von Aifaner zu folgen: Aifaner (WeChat-ID: ifanr), weitere spannende Inhalte werden Ihnen so schnell wie möglich zur Verfügung gestellt.

Ai Faner | Ursprünglicher Link · Kommentare anzeigen · Sina Weibo