Warum hat Apple seine Foto-Scan-Funktion zurückgenommen?

Im August 2021 gab Apple seine Pläne bekannt, iPhones nach Bildern von sexuellem Missbrauch von Kindern zu scannen. Der Schritt erhielt Applaus von Kinderschutzgruppen, ließ jedoch bei Datenschutz- und Sicherheitsexperten Bedenken aufkommen, dass die Funktion missbraucht werden könnte.

Apple plante ursprünglich, die Scantechnologie für Kinder-Sexual-Abuse-Material (CSAM) in iOS 15 zu integrieren; Stattdessen hat es die Einführung des Features auf unbestimmte Zeit verschoben, um Feedback vor seiner vollständigen Veröffentlichung einzuholen.

Warum wurde die CSAM-Erkennungsfunktion heiß diskutiert und warum hat Apple die Einführung verschoben?

Was macht Apples Foto-Scan-Funktion?

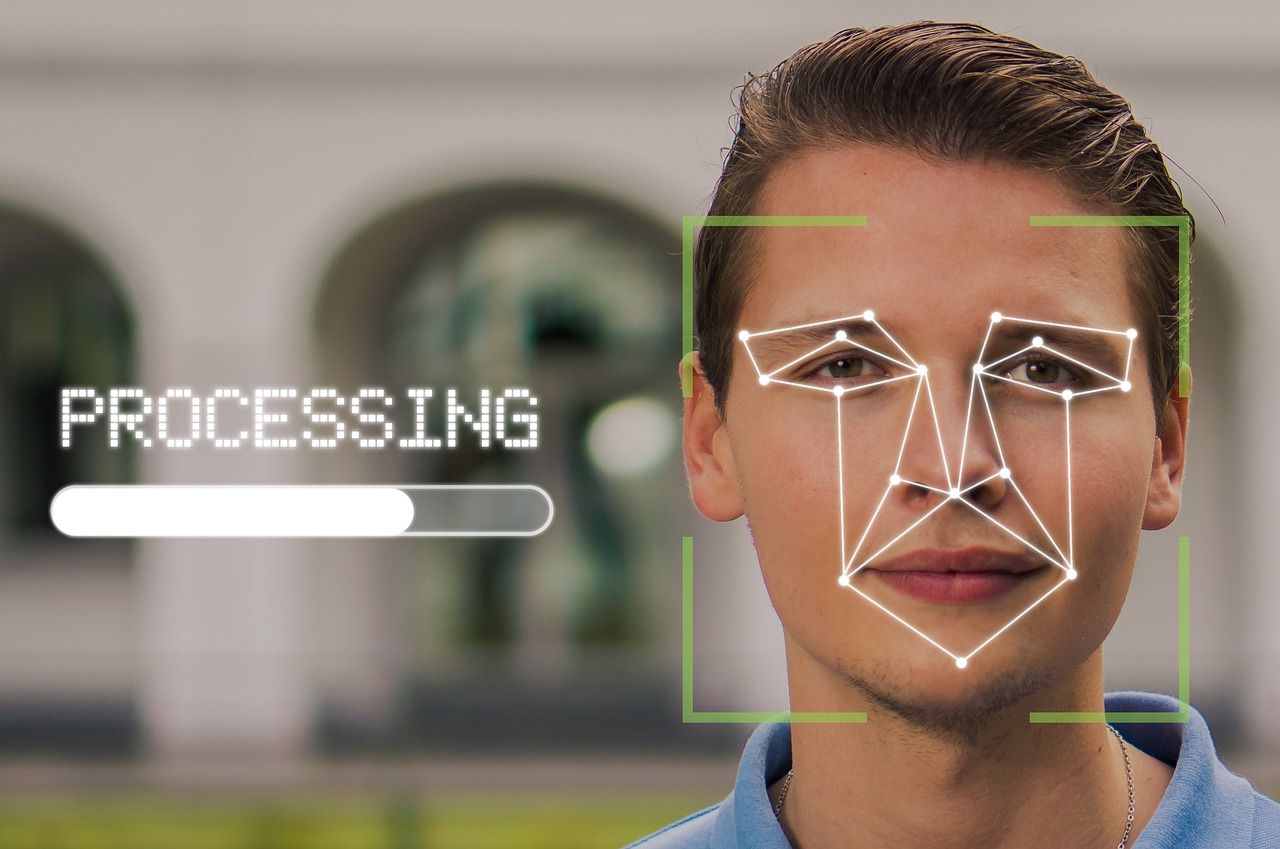

Apple kündigte an, die Funktion zum Scannen von Fotos zu implementieren, um den sexuellen Missbrauch von Kindern zu bekämpfen. Alle Fotos auf den Geräten von Apple-Benutzern werden mit dem von Apple entwickelten "NueralHash"-Algorithmus auf pädophile Inhalte gescannt.

Darüber hinaus verfügen alle von Kindern verwendeten Apple-Geräte über eine Sicherheitsfunktion, die Bilder für Erwachsene automatisch verwischt, wenn sie von einem Kind empfangen werden, und der Benutzer würde zweimal gewarnt, wenn er versucht, sie zu öffnen.

Abgesehen von der Minimierung der Exposition gegenüber Inhalten für Erwachsene würden Eltern, wenn sie die Geräte ihrer Kinder registrieren, um zusätzliche Sicherheit zu gewährleisten, benachrichtigt, falls das Kind explizite Inhalte von jemandem online erhält.

Was Erwachsene betrifft, die Siri verwenden, um nach allem zu suchen, was Kinder sexualisiert, wird Siri diese Suche nicht durchführen und stattdessen andere Alternativen vorschlagen.

Daten von jedem Gerät, das 10 oder mehr Fotos enthält, die von den Algorithmen als verdächtig eingestuft werden, werden entschlüsselt und einer menschlichen Überprüfung unterzogen.

Wenn sich herausstellt, dass diese oder andere Fotos auf dem Gerät mit der Datenbank des Nationalen Zentrums für vermisste und ausgebeutete Kinder übereinstimmen, wird dies den Behörden gemeldet und das Konto des Benutzers wird gesperrt.

Hauptanliegen bezüglich der Foto-Scanfunktion

Die CSAM-Erkennungsfunktion wäre mit der Einführung von iOS 15 im September 2021 live gegangen, aber angesichts des weit verbreiteten Aufschreis beschloss Apple, sich mehr Zeit zu nehmen, um Feedback zu sammeln und diese Funktion zu verbessern. Hier ist Apples vollständige Erklärung zur Verzögerung:

"Letzten Monat haben wir Pläne für Funktionen angekündigt, die dazu beitragen sollen, Kinder vor Raubtieren zu schützen, die Kommunikationsmittel verwenden, um sie zu rekrutieren und auszubeuten, und die Verbreitung von Material über sexuellen Missbrauch von Kindern zu begrenzen.

Basierend auf dem Feedback von Kunden, Interessengruppen, Forschern und anderen haben wir beschlossen, uns in den kommenden Monaten zusätzliche Zeit zu nehmen, um Input zu sammeln und Verbesserungen vorzunehmen, bevor wir diese kritisch wichtigen Funktionen zur Kindersicherheit veröffentlichen."

Fast die Hälfte der Bedenken im Zusammenhang mit der Foto-Scan-Funktion von Apple dreht sich um den Datenschutz; die restlichen Argumente umfassen die wahrscheinliche Ungenauigkeit von Algorithmen und den möglichen Missbrauch des Systems oder seiner Lücken.

Teilen wir es in vier Teile auf.

Potenzieller Missbrauch

Zu wissen, dass jedes Material, das mit Kinderpornografie oder bekannten Bildern von sexuellem Missbrauch von Kindern übereinstimmt, ein Gerät in die Liste der "verdächtigen" bringt, kann Cyberkriminelle in Bewegung setzen.

Sie können eine Person absichtlich mit unangemessenen Inhalten über iMessage, WhatsApp oder andere Mittel bombardieren und das Konto dieser Person sperren lassen.

Apple hat zugesichert, dass Benutzer Einspruch einlegen können, falls ihre Konten aufgrund eines Missverständnisses gesperrt wurden.

Insider-Missbrauch

Obwohl diese Funktion für einen wohlwollenden Zweck entwickelt wurde, kann diese Funktion für bestimmte Personen zu einer totalen Katastrophe werden, wenn ihre Geräte mit oder ohne ihr Wissen von Angehörigen, die ihre Kommunikation überwachen möchten, im System registriert werden.

Selbst wenn das nicht passiert, hat Apple eine Hintertür geschaffen, um die Daten der Benutzer am Ende des Tages zugänglich zu machen. Jetzt ist es eine Frage der Motivation und Entschlossenheit, auf die persönlichen Daten anderer zuzugreifen.

Es erleichtert nicht nur eine schwerwiegende Verletzung der Privatsphäre, sondern ebnet auch den Weg für missbräuchliche, giftige oder kontrollierende Verwandte, Vormunde, Freunde, Geliebte, Betreuer und Ex-Partner, um weiter in den persönlichen Raum einer Person einzudringen oder ihre Freiheit einzuschränken.

Einerseits soll damit sexueller Missbrauch von Kindern bekämpft werden; auf der anderen Seite kann es verwendet werden, um andere Arten von Missbrauch weiter zu verewigen.

Staatliche Überwachung

Apple hat sich immer als eine datenschutzbewusstere Marke als seine Konkurrenten gepriesen. Aber jetzt könnte es ins Rutschen geraten, die nie endenden Forderungen der Regierungen nach Transparenz der Benutzerdaten erfüllen zu müssen .

Das von ihm entwickelte System zur Erkennung von pädophilen Inhalten kann verwendet werden, um jede Art von Inhalten auf Telefonen zu erkennen. Das bedeutet, dass Regierungen mit einer Sektenmentalität die Benutzer auf einer persönlicheren Ebene überwachen können, wenn sie es in die Hände bekommen.

Ob unterdrückend oder nicht, die Einmischung der Regierung in Ihr tägliches und persönliches Leben kann beunruhigend sein und eine Verletzung Ihrer Privatsphäre darstellen. Die Vorstellung, dass Sie sich nur dann über solche Invasionen Sorgen machen müssen, wenn Sie etwas falsch gemacht haben, ist ein Denkfehler und sieht die oben erwähnte Rutschbahn nicht.

Falscher Alarm

Eines der größten Bedenken bei der Verwendung von Algorithmen zum Abgleich von Bildern mit der Datenbank sind Fehlalarme. Hashing-Algorithmen können fälschlicherweise zwei Fotos als Übereinstimmungen identifizieren, selbst wenn sie nicht identisch sind. Diese Fehler, die als "Kollisionen" bezeichnet werden, sind im Zusammenhang mit Inhalten über sexuellen Missbrauch von Kindern besonders alarmierend.

Forscher fanden mehrere Kollisionen in "NeuralHash", nachdem Apple angekündigt hatte, den Algorithmus zum Scannen von Bildern zu verwenden. Apple beantwortete Fragen zu Fehlalarmen mit dem Hinweis, dass das Ergebnis am Ende von einem Menschen überprüft wird, sodass sich die Leute keine Sorgen machen müssen.

Ist die CSAM-Pause von Apple dauerhaft?

Es gibt viele Vor- und Nachteile der von Apple vorgeschlagenen Funktion. Jeder von ihnen ist echt und hält Gewicht. Es ist noch unklar, welche spezifischen Änderungen Apple an der CSAM-Scan-Funktion vornehmen könnte, um seine Kritiker zufriedenzustellen.

Es könnte das Scannen auf freigegebene iCloud-Alben beschränken, anstatt die Geräte der Benutzer einzubeziehen. Es ist sehr unwahrscheinlich, dass Apple diese Pläne ganz fallen lässt, da das Unternehmen normalerweise nicht geneigt ist, seinen Plänen nachzugeben.

Aus der weit verbreiteten Gegenreaktion und dem Zurückhalten von Apple mit seinen Plänen wird jedoch klar, dass Unternehmen die Forschungsgemeinschaft von Anfang an einbeziehen sollten, insbesondere für eine ungetestete Technologie.