Wie hat Google den Porträtlichteffekt auf Pixel 5 erzielt?

In den letzten zwei Jahren haben wir den Begriff Computerfotografie zu oft gehört.

Wenn es um Computerfotografie geht, denken die Leute natürlich an die Pxiel-Serie von Google für Mobiltelefone. Diese Serie schafft einen Präzedenzfall für Computerfotografie. Sie zeigt die Kraft und den Charme der Computerfotografie.

Gerade weil die Leistungsfähigkeit der Computerfotografie so erstaunlich ist, haben sich die Handyhersteller, die sich in den letzten zwei Jahren allmählich daran erinnert haben, endlich darauf eingelassen. Zu diesem Zeitpunkt spielt Google bereits mehr Blumen.

"Portrait Light Effect" wurde ursprünglich mit Googles Veröffentlichung von Pixel 4a & Pixel 5 im Oktober dieses Jahres gestartet, was das exklusive Merkmal dieser Pixelgeneration ist. Vor einigen Tagen hat Google jedoch ein Update für die Kamera- und Fotoalbumanwendungen vorgenommen und diese Funktion nach Pixel 2 an Benutzer delegiert.

Inspiriert von den von Porträtfotografen verwendeten Fotolichtern kann "Portrait Light Effect" die Lichtquelle neu positionieren und modellieren und dann die neue Lichtquelle zur Fotoszene hinzufügen. Es kann auch die Richtung und Intensität der anfänglichen Beleuchtung identifizieren und dann die Beleuchtungssituation automatisch ergänzen.

Eine solch leistungsstarke Computerfotografiefunktion ist natürlich untrennbar mit den maschinellen Lernfähigkeiten neuronaler Netze verbunden. Nachdem die im Porträtlichteffektmodus des Mobiltelefons aufgenommenen Fotos als Datenbank für das Training verwendet wurden, ermöglichen die späteren Funktionen des "Porträtlichteffekts" zwei neue Algorithmen:

- Synthetische Lichtquelle automatisch hinzufügen: Für ein bestimmtes Porträtfoto synthetisiert und fügt der Algorithmus die externe Lichtquelle hinzu, und die Beleuchtung und Beleuchtung des Fotografen ist in der Realität konsistent.

- Nach der Komposition neu beleuchten: Fügen Sie für eine bestimmte Beleuchtungsrichtung und ein bestimmtes Porträtfoto auf natürlichste Weise zusammengesetztes Licht hinzu.

Lassen Sie mich zuerst über das erste Problem sprechen, nämlich die Position der Lichtquelle zu bestimmen und sie hinzuzufügen. In der Realität gehen Fotografen normalerweise empirisch und wahrnehmungsbezogen vor, indem sie die Intensität und Position des Lichts beobachten, das auf das Gesicht des Motivs fällt, und dann bestimmen, wie es beleuchtet werden soll. Für AI ist es jedoch nicht einfach, die Richtung und Position der vorhandenen Lichtquelle zu bestimmen.

Zu diesem Zweck hat Google ein neues Modell für omnidirektionale Beleuchtungskonturen für das Maschinentraining eingeführt. Dieses neue Beleuchtungsberechnungsmodell kann das menschliche Gesicht als Lichtdetektor verwenden, um die Richtung, relative Intensität und Farbe der Lichtquelle aus der gesamten Beleuchtung abzuleiten, und es kann auch die Kopfhaltung auf dem Foto durch einen anderen Gesichtsalgorithmus schätzen.

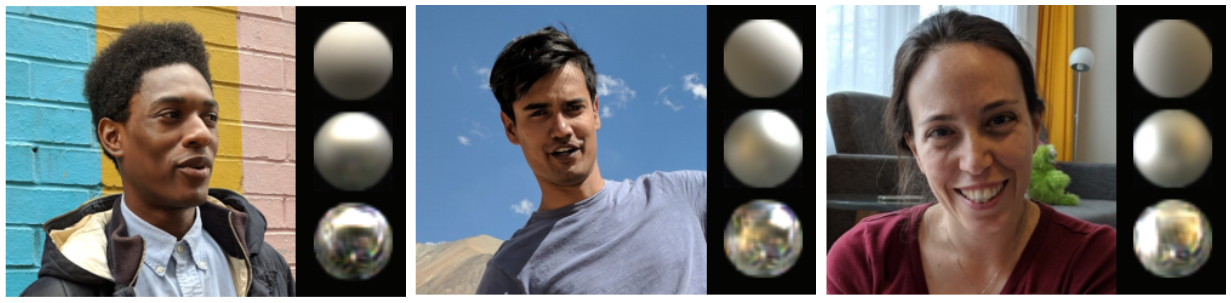

Obwohl es sehr groß klingt, ist der Rendering-Effekt des eigentlichen Trainingsmodells sehr schön. Er behandelt den menschlichen Kopf als drei runde silberne kugelförmige Objekte, und die "Textur" des oberen Balls ist die raueste, die zur Simulation verwendet wird Diffuse Lichtreflexion. Der Ball in der Mitte ist ebenfalls matt, wodurch eine konzentriertere Lichtquelle simuliert wird. Die untere Kugel ist das "Spiegelmaterial", mit dem eine glattere Spiegelreflexion simuliert wird.

Darüber hinaus kann jede Kugel die Farbe, Intensität und Ausrichtung der Umgebungsbeleuchtung gemäß ihren eigenen Eigenschaften widerspiegeln.

Auf diese Weise kann Google die Richtung der Post-Composite-Lichtquelle ermitteln. Beispielsweise befindet sich die klassische Porträtlichtquelle 30 ° über der Sichtlinie und zwischen 30 ° und 60 ° mit der Kameraachse. Google folgt ebenfalls dieser klassischen Regel.

Nachdem Sie die Richtung des Hinzufügens einer Lichtquelle zu einem Porträt gelernt haben, müssen Sie als Nächstes die hinzugefügte Lichtquelle natürlicher gestalten.

Die vorherige Frage ist ein bisschen wie die "Dugu Nine Swords". Nachdem ich sie gelernt habe, werde ich einige feste Fragen stellen. Um das letztere Problem zu lösen, ist es notwendig, "Dugu Nine Swords" so viel tatsächlichen Kampf wie möglich zu machen, verschiedene tatsächliche Situationen zu integrieren und dann zu lernen, die Kampfkünste der Welt zu knacken.

Um dieses Problem zu lösen, hat Google ein weiteres neues Trainingsmodell entwickelt, um die selbstgerichtete Lichtquelle zu bestimmen, die dem Originalfoto hinzugefügt werden soll. Unter normalen Umständen ist es unmöglich, dieses Modell mit den vorhandenen Daten zu trainieren, da es der nahezu unendlichen Belichtung nicht standhalten kann und perfekt zum menschlichen Gesicht passen muss.

Aus diesem Grund hat Google ein ganz besonderes Gerät zum Trainieren von maschinellem Lernen entwickelt – einen kugelförmigen "Käfig". In diesem Gerät befinden sich 64 Kameras mit unterschiedlichen Betrachtungswinkeln und 331 individuell programmierbare LED-Lichtquellen.

Wenn Sie schon einmal im Dolby Cinema waren, gibt es in der Vorab-Show des Dolby Cinema einen Link, über den sich der Ton in einer halbkugelförmigen Kuppel bewegt, um die nahezu unendliche Richtung in der Realität zu simulieren. Das Google-Gerät hat tatsächlich ein ähnliches Prinzip.

Durch ständiges Ändern der Richtung und Intensität der Beleuchtung und Simulieren komplexer Lichtquellen können Sie die Daten des reflektierten Lichts von menschlichem Haar, Haut und Kleidung abrufen, um zu ermitteln, wie die Beleuchtung unter komplexen Lichtquellen aussehen sollte.

Google hat 70 verschiedene Personen eingeladen, dieses Modell mit verschiedenen Gesichtsformen, Frisuren, Hautfarben, Kleidung, Accessoires und anderen Merkmalen zu trainieren. Dies stellt sicher, dass die synthetisierte Lichtquelle der Realität maximal entspricht.

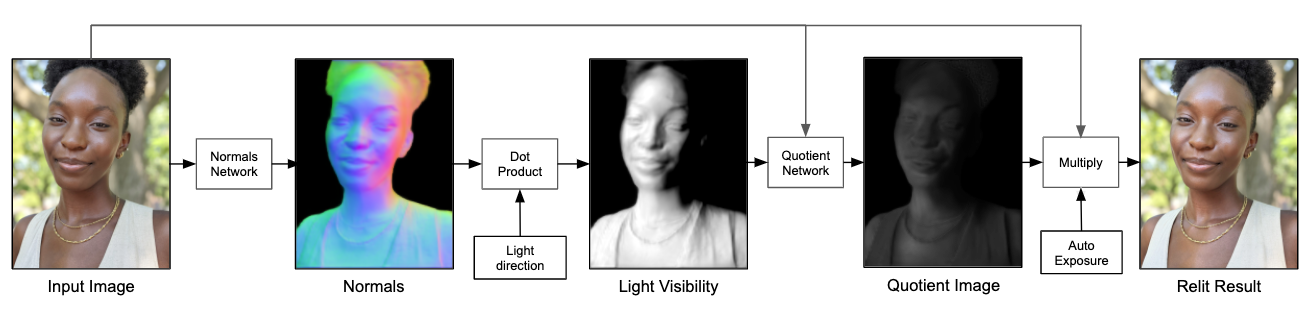

Darüber hinaus gibt Google das endgültige Bild nicht direkt über das neuronale Netzwerkmodell aus, sondern ermöglicht es dem neuronalen Netzwerkmodell, ein Quotientenbild mit niedrigerer Auflösung auszugeben.

Hier ist eine Erklärung, was ein Quotientenbild ist. Ein Bild kann in zwei Ebenen unterteilt werden: die untere Ebene und die Detailebene. Die untere Schicht enthält die Niederfrequenzinformationen des Bildes, die die Intensitätsänderungen des Bildes in großem Maßstab widerspiegeln, die Detailebene enthält die Hochfrequenzinformationen des Bildes, die die Details des Bildes in kleinem Maßstab widerspiegeln. Die unterste Ebene multipliziert mit der Detailebene ist das Quellbild, und die Detailebene kann auch als Quotientenbild bezeichnet werden.

Durch die untere Ebene des Originalbilds können Sie ein zusätzliches Ausgabebild erhalten, indem Sie den Daten des Eingangsquotientenbildes während der Abtastung zusätzliche Lichtquellen hinzufügen.

Der letzte Vorgang ist wie folgt: Zuerst ein Bild gegeben, dann die Oberflächennormale des Zeichens im Bild berechnet, dann die sichtbare Lichtquelle im Bild berechnet und das neuronale Netzwerkmodell verwendet, um die zusätzliche Lichtquelle zu simulieren, um ein Quotientenbild mit niedrigerer Auflösung auszugeben, und es dann als zu verwenden Die Detailebene wird mit der unteren Ebene des Originalfotos multipliziert, und schließlich wird ein Porträtfoto mit zusätzlichen Lichtquellen erhalten.

Google hat auch viele Optimierungen an der Pipeline vorgenommen, damit die simulierten Lichteffekte in Echtzeit auf dem Mobiltelefon interagiert werden können, während die Größe des gesamten Modells nur etwa 10 MB beträgt.

Der Porträtbeleuchtungseffekt von Pixel 5 kann als typischer Fall in der Computerfotografie von Google bezeichnet werden. Durch kontinuierliches Training neuronaler Netzwerkmodelle kann das Mobiltelefon die Beleuchtung realer Porträts simulieren. Fertigstellung eines neuen Anwendungsszenarios für Computerfotografie.

Einige Leute sagen, dass Fotografie eine Kunst ist und Computerfotografie im Grunde eine Beleidigung für die Fotografie ist. Aber seit der Franzose Daguerre 1839 die erste praktische Kamera herstellte, ist die Kamera seit mehr als 100 Jahren im Einsatz. Von der Nische über die Massen bis zur Geburt der Handykamera hat jeder die gleiche Chance, Bilder zu machen. Und der innere Ausdruck der Menschen hat auch die Kunst der Fotografie allmählich bereichert.

Das ist richtig, Computerfotografie ist gleichzeitig mit "Fotografie" und auch "Schatten berechnen", aber Algorithmen sind seit langem ein untrennbarer Bestandteil der mobilen Fotografie. Das Streben ist immer noch der Effekt, der in der simulierten Realität erzielt werden kann. Schließlich wird es niemand tun "Magic Change" heißt Computerfotografie.

Als Apple und Google in der Computerfotografie immer weiter gingen, stellten wir fest, dass Algorithmen tatsächlich eine stärkere Barriere darstellen als Hardware.

#Willkommen Sie, wenn Sie Aifaners offiziellem WeChat-Konto folgen: Aifaner (WeChat ID: ifanr). Weitere aufregende Inhalte werden Ihnen so schnell wie möglich zur Verfügung gestellt.