Ein Foto, das einen Vater fast zerstört hätte

Während eines Gesprächs auf der Arbeit wurde Mark plötzlich von der Polizei angesprochen.

Mark wurde verdächtigt, ein Sexualstraftäter zu sein, der auf Kinder abzielt, weil auf seinem Telefon ein Foto der Geschlechtsorgane eines Kindes gefunden wurde. Und die Polizei stellte fest, dass dieses Foto tatsächlich von Marks Sohn stammte…

Wahrscheinlich beginnt sich in Ihrem Kopf ein perverses Bild eines Pädophilen aufzubauen.

Beeilen Sie sich nicht, wütend zu werden, die Dinge drehten sich schnell um. Es stellte sich heraus, dass dieses Foto aufgenommen wurde, nachdem Marks Sohn krank geworden war, um den Arzt über den Zustand zu informieren, und Mark hat dieses Foto nie öffentlich veröffentlicht.

Woher also wusste die Polizei, dass es das KI-System von Google war, das die Fotos auf Marks Android-Handy entdeckte, ihn als kriminellen Tatverdächtigen identifizierte, es der Polizei meldete und sein Google-Konto deaktivierte.

In den Vereinigten Staaten entspricht die Popularität von Googles Familien-Bucket in etwa der von WeChat, was bedeutet, dass die Operation von Google Mark direkt von online nach offline tötet.

Noch erschreckender ist, dass es wie Mark weit mehr als eine Person gibt, die von der Plattform als Anomalie erkannt und nebenbei gemeldet wurde.

Fotos von der Online-Konsultation des Kindes führen dazu, dass es als Krimineller identifiziert wird

Marks Kind bekam beim Laufenlernen eine Leistenentzündung. Aufgrund der schweren Epidemie waren die meisten Menschen zu dieser Zeit in häuslicher Quarantäne. Mark konnte nur die Online-Beratung wählen und Bilder der Leiste des Kindes zur Verfügung stellen, um dem Arzt zu helfen, eine bessere Diagnose zu stellen. Der Arzt verschrieb auch die Krankheit auf der Grundlage der Beschreibung zustand und die fotos gezeigt rezept.

Bei diesen Fotos gibt es jedoch ein Problem: Die Fotos im Android-Telefon werden automatisch mit der Cloud synchronisiert, und das Google-System erkennt diese Fotos als CSAM (Child Sexual Abuse Material).

Nachdem er identifiziert wurde, wurde Marks Internetnutzung halbiert, weil er blockiert wurde. Gmail, das Postfach des Kontos, das Benutzer verwenden, um sich bei anderen Plattformen anzumelden; Google Fi, der mobile virtuelle Betreiber des Benutzers, der zum Telefonieren und Surfen im Internet verwendet werden kann; Google Fotos, auf das nicht mehr zugegriffen werden kann, enthält Fotos von Ihnen Familienmitglieder … Versiegelt. Weil Google glaubt, dass Sie der Sexualverbrechen von Kindern verdächtigt werden, hat es Ihr Konto gesperrt und die Polizei "für Sie" gerufen – nachdem die Plattform gesperrt wurde, wurde eine Anzeige beim National Center for Missing and Exploited Children (NCMEC) eingereicht, was die Polizei aktivierte Ermittlung.

Zehn Monate später wurde der Vater von der San Francisco Police Department benachrichtigt, die auf der Grundlage eines von Google bereitgestellten Fotoberichts eine umfassende Untersuchung gegen ihn durchführte.

Um potenzielle Kinderschänder besser untersuchen zu können, erließ die Polizei außerdem einen Durchsuchungsbefehl an Google für alle Kontoinformationen, Videos, Fotos, Standortdaten, Internetsuchberichte und mehr von Mark. Für Mark ist das wirklich eine Katastrophe, und wenn die polizeilichen Ermittlungen fanatischer wären, befürchte ich, dass nicht einmal die Arbeit getan wird.

Glücklicherweise bestätigte die Polizei nach sorgfältiger Untersuchung, dass der Vater keine Sexualverbrechen gegen Kinder hatte.

Der Vater ist unschuldig, aber Google ist starr. Selbst die Vorlage eines polizeilich nachgewiesenen Unschuldsberichts ermöglichte es ihm nicht, erfolgreich bei Google Berufung einzulegen, um sein Konto zurückzubekommen. Die Fotoinformationen, die er einst auf seinem Konto hinterlassen hat, wurden vollständig gesperrt und sind nicht mehr einsehbar. Ich sehe nur die Erinnerungen von Google —

Ihr Konto wurde deaktiviert, da es schädliche Inhalte enthält, die ernsthaft gegen die Richtlinien von Google verstoßen und möglicherweise illegal sind.

Es ist sinnlos, eine Entsperrung zu beantragen, Sie können nur Ihre E-Mail-Adresse ändern, Ihre Telefonnummer ändern und in der digitalen Welt von vorne anfangen. Die New York Times berichtete von zwei normalen Usern, die beide Geschlechtsorgane von Kindern für die Online-Konsultationen ihrer Kinder fotografierten und zu illegalen Konten verurteilt wurden, deren Konten sie bis heute nicht abrufen konnten.

Sie sind nicht einmal außergewöhnlich. Im Jahr 2021 meldete Google 621.583 Fälle an die CyberTipLine des NCMEC (The Child Sexual Abuse Reporting Project). NCMEC hat die örtlichen Strafverfolgungsbehörden über 4.260 potenzielle Opfer informiert und die Polizei gebeten, bei den Ermittlungen zu helfen und die Kinder zu retten, wenn sie weiter verletzt werden.

Es klingt wie eine gute Geschichte der Technologie, um Verbrechen rechtzeitig zu stoppen und zu verhindern, aber wenn diese Liste Minderjährige enthält, die nur um Beratung bitten, wie Marks Kinder, ist es eine traurige Geschichte von „Fangt tausend und erwischt aus Versehen einen“.

Von allen Bereichen der technischen Ermittlungen sind Sexualverbrechen an Kindern die einzige Ausnahme

Es ist nur so, dass, obwohl es einen Fehler gibt, Google offensichtlich nicht die Absicht hat, ihn zu ändern. Es entsperrt nicht nur polizeilich zertifizierte unschuldige Benutzerkonten nicht, es beabsichtigt auch nicht, diesen fehlerhaften Zensurmechanismus zu stoppen.

Google-Sprecherin Christa Muldoon sagte: „Wir befolgen das US-Recht, um zu definieren, was ein CSAM ist, und verwenden eine Kombination aus Hash-Matching-Technologie und künstlicher Intelligenz, um es zu identifizieren und von unserer Plattform zu entfernen. Unser Team von Kindersicherheitsexperten wird es überprüfen. Der Inhalt wird auf Richtigkeit gekennzeichnet, und Kinderärzte werden konsultiert, um sicherzustellen, dass wir Situationen identifizieren können, in denen Benutzer medizinischen Rat einholen könnten.“

Das Problem ist, dass das Überprüfungsteam von Google keinen medizinischen Hintergrund hat und nicht unbedingt einen spezialisierten Kinderarzt konsultiert, wenn es jeden Fall überprüft. Daher kann man sagen, dass Fehleinschätzungen in diesem Prozess unvermeidlich sind.Das einzige, was den Einfluss solcher Fehleinschätzungen verringern kann, ist das Urteil professioneller Institutionen und die sekundäre Überprüfung durch Strafverfolgungsbehörden.

Aber für diejenigen, die falsch eingeschätzt wurden, ist dies wirklich eine Katastrophe. Wegen dieser Fehleinschätzung wurde Ihr wichtiges Konto gesperrt; wegen dieser Fehleinschätzung wurden Sie von der Polizei untersucht; wegen dieser Fehleinschätzungen können Menschen in Ihrem Umfeld auch getönte Brillen tragen, wenn sie Sie sehen.

Jon Callas, Direktor für Technologieprogramme bei der Electronic Frontier Foundation EFF, sagte den Medien, dass Googles Ansatz aufdringlich sei. „Das ist der Albtraum, den wir alle fürchten – sie werden unsere Familienalben scannen und wir werden in Schwierigkeiten geraten.“

Dies ist jedoch nicht nur ein Problem für Google, da fast alle Technologiegiganten ungewöhnlich aggressiv sind, wenn es um CSAM-Inhalte geht. Wie Facebook und Google verfügt auch Amazon über einen Mechanismus für künstliche Intelligenz und menschliche Überprüfung.Es wurde festgestellt, dass verdächtige Benutzer URLs, Bilder und Chat-Funktionen löschen oder deaktivieren und Konten streng sperren. Im Jahr 2021 reichte Amazon außerdem 33.848 CSAM-Berichte beim NCMEC ein . Was die Privatsphäre anbelangt, so scheint sie in dieser Kriminalgeschichte zur Bekämpfung der Technik ignoriert zu werden.

Unter den Geschichten zur Verteidigung der Privatsphäre der Benutzer ist die Weigerung von Apple, das „Entsperren zu unterstützen“, am beeindruckendsten.

Damals kam es in den USA zu einem schweren Terroranschlag auf eine Wohlfahrtseinrichtung, bei dem der Mörder auf der Flucht ums Leben kam. Bei den Ermittlungen stellte die Polizei fest, dass der Mörder mit der Extremistengruppe "Islamischer Staat" im Nahen Osten über verschlüsselte Kommunikation auf dem Handy kommunizierte, aber weil das Handy ein Passwort hatte, konnte das Gericht nur den iPhone-Hersteller Apple dazu auffordern Unterstützung der Regierung bei der Entsperrung. Aber Apple kündigte öffentlich seine Weigerung an, der Anordnung nachzukommen, und berief sich auf den Schutz der Privatsphäre der Benutzer: „Wenn die Regierung den All Writs Act anwendet, um das Entsperren des iPhones zu erleichtern, hat sie die Möglichkeit, sich in das Gerät eines jeden zu hacken und an seine Daten zu kommen. und die Regierung wird diesen Eingriff in die Privatsphäre verlängern können.“

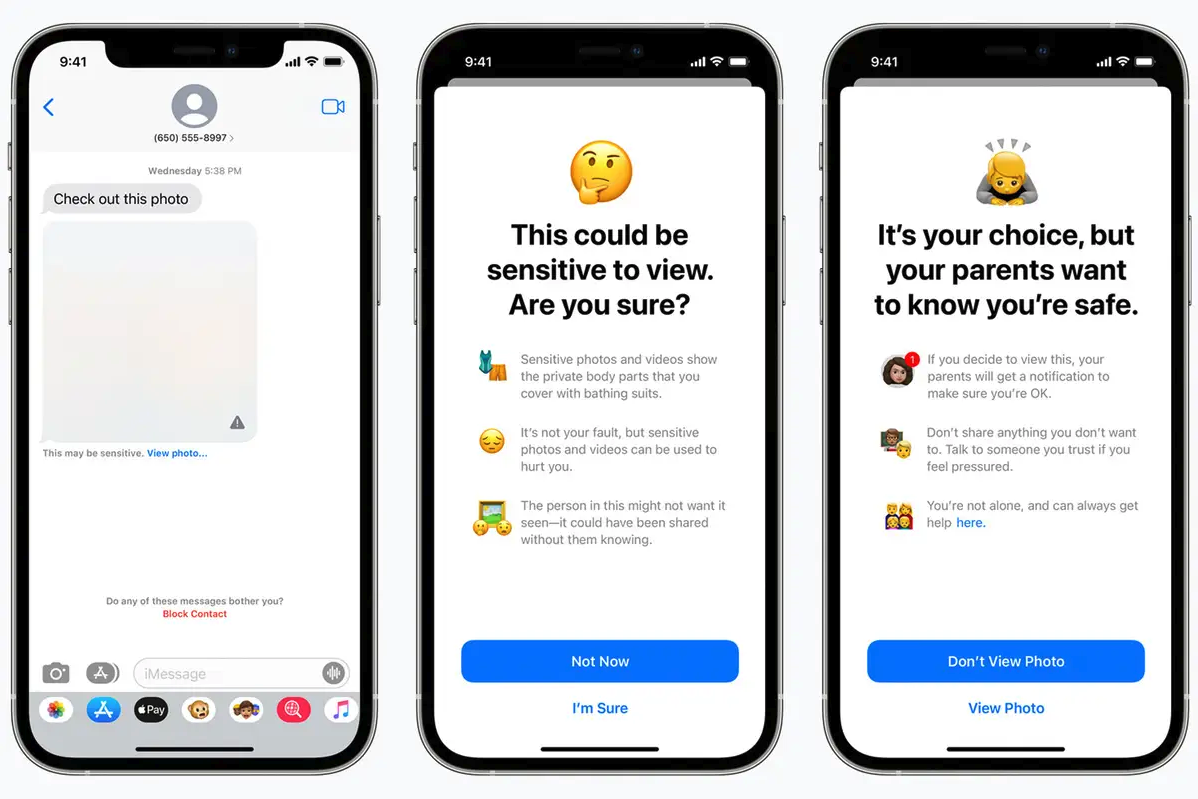

Aber selbst Apple, das sich zu Recht geweigert hat, die iPhones der Nutzer zu entsperren, wurde im Bereich der Sexualverbrechen von Kindern nicht erschüttert. Wie Google hat Apple darüber nachgedacht, ein neues Tool zum Scannen der iCloud-Fotos eines Benutzers zu verwenden, das mit der bestehenden Bilddatenbank von NCMEC übereinstimmen würde, und wenn genügend ähnliche Bilder gefunden würden, würden sie einem Betreiber zur Überprüfung übergeben, was würde benachrichtigen Sie dann NCMEC.

Apple plante damals auch die Einführung einer neuen iMessage-Funktion, die „Kinder und ihre Eltern warnen soll, wenn [Kinder] sexuell explizite Fotos erhalten oder senden“. Kinder unter 13 Jahren, die Bilder empfangen oder senden, werden die Eltern warnen, und alle Kinderbenutzer erhalten ebenfalls eine Warnung, wenn sie im Begriff sind, verdächtige pornografische Bilder zu empfangen oder zu senden.

Dieser Trend der Veränderung wurde kurz darauf gestoppt, weil der Widerstand zu laut war. Die EFF glaubt, dass die neue Änderung „eine Hintertür zu Ihrem Privatleben öffnen könnte … weniger, nicht besser, Privatsphäre für alle Benutzer von iCloud Photos.“ Sogar Snowden sagte, dass „egal wie gut gemeint, Kinderpornografie heute gescannt werden kann , scannen Sie morgen alles."

Apple hat den Teil zum Scannen von Bildern schließlich zurückgestellt, aber die optionale Funktion beibehalten, Kinderkonten in den Familienfreigabeplan aufzunehmen. Eltern können die Funktion zum Analysieren von Bildern auf Nacktbilder für ihre Kinder selektiv aktivieren, und wenn ein Nacktbild erkannt wird, wird es unscharf.

Sogar Apple will die CSAM-Erkennung zu seinen eigenen Produkten hinzufügen, zum großen Teil, weil es eine rote Linie ist – ob es sich um normale Benutzer, Strafverfolgungsbehörden oder Plattformen handelt, sie haben in dieser Angelegenheit eine extrem geringe Toleranz.

Dies bedeutet auch, dass, wenn Sie wirklich die technische Zusammenarbeit von Technologieunternehmen benötigen, die Entscheidung, zuerst mit Fällen von Sexualstraftaten an Kindern zusammenzuarbeiten, mehr öffentliche Unterstützung erhalten wird.

Eine Aktualisierung des britischen Online-Sicherheitsgesetzes sieht vor, dass Nutzer-zu-Nutzer-Dienstanbieter sich bemühen müssen, alle geteilten Inhalte der sexuellen Ausbeutung und des Missbrauchs von Kindern der National Crime Agency zu melden. Die Gesetzesänderung stellt klar, dass Unternehmen Software entwickeln sollten, die Informationen, einschließlich Ende-zu-Ende-verschlüsselter Anrufe, überprüfen kann, um proaktiv Material von Sexualstraftätern von Kindern zu erkennen und es den Behörden zu melden – oder mit Sanktionen zu rechnen.

Es ist nur so, dass die Geschichte von Google uns sagt, dass selbst wenn diese Funktion reibungslos läuft, die Gefahr des „irrtümlichen Tötens“ besteht und jede versehentliche Verletzung unschuldigen Benutzern Schaden zufügt. Technologie kann möglicherweise nicht alle Probleme lösen: Die uns vertrauten künstlichen Intelligenzen und Algorithmen sind angesichts schwieriger gesellschaftlicher Probleme noch zu „einfach“, und es ist schwierig, sich auf eine einzige Technologie zu verlassen, um potenzielle oder bestehende Straftaten aufzudecken .

Der Eingriff der Technik kann sogar neue Probleme in das ursprünglich schwierige Umfeld bringen und ist nicht unbedingt ein gutes Ergebnis, wenn die ursprüngliche Absicht gut ist. Schließlich ist der Weg zur Hölle manchmal mit guten Absichten gepflastert.

Das Titelbild stammt aus "Internet Purgatory: Expose Room N"

#Willkommen beim offiziellen WeChat-Konto von Aifaner: Aifaner (WeChat: ifanr), weitere aufregende Inhalte werden Ihnen so bald wie möglich zur Verfügung gestellt.

Liebe Faner | Ursprünglicher Link · Kommentare anzeigen · Sina Weibo