Einer der berühmtesten Bösewichte der Filmgeschichte wird künftig „keine menschlichen Worte sprechen“.

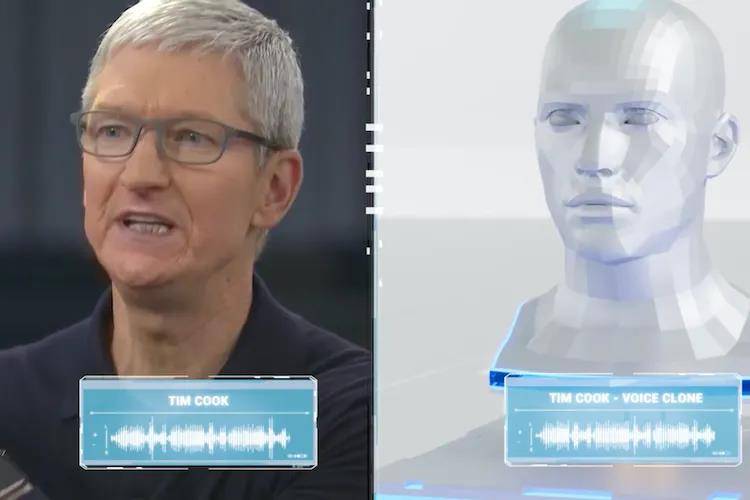

In Ang Lees Action-Science-Fiction-Film Gemini Man steht der Regierungsagent Henry kurz vor seiner Pensionierung, als er von einem 23 Jahre jüngeren Klon gejagt wird.

Um diesen Effekt zu erzielen, verwendete Ang Lee Motion-Capture-Spezialeffekte, um das menschliche Gesicht sanft wiederherzustellen und Will Smith „zu verjüngen“. Auch ein junger Mann mit „perfekter 23-jähriger Haut“ steuerte seine Daten zum Klon bei.

Niemand ist für immer jung, und jemand ist immer jung.

Aber „digitale Doppelgänger“ können gierig sein: Sie haben nicht nur eine zeitlose Haut, sondern auch eine zeitlose Stimme.

Beschwöre die Zeitmaschine

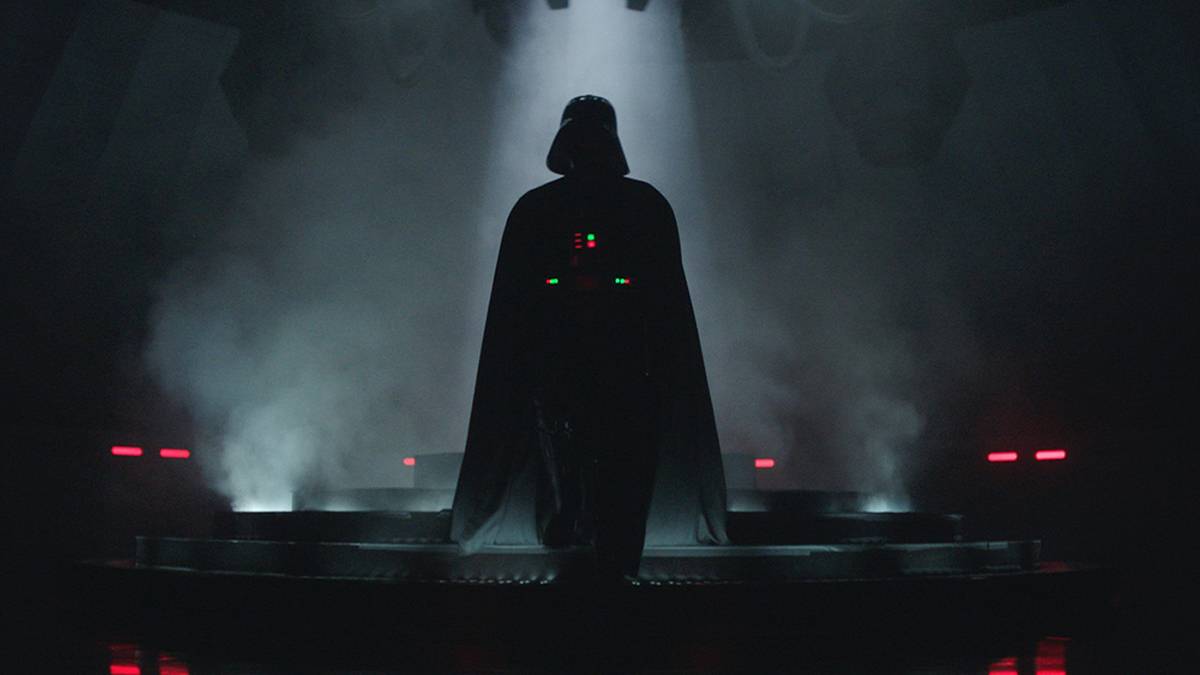

Darth Vader aus "Star Wars", der aufgrund seiner körperlichen und geistigen Zerstörung auf die dunkle Seite der Macht geriet, ist der Bösewicht Nummer eins in der ursprünglichen Trilogie und auch der widersprüchlichste und tragischste Charakter der Star Wars-Serie .

Im Jahr 2003 stufte das American Film Institute Darth Vader als drittgrößten Filmschurken des Jahrhunderts ein, hinter Hannibal aus „Das Schweigen der Lämmer“ und Norman Bates aus „Psycho“.

James Earl Jones ist die Stimme von Darth Vader, seit Lucas 1977 den ersten „Star Wars“ veröffentlichte, und seine Stimme ist für fast die Hälfte des Lebens eines Menschen zu einer Figur geworden.

▲ Bild von: screenrant

Darth Vaders kraftvolle, aber leicht gedämpfte Stimme, gepaart mit dem Geräusch tiefer Atemzüge, jagte Schauer über den Rücken.

Aber die Menschen werden irgendwann alt, und Jones wird dieses Jahr 91 Jahre alt, und es ist an der Zeit, darüber nachzudenken, seine Karriere als Synchronsprecher zu beenden.Er beschloss, die Stimme an das ukrainische Startup Respeecher zu lizenzieren.

Mithilfe früherer Aufnahmen und proprietärer KI-Algorithmen kann Respeecher neue Zeilen aus alten Stimmen erstellen.

▲ Respeecher Bild von: invers

Jüngste Errungenschaft ist der Star-Wars-Ableger „Obi-Wan Kenobi“ , der im Juni dieses Jahres endete.

In der Show rekonstruiert Respeecher die Stimme von Jones von vor Jahrzehnten und nicht seine echte Stimme, die in Star Wars: The Rise of Skywalker von 2019 mit dem Alter gealtert ist.

Für einen Charakter wie Darth Vader können 50 Zeilen fast 10.000 Dateien erfordern, um hin und her zu wechseln, und die meiste Arbeit wird für Dialogänderungen und die Feinabstimmung aufgewendet.

Ein interessantes Detail ist, dass in Darth Vaders Obi-Wan Kenobi-Episode 3 Respeecher ebenfalls genannt wurde .

▲ Bild von: Lucasfilm

Dies ist nicht das erste Mal, dass Respeecher mit Lucasfilm zusammenarbeitet, es „spricht“ auch eine jüngere Version von Luke Skywalker in den Star Wars-Spinoffs „The Mandalorian“ und „The Book of Boba Fett“.

Mark Hamill, der Luke Skywalker in der Star Wars-Trilogie spielte, die von 1977 bis 1983 lief, wird dieses Jahr ebenfalls 70 Jahre alt.

In der letzten Folge der zweiten Staffel von „The Mandalorian“ erschien Luke Skywalker, der weniger als 20 Jahre alt war. Das Bild wurde von der Visual-Effects-Firma Lola VFXmit Deepfake und Doubles gemacht, und die Stimme war „Clone“. von Respeecher.

▲ „Das Buch von Boba Fett“ Luke Skywalker CGI.

▲ 1983 „Star Wars VI“ Luke Skywalker.

Respeecher gibt stundenlange Aufnahmen in hoher Qualität ein und analysiert die Sprache mit KI-Sprachsynthesesoftware und Audio-Super-Resolution-Algorithmen, bis das System „klonen“ kann.

So wie das Klonen von Schafen DNA erfordert und die geklonte Stimme Eingabe vor Ausgabe hat, sind Details wie der Sprechstil und die Höhen und Tiefen der Aufnahme sehr wichtig.

Diese Arbeit ist also immer noch sehr relevant für die Menschen. „Technologie kann noch keine Aufführungen erschaffen.“ Ohne vergangene Live-Action-Aufführungen wäre Respeecher hilflos.

Aus dieser Perspektive ist die KI von Respeecher wie ein klingendes Gerät in einer Zeitmaschine – sie stellt einen bestimmten Moment in der Vergangenheit einer Person nach .

▲ Luke Skywalker in The Mandalorian.

Um den jungen Skywalker wieder zum Leben zu erwecken, hat Respeecher Mark Hamills Voiceovers, Interviews, Dialogbeilagen, Radiosendungen und mehr aus dem Jahr 1983 gesammelt.

Hier ist eine weitere Schwierigkeit: Daten aus fast 40 Jahren so klingen zu lassen, als wären sie gestern aufgezeichnet worden.

Am Ende sagte Luke Skywalker in den beiden Spinoffs nur ein paar Zeilen. Es ist jedoch nicht erforderlich, die kurze und die lange Sprache zu quantifizieren, um sicherzustellen, dass die synthetisierte Sprache nicht von der ursprünglichen Sprache zu unterscheiden ist und das Publikum sich überhaupt nicht bewusst ist, ob sie echt ist oder nicht, was Respeecher will.

Das 2018 gegründete Startup hat ein einfaches Ziel: die ahnungslose menschliche Sprache zu klonen.

Überwindung von Schmerz und Leben und Tod

Menschen werden begrenzt geboren und können Alter, Krankheit und Tod nicht entfliehen, aber Technologie kann die Grenzen des physischen Körpers erweitern.

Es ist nicht das erste Mal und es wird nicht das letzte Mal sein, dass eine Promi-Stimme geklont wird.

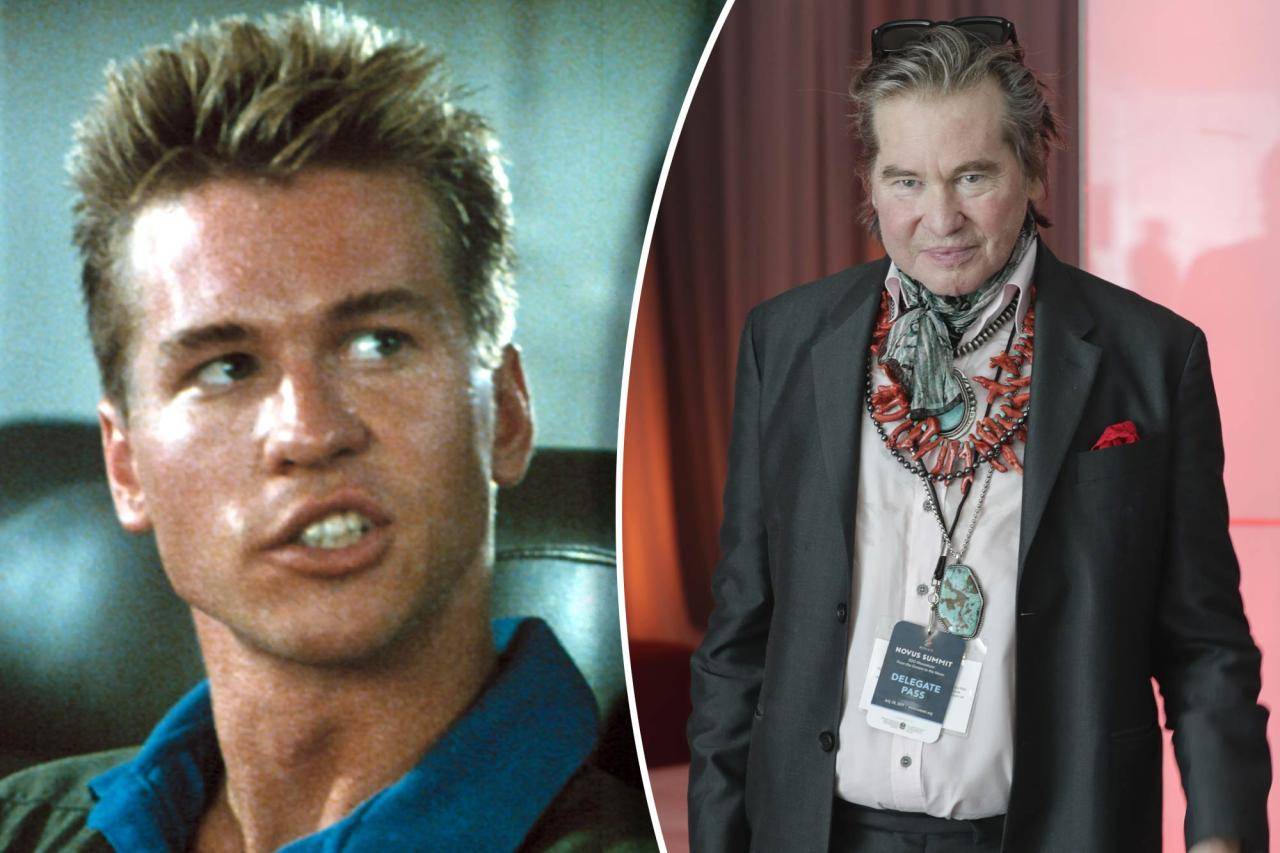

Die Veröffentlichung von „Top Gun: The Lone Ranger“ im Jahr 2022 ist eine Fortsetzung von „Top Gun“ aus dem Jahr 1986, in dem „Iceman“ Kazansky erneut vom 62-jährigen Val Kilmer auf die Leinwand gebracht wurde.

Aber es war nicht einfach, zurückzukommen, und Kilmer verlor für immer seine Stimme, seit er 2014 wegen Kehlkopfkrebs behandelt wurde.

Daher orientiert sich das Drehbuch von „Top Gun: The Lone Ranger“ an Kilmers wahrem Leben, „Iceman“ leidet ebenfalls an Krebs und kommuniziert durch Tippen und spricht im Film nur eine kurze Zeile.

▲ Bild von: Seite 6

Im wirklichen Leben wurde Kilmers Stimme von der KI „wiederhergestellt“. Im Jahr 2020 begann Kilmer mit dem KI-Sprachunternehmen Sonantic zusammenzuarbeiten .

Nachdem Sonantic stundenlang altes Filmmaterial erhalten hat, entfernt es zunächst Hintergrundgeräusche, ohne den Sprachinhalt zu zerstören, generiert dann ein Skript aus dem Audio, kombiniert Audio und Text Stück für Stück, und die Sprach-Engine verwendet diese Daten, um ein Sprachmodell zu trainieren.

Die Schwierigkeit besteht darin, dass Kilmer etwa zehnmal weniger Daten bereitstellte als bei früheren Projekten. Zu diesem Zweck arbeitete Sonantic an neuen Algorithmen, generierte schließlich mehr als 40 verschiedene Sprachmodelle und übergab das beste an Kilmer.

▲ Bild von: vanityfair

Mit einem benutzerdefinierten Sprachmodell geben Kilmer und sein Team Text ein, wählen den geeigneten Modus aus und passen Parameter wie Tonhöhe, Rhythmus und mehr an, um eine lebensechte Kommunikation zu erreichen.

Es ist nicht nur eine technologische Errungenschaft, es geht um menschliche Kommunikation und Verbindung. Kilmer selbst erwähnte in einer Erklärung:

Als Menschen ist die Fähigkeit zur Kommunikation das Herzstück unserer Existenz, und die Auswirkungen von Kehlkopfkrebs erschwerten es anderen, mich zu verstehen. Es war ein ganz besonderes Geschenk, die Möglichkeit zu haben, meine Geschichte mit einer authentischen und vertrauten Stimme zu erzählen.

Auch hierzulande gibt es solche Beispiele. Im Jahr 2021 nutzte Himalaya die Sprachsynthesetechnologie , um den verstorbenen Meister Shan Tianfang „wieder sprechen“ zu lassen; im Jahr 2018 verwendete der Dokumentarfilm „Innovative China“ KI, um die Stimme des Synchronmeisters Li Yi wiederherzustellen.

Wenn Sie also Spuren in der Welt hinterlassen haben, können Sie sich nicht einfach „ausziehen und Ihre Verdienste und Ihren Ruhm verbergen“.

Für Promis, die noch ihren Lebensunterhalt bestreiten müssen, können geklonte Stimmen ein „Weg zum Himmel“ sein. Wenn das KI-Gesichtsveränderungsmodell Deepfake Prominenten erlaubt, ihre Gesichter zu „mieten“, kann damit viel Geld verdient werden, und die Stimmmodelle sind vergleichbar.

Sonantic, das Kilmers Stimme "restauriert", hat ein anderes Geschäft: Soundmodelle für Schauspieler mit normaler Stimme zu erstellen.

▲ Bild von: dem Bankett

Die Plattform stellt zunächst Einstellungsskripte bereit, die Schauspieler zeichnen die Leistung dieser Skripte auf und geben dann das aufgezeichnete Audio in die Sprach-Engine ein und verwenden die Engine, um das KI-Modell zu trainieren. Am Ende, wenn der synthetische Sound kommerzialisiert wird, können die Schauspieler im Liegen am Gewinn beteiligt werden, ohne es selbst tun zu müssen oder sich Sorgen machen zu müssen, arbeitsunfähig zu werden.

Im Mai 2021 startete auch das amerikanische KI-Technologieunternehmen Veritone eine ähnliche Plattform Marvel.AI . Das Unternehmen glaubt, dass „für Sportler, Schauspieler und Influencer die Stimme ein großer Vorteil für ihre persönliche Marke ist“.

▲ Bild von: Veritone

Aber das ist aus Faulheit unvermeidlich.Wenn Prominente nicht bereit sind, sich selbst zu unterstützen, warum sollten die Verbraucher dann dafür bezahlen? Veritone empfiehlt die Schaffung von Industriestandards, wie z. B. die Information der Zuhörer im Voraus, dass es sich um synthetische Sprache handelt, das heißt, „man ist bereit zu kämpfen und man ist bereit zu leiden“.

Mit Technologie und Plattformen können das Klonen von Prominenten und Leihstimmen eine Industriekette sein, die auch eine Manifestation der Technologie ist, die physische und zeitliche Einschränkungen überschreitet.

Ist die Zukunft für alle, die einen „Voice-Stellvertreter“ haben, weit entfernt?

Zugegeben, das Klonen von Stimmen ist nichts Neues, aber es erfordert immer noch einen immer realeren, einfacheren Prozess, und es ist noch lange nicht das Ende.

Sprachklone werden immer beliebter in Ecken, die wir sehen oder nicht sehen können, nicht nur ein Spiel für ein paar Leute wie Prominente, Stars usw.

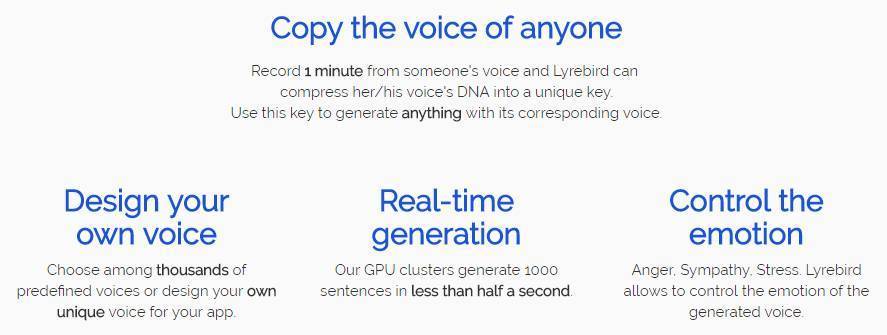

Im Jahr 2017 entwickelte das kanadische KI-Startup Lyrebird eine Sprachsynthesetechnologie und behauptete, dass ihr Algorithmus die Stimme eines jeden mit einem 1-minütigen Audiobeispiel klonen könne.

▲ Lyrebird.

1 Minute ist eine erstaunliche Zahl. Adobes Project VoCo benötigte damals mindestens 20 Minuten Sample-Audio.

In dem von Lyrebird gegebenen Beispiel sprachen und lachten Hillary, Clinton und Trump zusammen und wünschten Lyrebird eine glänzende gemeinsame Zukunft. Ihre Stimmen und Intonationen sind immer noch etwas anders als bei echten Menschen, und der mechanische Sinn ist etwas schwerfällig, aber es reicht aus, um die Augen der Menschen zum Leuchten zu bringen.

Lyrebird sagt, dass das Generieren von Stimmabdrücken eine beträchtliche Rechenleistung erfordert, aber sobald dies erledigt ist, ist das Produzieren von Sprache einfach und erstellt tausend Sätze in weniger als einer halben Sekunde.

Das ist wie eine Prophezeiung: Überschreiten Sie die Schwelle von Realität und Maschinerie, und dann wird alles glatt sein.

Abgesehen davon, dass weniger Sample-Audio benötigt wird, ist das Klonen von Stimmen bereits in die kreativen Tools integriert, die Ihnen zur Verfügung stehen.

▲Beschreiben.

Descript, ein amerikanisches Audio- und Videobearbeitungsunternehmen, hat eine Podcast-Bearbeitungsfunktion „Overdu“ entwickelt, die die Stimme des Erstellers klonen kann, und der Ersteller kann die Wörter eingeben, die er benötigt, um neues Audio mit der Originalstimme zu erzeugen, was schnell praktisch ist Ändern von Podcasts.

Aber es ist auch alles andere als perfekt. Ein Reporter von The Verge stellte fest, dass einerseits viel Audio vorab aufgezeichnet werden muss, um KI zu trainieren; andererseits fehlt es dem erzeugten Audio an Emotion und Kadenz, aber es klingt wie er selbst, das ist seltsam und unerklärlich vertraut.

Während überall Startups aus dem Boden schießen, haben sich die großen Tech-Unternehmen stark angesammelt.

Auf der re:MARS-Konferenz von Amazon im Juni sagte der Chefwissenschaftler von Amazon, Rohit Prasad, Amazon entwickle eine Technologie, die es seiner intelligenten Assistentin Alexa ermöglichen würde, jede Stimme mit weniger als einer Minute Audio zu imitieren .

▲ Bild von: techcrunch

Jeder schließt natürlich verstorbene Verwandte ein. Amazon führte auch eine ähnliche Demonstration durch: Ein Kind sagte Alexa, sie solle sich die Gute-Nacht-Geschichte „Der Zauberer von Oz“ anhören, und das Geräusch, das aus dem Lautsprecher kam, war nicht das übliche mechanische Geräusch, sondern die Stimme einer verstorbenen Großmutter.

Amazon hat keine weiteren Details zu den neuen Funktionen von Alexa preisgegeben, aber die zugrunde liegende Technologie gibt es schon seit mehreren Jahren.

Es ist absehbar, dass Voice Clones menschliche Stimmen zwar nicht wirklich ersetzen können, aber weit verbreitet sein werden, wie z. B. in Hörbüchern, Sprachassistenten, Videospielen usw.

Sonantic hat einmal gesagt : „Was CGI (computergenerierte Bilder) für das Sehen tut, ist das, was Sonantic für Audio tut.“ Jeder hat sein eigenes „Stimmdoppel“, und es kann ganz in der Nähe sein.

Auf der anderen Seite der Medaille sind wir vorsichtig mit „Stimmendoppelungen“.

▲ Bild von: Face2Face

Schließlich haben die politischen Lügen und die Pornografie von Deepfake viele negative Auswirkungen verursacht, sodass es nicht schwer ist, sich vorzustellen, wofür das Sprachmodell verwendet werden soll. Wenn dies nicht überprüft wird, werden wir eine Zukunft haben, in der Fotos gefälscht und Audioaufnahmen unzuverlässig sein können.

Vor einigen Monaten hat Microsoft neue KI-Ethikregeln veröffentlicht, die stark einschränken, wer synthetische Stimmen erstellen kann, wie sie verwendet werden können, und künstliche Stimmen mit einem „Wasserzeichen“ überziehen, das Missbrauch verhindert.

Respeecher, der sich „Star Wars“ verschrieben hat, veröffentlichte einmal einen „1969“ -Kurzfilm, in dem der Präsident eine großangelegte Katastrophe auf dem Mond ankündigte. Es klingt sehr „echt“, aber alles ist fake.

Der Clip endet mit einer Erinnerung: „Dieses Projekt verwendet eine Reihe von Technologien, darunter Videodialogersatz, Voice-Over-Systeme und traditionellere Videobearbeitung, um zu zeigen, wie Fehlinformationen aussehen können. Bitte überprüfen Sie Ihre Quellen.“

Respeecher versucht also nicht zu beweisen, dass Nachrichten und Geschichte manipuliert werden können.

Im Gegenteil, sie wollen die Menschen auf die Existenz und Nützlichkeit der Technologie sowie ihre Grenzen und Bösartigkeit aufmerksam machen. Jetzt, da das Rad nach vorne gerollt und mehr gesehen wurde, kann es besser reguliert und verwendet werden.

#Willkommen beim offiziellen WeChat-Konto von Aifaner: Aifaner (WeChat: ifanr), weitere aufregende Inhalte werden Ihnen so bald wie möglich zur Verfügung gestellt.

Liebe Faner | Ursprünglicher Link · Kommentare anzeigen · Sina Weibo